お疲れ様です!IT業界で働くアライグマです!

「NotebookLMは便利だけど、機密情報をクラウドに送りたくない…」

「ローカルLLMでNotebookLMのような機能を実現できないか…」

「OpenAIやAnthropicのAPIコストを抑えながらAIノートブックを使いたい…」

こんな悩みを抱えているエンジニアは少なくありません。

私自身、プロジェクトマネージャーとして社内ドキュメントの整理や技術調査を行う際、機密情報を含むドキュメントをクラウドAPIに送信することへの懸念を感じていました。

本記事では、NotebookLMのオープンソース版であるOpen Notebookを、Ollamaと組み合わせて完全ローカル環境で構築する方法を解説します。

Open Notebookの概要と特徴、Ollamaを使ったローカル環境の構築手順、実際のドキュメント分析ワークフロー、そして運用上の注意点と最適化のコツまで、私のPjM経験を踏まえてお伝えします。

Open NotebookとNotebookLMの違いを理解する

Open Notebookは、Google NotebookLMのオープンソース版として開発されたツールです。

ドキュメントをアップロードしてAIと対話しながら情報を整理・分析できるという基本コンセプトはNotebookLMと同じですが、いくつかの重要な違いがあります。

NotebookLMの特徴と制約

NotebookLMはGoogleが提供するAIノートブックサービスで、PDFやGoogle Docsなどのドキュメントをアップロードすると、AIがその内容を理解して質問に答えてくれます。

Audio Overview機能でドキュメントの内容をポッドキャスト形式で聴けるなど、ユニークな機能も備えています。

しかし、NotebookLMには以下のような制約があります。

- データがGoogleのサーバーに送信される:機密情報を含むドキュメントの取り扱いに懸念がある

- オフライン環境では使用できない:インターネット接続が必須

- カスタマイズ性が限られる:使用するモデルや処理方法を変更できない

Open Notebookのメリット

Open Notebookは、これらの制約を解消するために開発されました。

- 完全ローカル実行:データが外部に送信されないため、機密情報を安全に扱える

- モデルの選択が自由:Ollamaを通じて様々なLLMを使用可能

- コスト削減:クラウドAPIの従量課金を気にせず使い放題

- オフライン対応:インターネット接続なしでも動作する

私がPjMとして関わったプロジェクトでは、社内の技術ドキュメントや議事録を分析する際にOpen Notebookを活用しています。

クラウドAPIを使わないため、情報セキュリティ部門との調整もスムーズでした。

AIを活用したドキュメント分析の基礎を学ぶなら、ChatGPT/LangChainによるチャットシステム構築実践入門のようなLLMアプリケーション開発の書籍で全体像を把握しておくと、Open Notebookの仕組みもより深く理解できます。

ローカルLLMの活用に興味がある方は、Cursor×Ollamaで実現するローカルAI開発環境:コスト削減と高速化を両立する実践構成ガイドも参考にしてください。

Open Notebookのローカル環境構築に必要な前提条件

Open Notebookをローカル環境で動作させるためには、いくつかの前提条件を満たす必要があります。

ここでは、ハードウェア要件とソフトウェア要件を整理します。

ハードウェア要件

Open Notebookをローカルで快適に動作させるためには、以下のスペックを推奨します。

- メモリ:16GB以上(32GB推奨)

- ストレージ:SSD 50GB以上の空き容量

- GPU:NVIDIA GPU(VRAM 8GB以上)があると高速化できるが、CPUのみでも動作可能

私のチームでは、NVIDIA RTX 3060(12GB VRAM)搭載のワークステーションで運用しており、7Bパラメータのモデルであれば快適に動作しています。

ソフトウェア要件

以下のソフトウェアが必要です。

- Docker:コンテナ環境でOpen Notebookを実行

- Ollama:ローカルLLMの実行環境

- Git:リポジトリのクローン用

Ollamaのインストール

まず、Ollamaをインストールします。

Linuxの場合は以下のコマンドで簡単にインストールできます。

curl -fsSL https://ollama.com/install.sh | shmacOSの場合は、公式サイトからインストーラーをダウンロードするか、Homebrewを使用します。

brew install ollamaインストール後、Ollamaサービスを起動します。

ollama serveローカルLLM環境の構築について詳しく学びたい方は、大規模言語モデルの書籍のようなLLM関連の書籍で基礎知識を身につけておくと、トラブルシューティングの際にも役立ちます。

Dockerを使った開発環境の構築については、WSL2開発環境の最適化:パフォーマンスとセキュリティを両立する設定ガイドも参考にしてください。

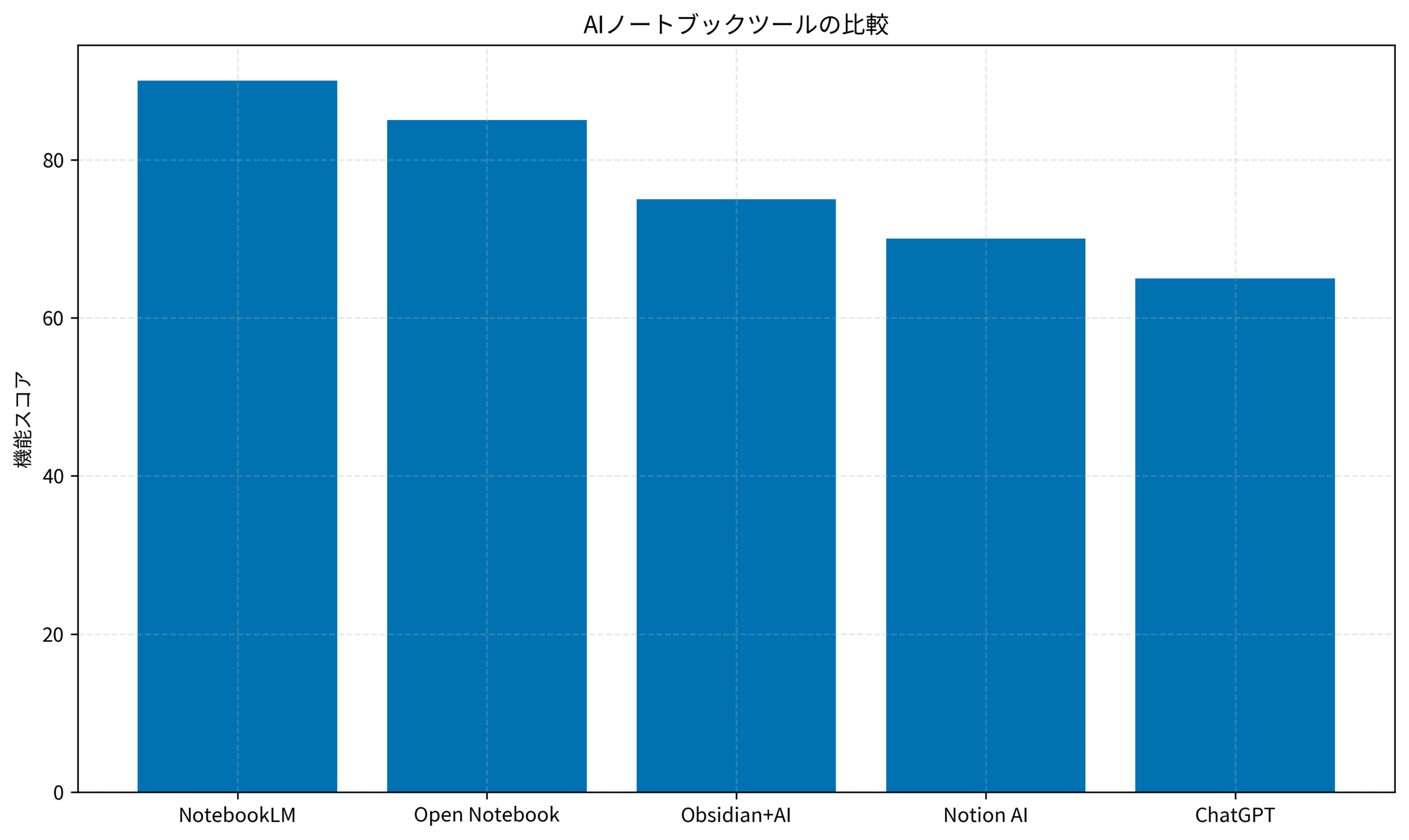

以下のグラフは、AIノートブックツールの機能を比較したものです。

NotebookLMが最も高機能ですが、Open Notebookはローカル実行という大きなメリットがあり、機密情報を扱う場面では最適な選択肢となります。

Open Notebookのインストールと初期設定

前提条件が整ったら、Open Notebookをインストールします。

ここでは、Dockerを使った構築方法とOllamaとの連携設定を説明します。

リポジトリのクローン

まず、Open Notebookのリポジトリをクローンします。

git clone https://github.com/open-notebook/open-notebook.git

cd open-notebook環境変数の設定

Open NotebookをOllamaと連携させるために、環境変数を設定します。

.envファイルを作成し、以下の内容を記述します。

# LLMプロバイダーの設定

LLM_PROVIDER=ollama

OLLAMA_BASE_URL=http://host.docker.internal:11434

# 使用するモデル

LLM_MODEL=gpt-oss:120b

EMBEDDING_MODEL=mxbai-embed-largeLLM_MODELには、Ollamaで利用可能なモデルを指定します。

私のチームでは、日本語対応のモデルを使用していますが、用途に応じて選択してください。

Dockerコンテナの起動

環境変数の設定が完了したら、Dockerコンテナを起動します。

docker compose up -d起動が完了すると、http://localhost:3000でOpen Notebookにアクセスできます。

Ollamaモデルのダウンロード

Open Notebookで使用するモデルを事前にダウンロードしておきます。

# LLMモデルのダウンロード

ollama pull llama3.2

# Embeddingモデルのダウンロード

ollama pull mxbai-embed-large 私がPjMとして運用している環境では、llama3.2(8B)を使用しています。

より高精度な回答が必要な場合は、70Bクラスのモデルを検討してください。

コンテナやAPI設計の基礎を押さえておくと、Open Notebookの運用設計にも役立ちます。Software Design (ソフトウェアデザイン) 2025年10月号 [雑誌] のようなシステム設計の解説書を一冊読んでおくと、構成のイメージがつかみやすくなります。

Pythonを使ったAI開発の基礎を学ぶなら、AI開発入門書籍でプログラミングスキルを磨いておくと、Open Notebookのカスタマイズにも役立ちます。

RAGシステムの構築については、RAGシステムのチューニング手法:検索精度と回答品質を向上させる実践的アプローチも参考にしてください。

Open Notebookを使ったドキュメント分析ワークフロー

Open Notebookの環境が整ったら、実際にドキュメントを分析してみましょう。

ここでは、ドキュメントのアップロードから質問応答までの基本的なワークフローを紹介します。

ドキュメントのアップロード

Open Notebookのダッシュボードにアクセスし、分析したいドキュメントをアップロードします。

対応しているファイル形式は以下の通りです。

- PDF:技術ドキュメント、論文、マニュアルなど

- テキストファイル:Markdown、プレーンテキスト

- Webページ:URLを指定してコンテンツを取得

ドキュメントの分析と質問

ドキュメントがアップロードされると、Open Notebookは自動的にテキストを抽出し、Embeddingモデルでベクトル化します。

その後、チャットインターフェースで質問を入力すると、関連する箇所を参照しながら回答を生成します。

私がPjMとして活用している例を紹介します。

- 技術仕様書の要約:「このドキュメントの主要な技術要件を箇条書きでまとめて」

- 議事録からのアクションアイテム抽出:「この議事録から決定事項とTODOを抽出して」

- 複数ドキュメントの横断検索:「セキュリティに関する記述をすべてのドキュメントから集めて」

ノートの作成と整理

Open Notebookでは、AIとの対話結果をノートとして保存できます。

これにより、後から参照したり、チームメンバーと共有したりすることが可能です。

AIを活用した情報整理の方法論を学ぶなら、セカンドブレインのようなナレッジマネジメントの書籍で、効果的な情報整理の考え方を身につけておくと、Open Notebookをより有効に活用できます。

LangChainを使ったAIアプリケーション開発については、FastAPI×LangChainで構築するAIバックエンド:実践的な設計パターンとプロダクション運用も参考にしてください。

Open Notebookの運用最適化とトラブルシューティング

Open Notebookを本格的に運用するためには、パフォーマンスの最適化とよくあるトラブルへの対処法を知っておく必要があります。

パフォーマンス最適化のポイント

ローカル環境でのLLM実行は、クラウドAPIと比べて応答速度が遅くなりがちです。

以下のポイントを意識することで、パフォーマンスを改善できます。

- GPUの活用:NVIDIA GPUがある場合は、CUDAを有効にしてOllamaを実行する

- モデルサイズの選択:用途に応じて7B〜70Bのモデルを使い分ける

- コンテキスト長の調整:長いドキュメントを扱う場合は、チャンクサイズを最適化する

よくあるトラブルと対処法

私のチームで遭遇したトラブルと、その解決方法を共有します。

- Ollamaに接続できない:Docker内からOllamaに接続できない場合は、

OLLAMA_BASE_URLの設定を確認してください。Dockerの場合はhost.docker.internalを使用します。 - メモリ不足でモデルが起動しない:大きなモデルを使用する場合、メモリ不足で起動に失敗することがあります。その場合は、より小さなモデル(7B程度)に切り替えるか、メモリを増設してください。

- 日本語の回答精度が低い:英語ベースのモデルでは日本語の回答精度が低くなることがあります。日本語に対応したモデル(例:ELYZA-japanese-Llama-2など)を使用することで改善できます。

セキュリティ上の注意点

Open Notebookはローカルで動作しますが、ネットワーク設定には注意が必要です。

- 外部からのアクセス制限:ファイアウォールでポート3000へのアクセスを制限する

- 認証の設定:チームで共有する場合は、認証機能を有効にする

- ログの管理:機密情報がログに残らないよう設定を確認する

セキュリティを意識した開発環境の構築については、実践サイバーセキュリティ入門講座のようなセキュリティ書籍で基礎知識を身につけておくと、安全な運用が可能になります。

MCPを使ったAI連携については、MCPサーバー開発ガイド:AIエージェントと外部システムを連携させる実装パターンも参考にしてください。

まとめ

Open Notebookは、NotebookLMのオープンソース版として、ローカル環境でAIノートブック機能を実現できる強力なツールです。

本記事で解説したポイントを振り返ります。

- Open Notebookの特徴:完全ローカル実行、モデル選択の自由、コスト削減、オフライン対応

- 環境構築:Docker + Ollamaの組み合わせで簡単にセットアップ可能

- 活用方法:ドキュメントのアップロード、質問応答、ノート作成

- 運用のコツ:GPU活用、モデルサイズの選択、セキュリティ設定

機密情報を含むドキュメントを安全に分析したい場合や、クラウドAPIのコストを抑えたい場合には、Open Notebookは最適な選択肢です。

まずは小さなドキュメントから試してみて、自分のワークフローに合った使い方を見つけてください。

ローカルAI環境の構築は、エンジニアとしてのスキルアップにもつながる取り組みです。

ぜひ本記事を参考に、Open Notebookを活用したドキュメント分析ワークフローを構築してみてください。