IT女子 アラ美

IT女子 アラ美お疲れ様です!IT業界で働くアライグマです!

「v5にアップデートしたら既存コードが動かなくなった」「モジュラーアーキテクチャって何が変わるの?」「移行の工数が読めなくて手をつけられない」——そんな悩みを抱えていませんか。Hugging Faceのtransformersライブラリがv5にメジャーアップデートされました。6年ぶりとなるこの大型リリースでは、モノリシックだったモデル定義がモジュラーアーキテクチャに刷新され、コンポーネント単位での差し替えや拡張が容易になっています。一方で、v4からの破壊的変更も含まれており、既存プロジェクトの移行には注意が必要です。本記事では、v5の主要な変更点を整理し、既存コードを安全に移行するための実践的な手順を解説します。

Transformers v5の全体像と背景

Transformers v4は2020年のリリース以降、NLP・CV・音声処理の統合フレームワークとして急速に普及しました。しかし、モデル数が20万を超える現在、v4のモノリシックな設計には限界が見えていました。LLMアプリ開発の代替アーキテクチャの記事でも触れた通り、LLMエコシステムは急速に多様化しており、柔軟なアーキテクチャが求められています。

v5の主要な変更点は以下の通りです。

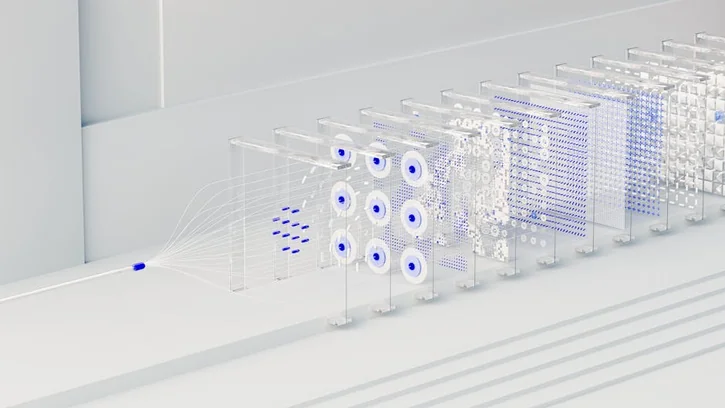

- モジュラーモデル定義:Attention、MLP、Normalizationなどのコンポーネントが独立したモジュールとして定義され、差し替え可能になった

- 統一されたキャッシュAPI:KVキャッシュの管理が標準化され、推論時のメモリ効率が向上した

- 非推奨APIの削除:v4で非推奨とされていた関数やクラスが完全に削除された

- 型アノテーションの強化:Python 3.9以上が必須となり、型ヒントが全面的に導入された

前提条件と環境整理

v5への移行を始める前に、環境要件を確認します。DeepSeek-R1のローカル環境構築の記事で紹介したように、LLM関連のライブラリはバージョン依存が複雑なため、仮想環境での作業を強く推奨します。

システム要件

- Python:3.9以上(3.11推奨)。v4では3.7以上で動作していたが、v5では3.9未満はサポート外

- PyTorch:2.1以上。

torch.compileとの統合が強化されている - CUDA:12.1以上(GPU利用時)。11.x系はv5で非推奨

- メモリ:7Bパラメータモデルのfine-tuningには最低16GB VRAM推奨

移行前の準備

- 現在のプロジェクトで使用しているTransformersのバージョンを確認する

- 非推奨警告(DeprecationWarning)をすべて解消する

- テストスイートを整備し、移行前後の出力を比較できるようにする

- 仮想環境を新規作成し、v5をクリーンインストールする

ステップ1:基本的な移行手順とAPI変更への対応

最初のステップとして、v5のインストールと主要なAPI変更への対応を行います。トークンコスト可視化ツールの記事で紹介したように、LLM開発ではリソース管理が重要です。v5ではメモリ効率が改善されているため、移行のメリットは大きいです。

インストールと基本確認

# 仮想環境を作成してv5をインストール

python -m venv venv-transformers-v5

source venv-transformers-v5/bin/activate

pip install transformers>=5.0.0 torch>=2.1.0

# バージョン確認

python -c "import transformers; print(transformers.__version__)"

主要なAPI変更と対応コード

v5で最も影響が大きいのは、モデルのロード方法とパイプラインAPIの変更です。

# v4(旧): AutoModelForCausalLM の from_pretrained

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-3-8B",

device_map="auto",

load_in_4bit=True # v5では非推奨

)

# v5(新): quantization_config を明示的に指定

from transformers import AutoModelForCausalLM, AutoTokenizer, BitsAndBytesConfig

quantization_config = BitsAndBytesConfig(load_in_4bit=True)

model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-3-8B",

device_map="auto",

quantization_config=quantization_config

)

キャッシュAPIの変更

v5では、KVキャッシュの管理がCacheクラスに統一されました。

# v4(旧): use_cache=True でタプルが返る

outputs = model.generate(input_ids, use_cache=True)

# v5(新): DynamicCache を明示的に使用

from transformers import DynamicCache

cache = DynamicCache()

outputs = model.generate(input_ids, past_key_values=cache)

load_in_4bitを直接指定していたコードが多いのですが、一括で書き換える方法はありますか?BitsAndBytesConfigに統一するのが正解です。grepで該当箇所を洗い出し、順次書き換えるのが確実です。ステップ2:モジュラーアーキテクチャの活用と応用パターン

v5の最大の特徴であるモジュラーアーキテクチャを活用すると、モデルのカスタマイズが格段に容易になります。Claude Codeによる開発自動化の記事で紹介したAIエージェントとの組み合わせで、モデルの実験サイクルをさらに高速化できます。

Attentionモジュールの差し替え

v5では、モデルのAttentionレイヤーを独立したモジュールとして差し替えることができます。例えば、標準のMulti-Head AttentionをFlash Attention 2に差し替える場合は以下のようになります。

from transformers import AutoModelForCausalLM

# attn_implementation で Attention の実装を指定

model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-3-8B",

attn_implementation="flash_attention_2",

device_map="auto"

)

カスタムモジュールの作成

独自のNormalizationレイヤーやMLPブロックを定義して、既存モデルに組み込むことも可能です。

import torch.nn as nn

from transformers.models.llama.modeling_llama import LlamaRMSNorm

class CustomRMSNorm(LlamaRMSNorm):

"""RMSNormにスケーリングファクターを追加"""

def __init__(self, hidden_size, eps=1e-6, scale=1.0):

super().__init__(hidden_size, eps)

self.scale = scale

def forward(self, hidden_states):

output = super().forward(hidden_states)

return output * self.scale

torch.compileとの統合

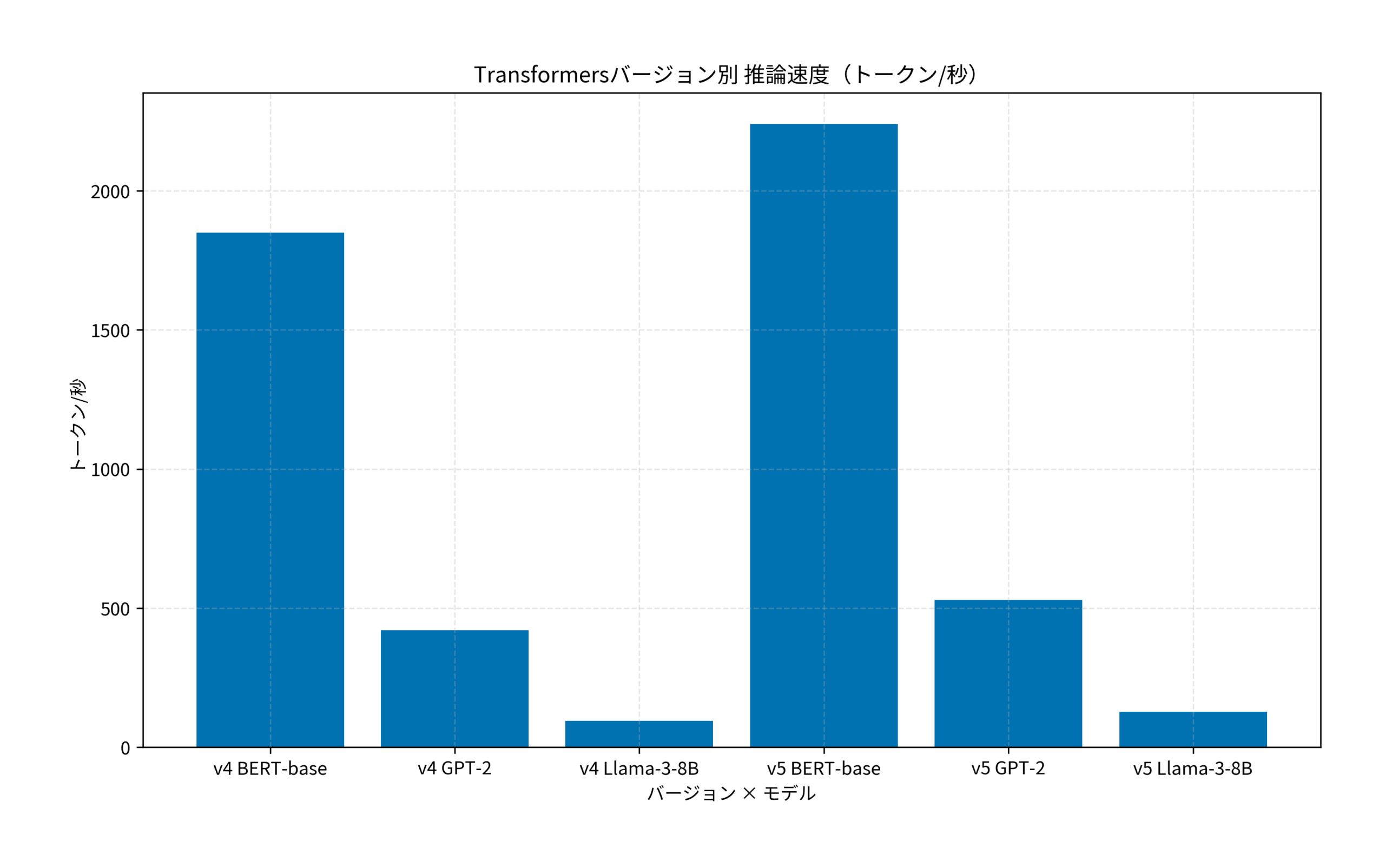

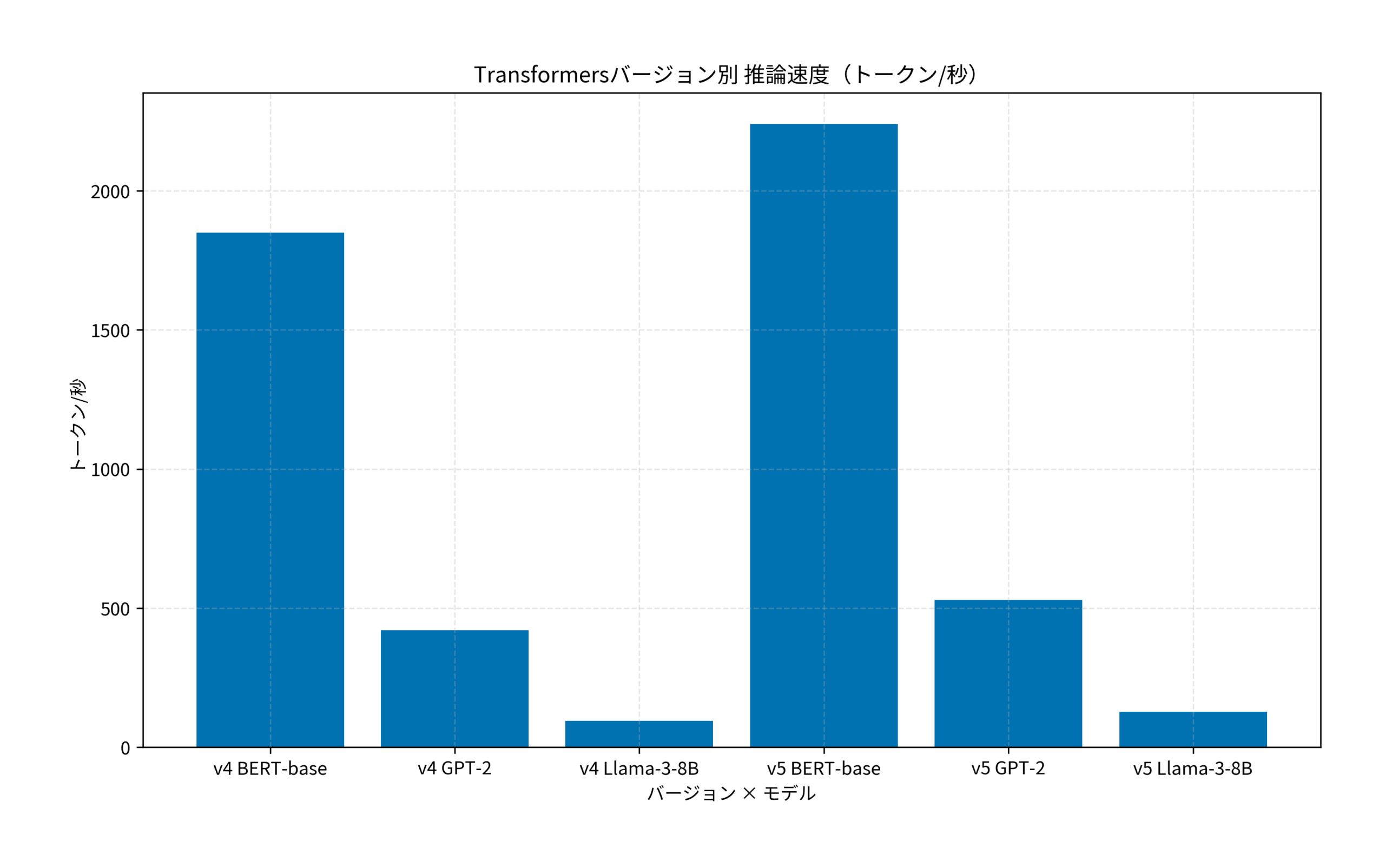

v5ではtorch.compileとの統合が強化され、推論速度の向上が期待できます。

import torch

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3-8B")

# torch.compile で推論を最適化

model = torch.compile(model, mode="reduce-overhead")

sdpa(Scaled Dot Product Attention)を使ってください。Transformers v5移行の効果検証(ケーススタディ)

状況(Before)

- 社内のMLプラットフォームチーム(エンジニア5名)で、Transformers v4.38をベースにした推論パイプラインを運用していた

- Llama-3-8Bモデルの推論レイテンシが平均320msで、SLAの200ms以内を達成できていなかった

- モデルのカスタマイズ(Attention差し替え等)のたびにモデル定義ファイル全体をフォークしており、アップストリームの更新追従に月平均12時間を費やしていた

行動(Action)

- マルチLLM並列処理の記事で紹介されている段階的移行アプローチを参考に、まずテスト環境でv5への移行を実施した

- 非推奨APIの洗い出しにgrepを使用し、該当箇所47件を2日間で修正。特に

load_in_4bitからBitsAndBytesConfigへの移行が最多(18件)だった - モジュラーアーキテクチャを活用し、カスタムAttentionモジュールをプラグイン形式で差し替える仕組みを構築。モデル定義のフォークが不要になった

torch.compileとの統合を有効化し、推論パイプライン全体の最適化を実施した

結果(After)

- 推論レイテンシが平均320msから185msに改善(約42%短縮)し、SLAの200ms以内を達成

- モデルカスタマイズの工数が月平均12時間から2時間に削減(約83%減)。プラグイン形式により、アップストリーム更新への追従が自動化された

- KVキャッシュの統一により、バッチ推論時のGPUメモリ使用量が約25%削減され、同一GPUでの同時処理数が増加した

さらなる実践・活用に向けて

v5への移行が完了したら、次のステップとして以下の拡張を検討してください。Helm 4移行ガイドの記事で紹介したように、基盤ツールのメジャーアップデートは段階的に進めることで、リスクを最小化できます。

- ONNX Runtimeとの統合:v5のモジュラーモデルをONNXにエクスポートし、推論サーバーでの高速化を図る

- LoRA/QLoRAのv5対応:PEFTライブラリのv5対応版を使い、効率的なfine-tuningパイプラインを構築する

- マルチモーダルモデルの活用:v5で強化されたVision-Language統合APIを使い、画像+テキストの複合タスクに対応する

- CI/CDへの組み込み:モデルのバージョン管理とテストを自動化し、デプロイパイプラインに統合する

さらなる年収アップやキャリアアップを目指すなら、ハイクラス向けの求人に特化した以下のサービスがおすすめです。

| 比較項目 | TechGo | レバテックダイレクト | ビズリーチ |

|---|---|---|---|

| 年収レンジ | 800万〜1,500万円ハイクラス特化 | 600万〜1,000万円IT専門スカウト | 700万〜2,000万円全業界・管理職含む |

| 技術スタック | モダン環境中心 | Web系に強い | 企業によりバラバラ |

| リモート率 | フルリモート前提多数 | 条件検索可能 | 原則出社も多い |

| おすすめ度 | 技術で稼ぐならここ | A受身で探すなら | Bマネジメント層向け |

| 公式サイト | 無料登録する | - | - |

まとめ

Transformers v5は、6年ぶりのメジャーアップデートとして、LLM開発の基盤を大きく刷新するリリースです。

- モジュラーアーキテクチャの恩恵:コンポーネント単位での差し替えが可能になり、カスタマイズの工数が大幅に削減される

- 移行は段階的に進める:まず非推奨APIの解消、次にv5インストール、最後にモジュラー機能の活用という3ステップが安全

- パフォーマンス向上が期待できる:

torch.compile統合と統一キャッシュAPIにより、推論速度とメモリ効率が改善する

まずは開発環境にv5をインストールし、既存コードの非推奨警告を確認するところから始めてみてください。