お疲れ様です!IT業界で働くアライグマです!

「チャットボットに過去の会話を覚えさせたい」「ユーザーごとの好みを学習するAIエージェントを作りたい」――こうした要望を持つエンジニアの方は多いのではないでしょうか。

私自身、PjMとしてAIエージェントを活用したプロジェクトに関わる中で、「セッションをまたいで文脈を維持する」ことの難しさを痛感してきました。単純なファイル保存では検索性が悪く、ベクトルDBだけでは「何を覚えるべきか」の判断が難しい。

そこで注目したいのがMem0です。Mem0は、AIエージェントに「人間のような記憶」を持たせるためのメモリ管理ライブラリで、LangChainとの連携も容易です。本記事では、Mem0の基本概念から実装パターンまでを解説します。

Mem0とは何か:AIエージェントのメモリ問題を解決する

Mem0は、AIエージェントに長期記憶(Long-term Memory)を持たせるためのオープンソースライブラリです。

従来のチャットボットが抱えていた「セッションが切れると会話内容を忘れる」という問題を解決します。

従来のメモリ管理の課題

AIエージェントのメモリ管理には、いくつかの一般的なアプローチがあります。

- セッション内メモリ:会話履歴をメモリに保持するが、セッション終了で消失

- ファイル保存:会話ログをファイルに保存するが、検索性が低い

- ベクトルDB:埋め込みベクトルで検索可能だが、「何を記憶すべきか」の判断が難しい

これらのアプローチには、それぞれ限界があります。

特に、「ユーザーが明示的に伝えた情報」と「会話から推測できる情報」を区別して管理することが難しいのです。

Mem0のアプローチ

Mem0は、以下の特徴を持つメモリ管理システムを提供します。

- 自動的なメモリ抽出:会話から重要な情報を自動的に抽出し、構造化して保存

- 階層的なメモリ管理:ユーザー単位、セッション単位、エージェント単位でメモリを分離

- 関連性に基づく検索:現在の文脈に関連するメモリを自動的に取得

- メモリの更新と統合:新しい情報で既存のメモリを更新し、矛盾を解消

LangChainとLangGraphによるRAG・AIエージェント[実践]入門でも解説されているように、RAGシステムでは「何を検索するか」が重要ですが、Mem0はこの問題を「何を記憶するか」のレベルで解決しようとしています。

n8nとWorkatoで比較するAIエージェント構築:ノーコード自動化ツールの選び方と実装パターンでも触れていますが、AIエージェントの実用化には「状態管理」が不可欠です。

Mem0の基本的な使い方:セットアップと初期実装

ここでは、Mem0の基本的なセットアップと、最初の実装パターンを紹介します。

インストールと初期設定

Mem0はpipでインストールできます。

pip install mem0ai基本的な使い方は非常にシンプルです。

from mem0 import Memory

# メモリインスタンスの作成

memory = Memory()

# メモリの追加

memory.add(

"私はPythonとTypeScriptが得意です",

user_id="user_123"

)

# メモリの検索

results = memory.search(

"このユーザーのプログラミングスキルは?",

user_id="user_123"

)

print(results)OpenAI APIとの連携

Mem0は内部でLLMを使用してメモリの抽出と検索を行います。

デフォルトではOpenAI APIを使用しますが、環境変数で設定できます。

export OPENAI_API_KEY="your-api-key"または、設定ファイルで明示的に指定することもできます。

from mem0 import Memory

config = {

"llm": {

"provider": "openai",

"config": {

"model": "gpt-4o-mini",

"temperature": 0.1

}

},

"embedder": {

"provider": "openai",

"config": {

"model": "text-embedding-3-small"

}

}

}

memory = Memory.from_config(config)ChatGPT/LangChainによるチャットシステム構築実践入門でも解説されているように、LLMアプリケーションでは「どのモデルを使うか」がコストとパフォーマンスに大きく影響します。

Mem0では、メモリ抽出用のLLMと埋め込みモデルを個別に設定できるため、用途に応じた最適化が可能です。

Prompt Caching入門:Claude・GPT-4oのAPIコストを50%削減する実装パターンで紹介したPrompt Cachingと組み合わせることで、さらにコストを抑えられます。

ケーススタディ:カスタマーサポートボットへのMem0導入

ここでは、私がPjMとして関わったプロジェクトで、Mem0を導入した事例を紹介します。

状況(Before)

あるSaaS企業のカスタマーサポートチャットボットを改善するプロジェクトでした。

既存のボットには以下の課題がありました。

- セッション切れで文脈喪失:ユーザーが翌日に問い合わせを再開すると、前日の会話内容を覚えていない

- 同じ質問の繰り返し:「お使いのプランは何ですか?」「OSは何ですか?」など、毎回同じ質問をしてしまう

- パーソナライズの欠如:ヘビーユーザーも初回ユーザーも同じ対応になる

行動(Action)

Mem0を導入し、以下の3層構造でメモリを管理するようにしました。

- ユーザーメモリ:契約プラン、利用OS、過去の問い合わせ傾向など、ユーザー固有の情報

- セッションメモリ:現在の問い合わせ内容、試した解決策、エラーメッセージなど

- グローバルメモリ:よくある質問パターン、効果的だった回答テンプレートなど

from mem0 import Memory

memory = Memory()

# ユーザー情報の記憶

memory.add(

"このユーザーはProプランを利用中で、macOS Sonomaを使用している",

user_id="user_456",

metadata={"type": "user_profile"}

)

# セッション情報の記憶

memory.add(

"ユーザーはファイル同期エラーで困っている。エラーコードはE-1234",

user_id="user_456",

metadata={"type": "session", "session_id": "sess_789"}

)

# 次回の問い合わせ時に関連メモリを取得

relevant_memories = memory.search(

"ファイル同期について質問があります",

user_id="user_456"

)結果(After)

導入から3ヶ月後、以下の改善が見られました。

- 初回解決率:42% → 68%(+26ポイント)

- 平均対応時間:8.5分 → 5.2分(39%短縮)

- ユーザー満足度:3.2 → 4.1(5点満点)

特に効果が大きかったのは、「同じ質問を繰り返さない」ことによるユーザー体験の向上でした。

「前回の続きですね」と認識してくれるだけで、ユーザーの印象は大きく変わります。

AI駆動開発完全入門 ソフトウェア開発を自動化するLLMツールの操り方でも強調されているように、AIの導入効果は「技術的な精度」だけでなく「ユーザー体験の向上」で測るべきです。

ruri-v3とFaissで構築するRAG実装入門:日本語特化の埋め込みモデルでベクトル検索を始めるで紹介したベクトル検索と組み合わせることで、さらに高度な検索が可能になります。

LangChainとMem0の連携パターン

Mem0はLangChainと組み合わせることで、より柔軟なAIエージェントを構築できます。

ここでは、具体的な連携パターンを紹介します。

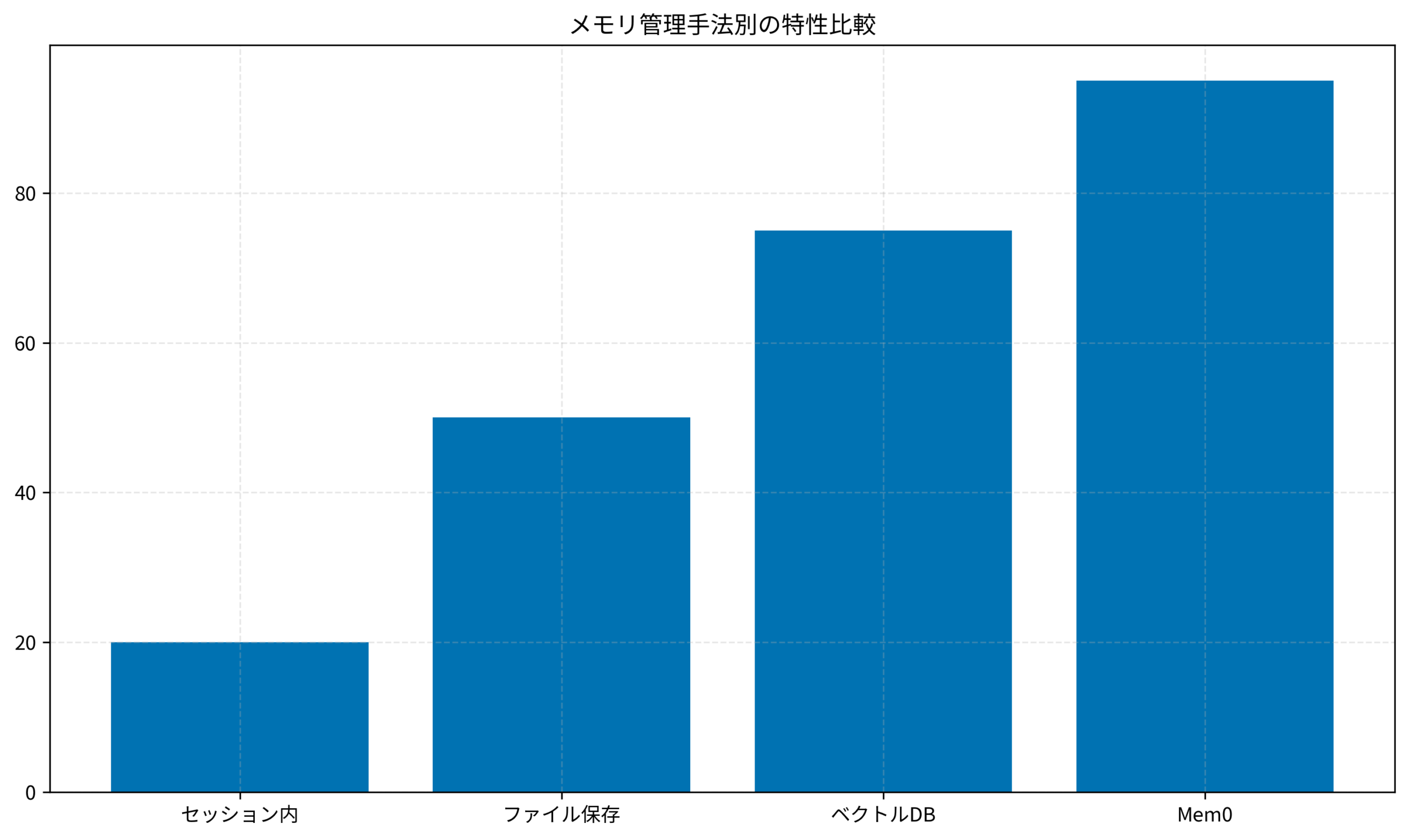

メモリ管理手法の比較

以下のグラフは、各メモリ管理手法の特性を比較したものです。

このグラフから読み取れるポイントは以下の通りです。

- セッション内メモリ:実装は簡単だが、永続性がなく長期的な学習ができない

- ファイル保存:永続性はあるが、検索性と構造化に課題

- ベクトルDB:検索性は高いが、「何を記憶するか」の判断が必要

- Mem0:自動的なメモリ抽出と階層管理により、総合的なスコアが最も高い

LangChain Agentとの統合

LangChainのAgentにMem0を組み込む基本パターンを紹介します。

from langchain_openai import ChatOpenAI

from langchain.agents import AgentExecutor, create_openai_functions_agent

from langchain.prompts import ChatPromptTemplate, MessagesPlaceholder

from mem0 import Memory

# Mem0インスタンス

memory = Memory()

# LLMの設定

llm = ChatOpenAI(model="gpt-4o-mini", temperature=0.7)

# プロンプトテンプレート(メモリを含む)

def get_prompt_with_memory(user_id: str, query: str):

# 関連するメモリを取得

memories = memory.search(query, user_id=user_id, limit=5)

memory_context = "\n".join([m["memory"] for m in memories])

prompt = ChatPromptTemplate.from_messages([

("system", f"""あなたは親切なアシスタントです。

以下はこのユーザーについて記憶している情報です:

{memory_context}

この情報を踏まえて、ユーザーの質問に回答してください。"""),

("human", "{input}"),

MessagesPlaceholder(variable_name="agent_scratchpad")

])

return prompt

# 会話後にメモリを更新

def update_memory(user_id: str, conversation: str):

memory.add(conversation, user_id=user_id)カスタムツールとしてのMem0

LangChainのToolとしてMem0を定義することで、エージェントが自律的にメモリを操作できるようになります。

from langchain.tools import Tool

from mem0 import Memory

memory = Memory()

def remember_info(info: str, user_id: str = "default") -> str:

"""情報をメモリに保存する"""

memory.add(info, user_id=user_id)

return f"記憶しました: {info}"

def recall_info(query: str, user_id: str = "default") -> str:

"""メモリから関連情報を検索する"""

results = memory.search(query, user_id=user_id, limit=3)

if results:

return "\n".join([r["memory"] for r in results])

return "関連する記憶が見つかりませんでした"

# LangChain Toolsとして定義

tools = [

Tool(

name="remember",

func=remember_info,

description="重要な情報を記憶する。ユーザーの好みや設定など"

),

Tool(

name="recall",

func=recall_info,

description="過去に記憶した情報を検索する"

)

]ソフトウェアアーキテクチャの基礎でも解説されているように、システムの拡張性は「責務の分離」によって高まります。

Mem0をToolとして切り出すことで、メモリ管理ロジックを独立してテスト・改善できます。

サーバーレスでステートフルなワークフローを構築する:Lambda Durable Functionsの設計と実装で紹介したDurable Functionsと組み合わせることで、長時間実行されるエージェントワークフローにも対応できます。

本番運用に向けた考慮事項

Mem0を本番環境で運用する際には、いくつかの考慮事項があります。

ストレージバックエンドの選択

Mem0はデフォルトでローカルストレージを使用しますが、本番環境では外部ストレージを推奨します。

from mem0 import Memory

# Qdrantをベクトルストアとして使用

config = {

"vector_store": {

"provider": "qdrant",

"config": {

"host": "localhost",

"port": 6333,

"collection_name": "mem0_memories"

}

}

}

memory = Memory.from_config(config)メモリのライフサイクル管理

メモリは無限に増え続けるため、適切なライフサイクル管理が必要です。

- TTL(Time To Live)の設定:一定期間アクセスされないメモリを自動削除

- 重要度スコアリング:頻繁に参照されるメモリを優先的に保持

- 定期的な統合:類似したメモリを統合して重複を削減

プライバシーとセキュリティ

ユーザーの個人情報を扱う場合、以下の点に注意が必要です。

- データの暗号化:保存時と転送時の暗号化を徹底

- アクセス制御:ユーザーIDによる厳格なメモリ分離

- 削除機能:ユーザーからの削除要求に対応できる仕組み

機械学習とセキュリティでも触れられているように、AIシステムにおけるデータ管理は、技術的な課題であると同時に倫理的・法的な課題でもあります。

AWSアンチパターン完全ガイド:やってはいけない設計と運用の落とし穴を回避する実践的アプローチで紹介したセキュリティのベストプラクティスも参考にしてください。

まとめ

Mem0は、AIエージェントに「人間のような記憶」を持たせるための強力なツールです。

本記事で紹介したポイントを整理すると、以下の通りです。

- Mem0の基本概念:自動的なメモリ抽出、階層的な管理、関連性に基づく検索

- LangChainとの連携:プロンプトへの組み込み、カスタムToolとしての定義

- 本番運用の考慮事項:ストレージ選択、ライフサイクル管理、セキュリティ

まずは小さなプロジェクトでMem0を試してみることをおすすめします。

ローカル環境での検証から始めて、効果を確認してから本番環境への導入を検討してください。

AIエージェントの「記憶」は、ユーザー体験を大きく左右する要素です。

Mem0を活用して、より賢く、より親切なAIエージェントを構築していきましょう。