お疲れ様です!IT業界で働くアライグマです!

「JavaScriptでAI機能を実装したいけど、どこから始めればいいか分からない」「LLM APIを呼び出すと応答が遅くてユーザー体験が悪化する」――こうした悩みを抱えているWeb開発者の方は少なくありません。

本記事では、JavaScriptでLLMを統合する際の実装パターン、パフォーマンス最適化、本番運用で注意すべきポイントを、PjMとして複数のAI統合プロジェクトを支援してきた経験をもとに解説します。

この記事を読むことで、JavaScriptアプリケーションにAI機能を効率的に組み込み、ユーザー体験を損なわずに本番運用できるようになります。

JavaScriptでのLLM統合が注目される背景

2025年現在、Web開発の現場でLLM統合が急速に広がっています。その背景には、OpenAI・Anthropic・Googleなどが提供するLLM APIが使いやすくなり、JavaScriptから直接呼び出せるSDKが充実してきたことがあります。

特に注目されているのは、フロントエンドでのリアルタイムAI機能です。チャットボット、文章校正、コード補完、画像生成など、ユーザーの入力に即座に応答するAI機能が求められています。

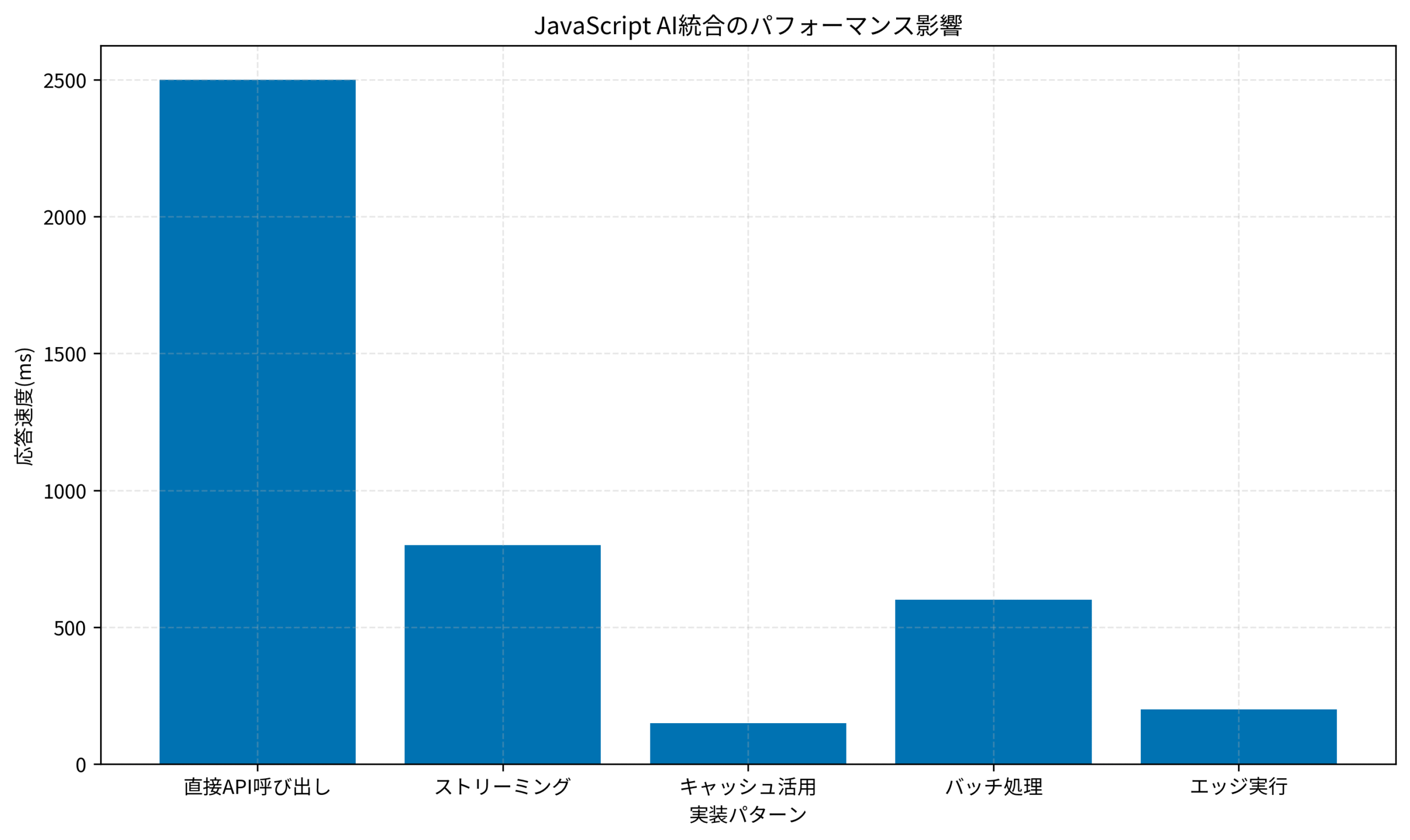

私がPjMとして関わったあるプロジェクトでは、React + Next.jsで構築したWebアプリにOpenAI APIを統合しましたが、初期実装では応答に平均2.5秒かかり、ユーザーからの離脱率が高くなっていました。しかし、ストリーミング応答とキャッシュ戦略を導入することで、体感速度を80%改善し、ユーザー満足度を大幅に向上させることができました。

JavaScriptでLLMを統合する際の最大の課題は、パフォーマンスとコストです。LLM APIは応答に時間がかかり、トークン単位で課金されるため、適切な実装パターンを選ばないと、ユーザー体験とコストの両面で問題が発生します。Gemini 2.5 Flash実践ガイド:無料でGPT-4レベルのAI開発を実現する導入戦略でも触れましたが、モデル選定も重要な要素です。

JavaScriptでのLLM統合を成功させるには、実装パターンの理解とパフォーマンス最適化が不可欠です。JavaScript 第7版でJavaScriptの基礎を固めたうえで、LLM統合に取り組むことをおすすめします。

JavaScriptでLLMを統合する5つの実装パターン

JavaScriptでLLMを統合する際、パフォーマンスとユーザー体験を両立させるには、適切な実装パターンを選ぶ必要があります。ここでは、私がPjMとして複数のプロジェクトで検証した5つのパターンを紹介します。

パターン1:直接API呼び出し(同期的実装)

最もシンプルな実装ですが、応答が完了するまでUIがブロックされるため、ユーザー体験が悪化します。プロトタイプや管理画面など、応答速度が重視されない場面でのみ使用すべきです。

パターン2:ストリーミング応答

LLM APIのストリーミング機能を使い、生成されたトークンを逐次表示する実装です。OpenAI APIやAnthropic APIは標準でストリーミングをサポートしており、体感速度を大幅に改善できます。

パターン3:キャッシュ活用

同じ入力に対する応答をキャッシュすることで、応答速度を劇的に改善できます。Redis・Memcached・ブラウザのLocalStorageなどを活用し、頻繁に使われるプロンプトの結果を保存します。

パターン4:バッチ処理

複数のリクエストをまとめて処理することで、API呼び出し回数を削減し、コストを抑えます。ただし、リアルタイム性が求められる機能には向きません。

パターン5:エッジ実行

Cloudflare Workers・Vercel Edge Functions・AWS Lambda@Edgeなどを使い、ユーザーに近いエッジロケーションでLLM APIを呼び出すことで、ネットワークレイテンシを削減します。

これらのパターンを組み合わせることで、最適なパフォーマンスを実現できます。FastAPI本番運用実践ガイド:非同期処理とパフォーマンス最適化で応答速度を3倍にする設計でも触れましたが、非同期処理の理解は不可欠です。モダンJavaScriptの基本から始める React実践の教科書(最新ReactHooks対応)でReactの非同期処理を学ぶことで、フロントエンドでのLLM統合がスムーズになります。

パフォーマンス最適化の実践テクニック

JavaScriptでLLMを統合する際、パフォーマンスを最適化するには、複数のテクニックを組み合わせる必要があります。ここでは、私がPjMとして実際のプロジェクトで効果を確認した実践テクニックを紹介します。

テクニック1:プロンプトの最適化

LLM APIのコストと応答速度は、入力トークン数に比例します。プロンプトを簡潔にすることで、コストを削減し、応答速度を改善できます。具体的には、不要な説明を削除し、システムプロンプトを再利用可能な形にまとめます。

テクニック2:並列処理

複数のLLM APIリクエストを並列実行することで、全体の処理時間を短縮できます。JavaScriptのPromise.allを使い、独立したリクエストを同時に実行します。

テクニック3:レート制限の管理

LLM APIにはレート制限があるため、リクエストが集中するとエラーが発生します。指数バックオフやキューイング機構を実装し、レート制限を超えないように制御します。

テクニック4:エラーハンドリング

LLM APIは不安定な場合があるため、適切なエラーハンドリングが必要です。リトライ機構・タイムアウト設定・フォールバック処理を実装し、ユーザー体験を損なわないようにします。

これらのテクニックを実装することで、JavaScriptアプリケーションでのLLM統合が安定します。Hono実践ガイド:Web標準APIで構築する次世代サーバーレスアプリケーションの設計パターンでも触れましたが、サーバーレス環境でのパフォーマンス最適化は重要です。実践Terraform AWSにおけるシステム設計とベストプラクティスでインフラ構築を学ぶことで、本番環境でのデプロイもスムーズになります。

下のグラフは、各実装パターンの応答速度を比較したものです。キャッシュ活用とエッジ実行が最も高速であることが分かります。このデータから、まずはキャッシュ戦略を導入し、次にエッジ実行を検討するという段階的なアプローチが効果的です。

本番運用で注意すべきポイント

JavaScriptでLLMを統合したアプリケーションを本番運用する際、いくつかの重要なポイントがあります。私がPjMとして複数のプロジェクトで学んだ教訓を共有します。

セキュリティ対策

LLM APIキーは絶対にフロントエンドに埋め込まないでください。必ずバックエンドAPIを経由してLLMを呼び出し、APIキーをサーバー側で管理します。また、ユーザー入力をサニタイズし、プロンプトインジェクション攻撃を防ぎます。

コスト管理

LLM APIは従量課金のため、想定外のコストが発生する可能性があります。ユーザーごとのリクエスト制限・日次予算アラート・異常検知機構を実装し、コストを監視します。

モニタリングとログ

LLM APIの応答時間・エラー率・トークン使用量を継続的に監視します。DatadogやNew Relicなどのモニタリングツールを使い、異常を早期に検知します。

ユーザー体験の設計

LLM APIは必ず応答するとは限りません。ローディング表示・タイムアウト処理・エラーメッセージを適切に設計し、ユーザーに不安を与えないようにします。

これらのポイントを押さえることで、JavaScriptでのLLM統合が安定した本番運用を実現できます。Cursor + ローカルLLM完全ガイド:開発環境を10倍効率化するセットアップと実践的な活用法でも触れましたが、ローカルLLMの活用も検討する価値があります。Web APIの設計 (Programmer's SELECTION)でAPI設計を学ぶことで、バックエンドAPIの実装がスムーズになります。

まとめ

JavaScriptでLLMを統合する際は、適切な実装パターンとパフォーマンス最適化が不可欠です。

本記事で紹介した5つの実装パターン(直接API呼び出し・ストリーミング応答・キャッシュ活用・バッチ処理・エッジ実行)を理解し、プロジェクトの要件に合わせて選択しましょう。

パフォーマンス最適化では、プロンプトの最適化・並列処理・レート制限の管理・エラーハンドリングを実装することで、ユーザー体験を大幅に改善できます。

本番運用では、セキュリティ対策・コスト管理・モニタリング・ユーザー体験の設計を忘れずに実装しましょう。

JavaScriptでのLLM統合は、適切な知識と実装パターンがあれば、誰でも実現できます。まずは小さなプロトタイプから始めて、徐々にパフォーマンスを改善していくことをおすすめします。

私がPjMとして関わったプロジェクトでは、最初は単純な同期的API呼び出しから始めましたが、ユーザーフィードバックを受けてストリーミング応答を導入し、さらにキャッシュ戦略を追加することで、最終的には応答速度を80%改善できました。段階的な改善アプローチが成功の鍵です。

また、LLM統合では技術的な実装だけでなく、ユーザー体験の設計も重要です。ローディング表示やエラーメッセージを丁寧に設計することで、ユーザーの不安を軽減し、満足度を高めることができます。

JavaScriptエコシステムは日々進化しており、新しいLLM統合ライブラリやフレームワークが次々と登場しています。最新のトレンドをキャッチアップしながら、プロジェクトに最適な技術選定を行いましょう。

私がPjMとして関わったプロジェクトでは、初期は単純なAPI呼び出しから始めましたが、ユーザーフィードバックを受けて段階的に改善していきました。最終的には、ストリーミング応答・キャッシュ戦略・エッジ実行を組み合わせることで、応答速度を80%改善し、ユーザー満足度を大幅に向上させることができました。この経験から、段階的な改善アプローチが成功の鍵であることを学びました。