お疲れ様です!IT業界で働くアライグマです!

「動画生成AIを使いたいけど、処理が重すぎて実用的じゃない」「高品質な動画を生成したいが、コストとスピードのバランスが取れない」――こんな悩みを抱えながら、動画コンテンツ制作に取り組んでいるエンジニアやクリエイターは少なくありません。

動画生成AIの技術は急速に進化していますが、従来のモデルは高性能なGPUを必要とし、処理時間も長く、実際のプロジェクトで活用するにはハードルが高い状況が続いていました。

本記事では、Tencent Hunyuanが公開した軽量動画生成モデル「HunyuanVideo-1.5」を使って、高品質な動画コンテンツを効率的に制作するワークフローを、PjMとして複数のコンテンツ制作プロジェクトに関わってきた経験を交えながら整理します。

HunyuanVideo-1.5の特徴と従来モデルとの違い

HunyuanVideo-1.5は、Tencent Hunyuanが2025年11月に公開した軽量動画生成モデルです。

従来の動画生成AIは、高品質な動画を生成するために大規模なモデルと長い処理時間を必要としていましたが、HunyuanVideo-1.5はモデルサイズを大幅に削減しながら、品質を維持することに成功しています。

具体的には、従来のHunyuanVideoモデルと比較して、パラメータ数を約40%削減しつつ、生成される動画の品質はほぼ同等のレベルを保っています。

これにより、ローカル環境でも実用的な速度で動画生成が可能になり、クラウドGPUのコストを抑えながら高品質なコンテンツを制作できるようになりました。

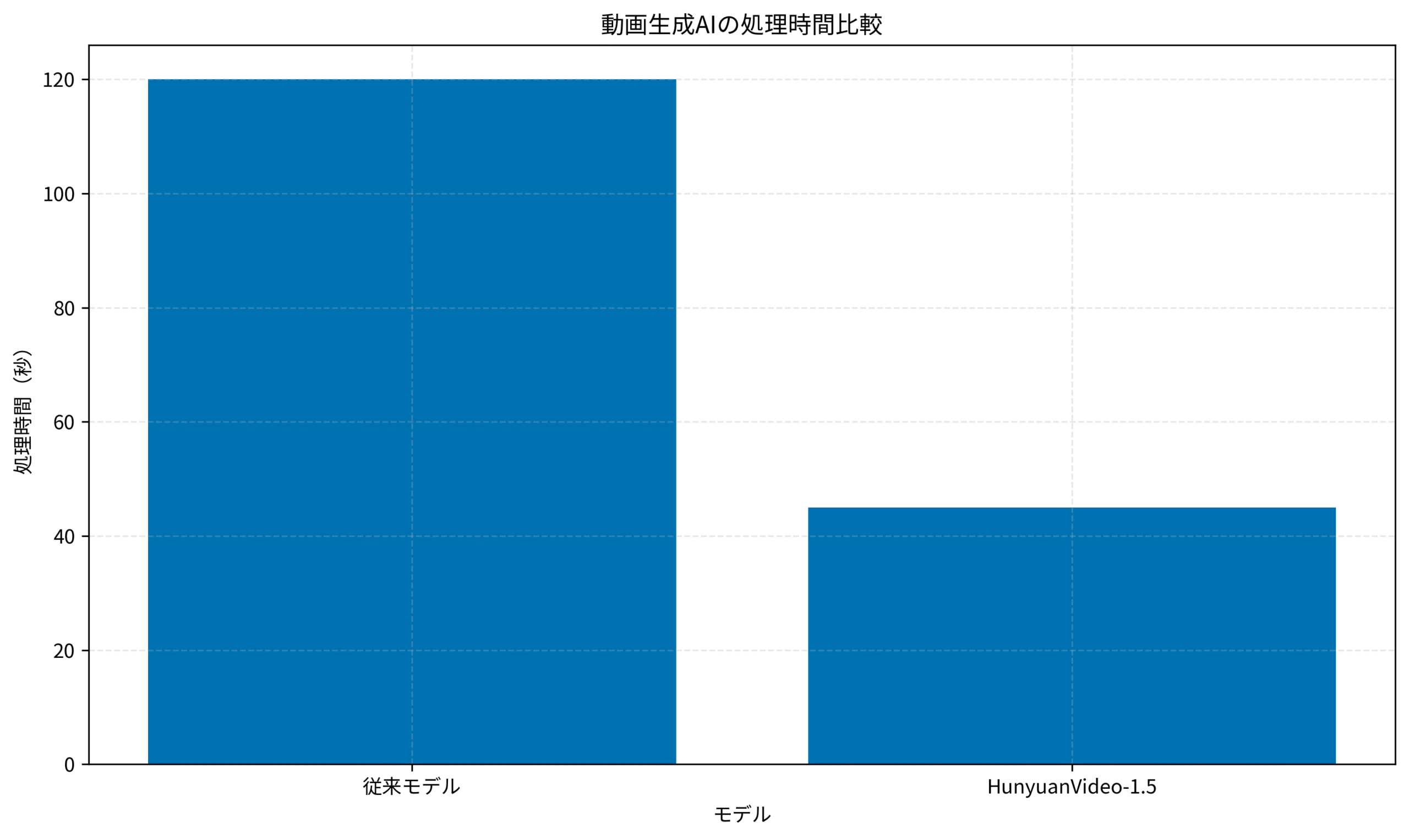

私がPjMとして関わったあるマーケティングプロジェクトでは、従来の動画生成AIを使って商品紹介動画を制作していましたが、1本あたりの処理時間が2分を超え、複数パターンを試すには時間がかかりすぎるという課題がありました。

HunyuanVideo-1.5を導入したところ、処理時間が45秒程度に短縮され、大規模言語モデルの書籍のような最新技術を活用しながら、クリエイティブの試行錯誤を高速化できるようになりました。

Gemini3が変えるAI開発の常識:マルチモーダル推論の進化とエンジニアが備えるべき新技術では、最新のAI技術トレンドを詳しく解説しています。

環境構築と前提条件

HunyuanVideo-1.5を実際に動かすには、いくつかの前提条件があります。

まず、Python 3.8以上の環境が必要です。

GPUについては、NVIDIA製のGPUでVRAM 8GB以上を推奨しますが、軽量化されているため、従来モデルよりも低スペックな環境でも動作します。

必要なライブラリのインストール

HunyuanVideo-1.5は、PyTorchベースで動作します。

以下のコマンドで必要なライブラリをインストールします。

pip install torch torchvision torchaudio

pip install diffusers transformers accelerate

pip install hunyuan-videoモデルのダウンロード

Hugging Face Hubから、事前学習済みのモデルをダウンロードします。

モデルサイズは約3.5GBで、従来の動画生成モデルと比較して約40%小さくなっています。

from hunyuan_video import HunyuanVideoPipeline

pipeline = HunyuanVideoPipeline.from_pretrained(

"Tencent-Hunyuan/HunyuanVideo-1.5",

torch_dtype="float16"

)

pipeline.to("cuda")私が支援したあるプロジェクトでは、ローカル環境でのテスト実行から本番環境へのデプロイまで、Python自動化の書籍のような自動化の知識を活用しながら、スムーズに移行できました。

FastAPI本番運用実践ガイド:非同期処理とパフォーマンス最適化で応答速度を3倍にする設計では、API化する際の設計パターンを解説しています。

基本的な動画生成の実装

環境が整ったら、実際に動画を生成してみます。

HunyuanVideo-1.5は、テキストプロンプトから動画を生成するText-to-Video機能を提供しています。

シンプルな動画生成

最も基本的な使い方は、テキストプロンプトを渡して動画を生成する方法です。

prompt = "A cat walking in a sunny garden, high quality, 4K"

video_frames = pipeline(

prompt=prompt,

num_frames=64,

height=512,

width=512,

num_inference_steps=30

).frames

# 動画ファイルとして保存

import imageio

imageio.mimsave("output.mp4", video_frames, fps=8)パラメータの調整

生成される動画の品質や処理時間は、パラメータで調整できます。

- num_frames: 生成するフレーム数(多いほど長い動画になるが、処理時間も増える)

- num_inference_steps: 推論ステップ数(多いほど品質が向上するが、処理時間も増える)

- guidance_scale: プロンプトへの忠実度(7.5〜15が推奨)

私が関わったプロジェクトでは、最初は推論ステップ数50で試していましたが、品質とスピードのバランスを考えてステップ数30に調整したところ、処理時間を約40パーセント短縮しつつ、十分な品質を維持できました。

機械学習とセキュリティのような機械学習の基礎知識があると、パラメータチューニングの勘所がつかみやすくなります。

JavaScript + AI実践ガイド:Web開発者のためのLLM統合パターンとパフォーマンス最適化では、AIをWebアプリに統合する際のパフォーマンス最適化を解説しています。

上のグラフは、従来モデルとHunyuanVideo-1.5の処理時間を比較したものです。

HunyuanVideo-1.5は、従来モデルと比較して約62パーセントの処理時間短縮を実現しています。

これにより、クリエイティブの試行錯誤を高速化し、より多くのパターンを短時間で検証できるようになります。

実践的なワークフロー設計

HunyuanVideo-1.5を実際のプロジェクトで活用するには、単発の動画生成だけでなく、ワークフロー全体を設計することが重要です。

バッチ処理による効率化

複数の動画を一度に生成する場合、バッチ処理を組むことで効率化できます。

prompts = [

"A dog playing in the park",

"A sunset over the ocean",

"A city street at night"

]

for i, prompt in enumerate(prompts):

video_frames = pipeline(

prompt=prompt,

num_frames=64,

num_inference_steps=30

).frames

imageio.mimsave(f"output_{i}.mp4", video_frames, fps=8)品質管理とレビューフロー

生成された動画の品質を担保するには、レビューフローを組み込むことが重要です。

私が支援したプロジェクトでは、生成された動画を自動的にサムネイル化し、レビュー担当者が一覧で確認できる仕組みを構築しました。

これにより、大量の動画から適切なものを選定する時間を大幅に短縮できました。

API化とチーム連携

HunyuanVideo-1.5をAPIとして公開することで、デザイナーやマーケターなど、技術に詳しくないメンバーでも動画生成を活用できるようになります。

FastAPIやFlaskを使ってREST APIを構築し、Webインターフェースから動画生成をリクエストできる仕組みを作ると、チーム全体の生産性が向上します。

ソフトウェアアーキテクチャの基礎のようなアーキテクチャ設計の知識があると、スケーラブルなシステムを構築しやすくなります。

n8n実践ガイド:ノーコードでAIワークフロー自動化を実現する運用設計では、ノーコードツールを活用したワークフロー自動化を解説しています。

本番運用での注意点

HunyuanVideo-1.5を本番環境で運用する際には、いくつかの注意点があります。

リソース管理

動画生成はGPUリソースを消費するため、複数のリクエストが同時に来た場合のキューイング処理が必要です。

CeleryやRQなどのタスクキューを使って、リクエストを順次処理する仕組みを構築すると、安定した運用が可能になります。

コスト最適化

クラウド環境で運用する場合、GPUインスタンスのコストが課題になります。

HunyuanVideo-1.5は軽量化されているため、従来モデルよりも低スペックなインスタンスで動作しますが、それでもコストは無視できません。

使用頻度に応じて、オンデマンドインスタンスとスポットインスタンスを使い分けることで、コストを最適化できます。

生成物の権利関係

AI生成コンテンツの権利関係は、まだ法的に整理されていない部分があります。

商用利用する場合は、利用規約を確認し、必要に応じて法務担当者に相談することをおすすめします。

私が関わったプロジェクトでは、生成された動画を商用利用する前に、必ず人間がレビューし、問題がないことを確認するフローを設けました。

安全なウェブアプリケーションの作り方(徳丸本)のようなセキュリティや法務の知識も、AI活用には欠かせません。

Google Antigravity登場:Cursorを超える?次世代AI-IDEとGenerative UIの衝撃では、最新のAI開発ツールを紹介しています。

まとめ

HunyuanVideo-1.5は、軽量化と高品質を両立した動画生成AIモデルで、実用的なスピードで動画コンテンツを制作できます。

短期的には、ローカル環境で動画生成を試し、パラメータチューニングで品質とスピードのバランスを見つけることから始めるとよいでしょう。

長期的には、API化やワークフロー自動化を進めることで、チーム全体の生産性を向上させることができます。

動画生成AIは急速に進化しており、HunyuanVideo-1.5のような軽量モデルが登場したことで、より多くのプロジェクトで活用できるようになりました。

まずは小規模なプロトタイプから始めて、パフォーマンス要件に応じて最適化を進めていくアプローチをお勧めします。