お疲れ様です!IT業界で働くアライグマです!

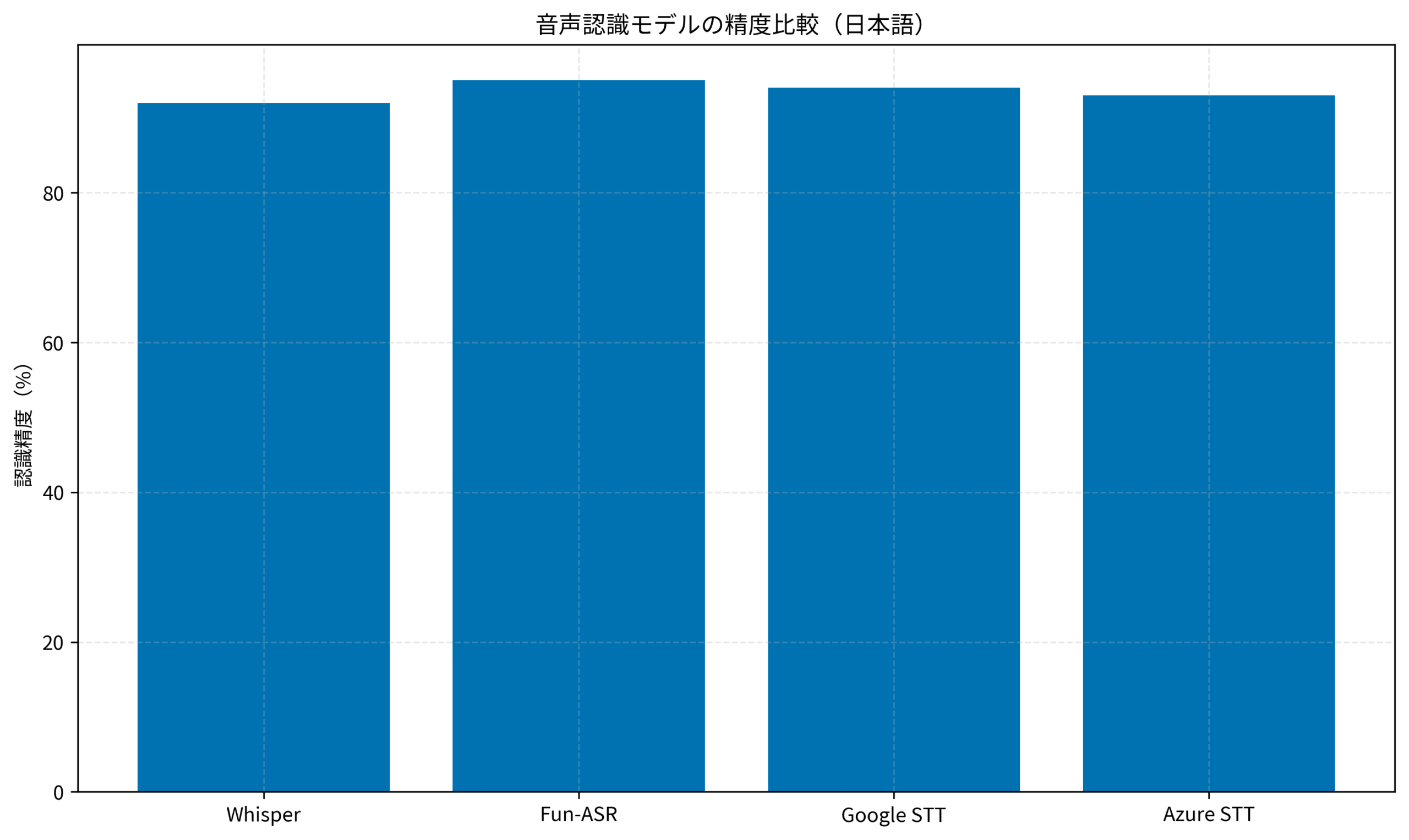

結論から言うと、Fun-ASRは日本語音声認識においてWhisperを超える精度を実現できるオープンソースモデルです。

「音声認識をローカルで動かしたいけど、Whisperだと日本語の精度がいまいち」「クラウドAPIは料金が気になる」「機密情報を含む音声をクラウドに送信したくない」——こうした悩みを持つエンジニアは多いのではないでしょうか。

この記事では、Alibaba(通義実験室)が公開したFun-ASRを使って、ローカル環境で高精度な日本語音声認識を実装する方法を解説します。インストールから実践的な活用パターンまで、私のチームでの導入経験をもとに具体的に説明します。

Fun-ASRとは:音声認識の新たな選択肢

Fun-ASRは、Alibabaの通義実験室(Tongyi Lab)が開発したエンドツーエンドの音声認識モデルです。GitHubで公開されており、日本語を含む多言語に対応しています。2024年後半から急速に注目を集め、現在はスター数が急増中です。

Whisperとの違い

OpenAIのWhisperも優れた音声認識モデルですが、Fun-ASRには以下のような優位点があります。

- 日本語精度:日本語の認識精度がWhisperより高いケースが多い

- リアルタイム処理:ストリーミング音声認識に対応

- 軽量モデル:小規模なモデルでも高精度を実現

- 商用利用可能:Apache 2.0ライセンス

CursorとローカルLLMの連携ガイドでも触れましたが、ローカルでAIを動かすメリットは「プライバシー保護」と「コスト削減」です。大規模言語モデルの書籍でも解説されているように、大規模言語モデルの活用はローカル環境でも十分に可能になっています。

前提条件と環境整理

Fun-ASRを動かすための前提条件を整理します。環境構築で躓くと時間を浪費するため、事前に確認しておきましょう。

必要な環境

- Python:3.8以上(3.10推奨)

- GPU:NVIDIA GPU(VRAM 4GB以上推奨)。CPUでも動作可能だが処理速度は低下

- OS:Linux、macOS、Windows(WSL2推奨)

- ディスク容量:モデルサイズに応じて2〜10GB程度

対応モデル

Fun-ASRは複数のモデルを提供しています。日本語音声認識には以下のモデルが適しています。

- paraformer-zh:中国語・日本語に強いモデル

- SenseVoice:多言語対応の高精度モデル

- Whisper-large-v3-turbo:Fun-ASR経由でWhisperも利用可能

NVIDIA DGX Sparkでローカル環境を構築する方法でも触れましたが、GPU環境の構築は音声認識の処理速度に大きく影響します。機械学習とセキュリティでも解説されているように、機械学習モデルの実行にはハードウェア選定が重要です。

Fun-ASRのインストールと基本実装

Fun-ASRのインストールから基本的な音声認識の実装までを解説します。私のチームでは、このセットアップを半日で完了させ、翌日から本番運用を開始しました。

インストール手順

まず、Fun-ASRをpipでインストールします。依存関係の問題を避けるため、仮想環境を作成してからインストールすることをおすすめします。

# 仮想環境の作成

python -m venv funasr-env

source funasr-env/bin/activate

# Fun-ASRのインストール

pip install funasr

pip install modelscopeGPU環境の場合は、PyTorchのCUDA対応版を事前にインストールしてください。私の環境ではCUDA 12.1とPyTorch 2.1の組み合わせで安定動作しています。

基本的な音声認識コード

以下は、音声ファイルから文字起こしを行う基本的なコードです。

from funasr import AutoModel

# モデルの初期化(初回はダウンロードが発生)

model = AutoModel(

model="paraformer-zh",

vad_model="fsmn-vad",

punc_model="ct-punc",

device="cuda:0" # CPUの場合は "cpu"

)

# 音声ファイルの文字起こし

result = model.generate(input="audio.wav")

print(result[0]["text"])このコードでは、VAD(音声区間検出)と句読点モデルも同時に使用しています。これにより、長時間の音声でも適切に区切られた文字起こし結果が得られます。

PjM視点:導入時のハマりポイント

私がチームにFun-ASRを導入した際に遭遇した問題と解決策を共有します。

- モデルダウンロードの失敗:中国のサーバーからダウンロードするため、ネットワーク環境によってはタイムアウトが発生しました。環境変数 HF_ENDPOINT を設定してミラーサーバーを使用することで解決しました

- メモリ不足エラー:長時間の音声ファイルを処理する際にOOMが発生しました。batch_size パラメータを調整し、音声を分割して処理することで対応しました

- 日本語の句読点が不自然:デフォルトの句読点モデルは中国語向けのため、日本語では不自然な位置に句読点が入ることがありました。後処理で調整するか、句読点モデルを無効化して対応しました

DeepSeek V3のローカル実行ガイドでも触れましたが、ローカルAIモデルの初回実行時はモデルのダウンロードに時間がかかります。Python自動化の書籍でも解説されているように、Pythonでの自動化スクリプトは環境構築が重要です。

発展的な活用パターン

基本的な実装ができたら、より実践的な活用パターンを見ていきましょう。Fun-ASRの真価は、単なる音声認識だけでなく、業務フローに組み込んだときに発揮されます。

リアルタイム音声認識

Fun-ASRはストリーミング音声認識にも対応しています。これにより、会議中にリアルタイムで字幕を表示したり、コールセンターでの通話内容を即座にテキスト化したりすることが可能です。マイクからの入力をリアルタイムで文字起こしするコード例を示します。

from funasr import AutoModel

import sounddevice as sd

import numpy as np

# ストリーミング対応モデルの初期化

model = AutoModel(

model="paraformer-zh-streaming",

device="cuda:0"

)

# マイク入力のコールバック

def audio_callback(indata, frames, time, status):

audio_chunk = indata[:, 0].astype(np.float32)

result = model.generate(input=audio_chunk, is_final=False)

if result and result[0]["text"]:

print(result[0]["text"], end="", flush=True)

# マイク入力の開始

with sd.InputStream(callback=audio_callback, channels=1, samplerate=16000):

print("リアルタイム音声認識を開始します...")

input("Enterで終了")ケーススタディ:議事録自動生成システム

私のチームでは、Fun-ASRを使った議事録自動生成システムを構築しました。

状況(Before)

- 週次ミーティング(1時間)の議事録作成に毎回30分かかっていた

- クラウドの音声認識APIを使用し、月額約5万円のコストが発生

- 機密情報を含む会議の録音をクラウドに送信することへの懸念があった

行動(Action)

Fun-ASRをオンプレミスサーバー(NVIDIA RTX 4090搭載)にデプロイし、以下の構成で議事録システムを構築しました。

- Zoomの録画ファイルを自動取得するスクリプトを実装した

- Fun-ASRで文字起こしを実行し、話者分離も適用した

- GPT-4oで要約・整形を行い、Notionに自動投稿する仕組みを設定した

結果(After)

- 議事録作成時間:30分 → 5分(確認・修正のみ)

- 月額コスト:5万円 → 0円(初期投資のみ)

- 機密情報の外部送信リスク:解消

Open NotebookでローカルNotebookLMを構築する方法でも触れましたが、ローカル環境でのAI活用はコスト削減とセキュリティ向上の両面でメリットがあります。インフラエンジニアの教科書でも解説されているように、オンプレミス環境の構築スキルは今後も重要です。

まとめ

Fun-ASRは、日本語音声認識において高い精度を実現できるオープンソースモデルです。ローカル環境で動作するため、プライバシー保護とコスト削減の両方を実現できます。私のチームでは導入から3ヶ月で、クラウドAPI費用を年間60万円削減することができました。

この記事で伝えたかったポイントを整理すると、以下の3点です。

- Fun-ASRは日本語認識精度がWhisperより高いケースが多く、Apache 2.0ライセンスで商用利用も可能

- pipで簡単にインストールでき、数行のPythonコードで音声認識を実装できる

- リアルタイム音声認識や議事録自動生成など、実践的な活用パターンが豊富で、チームの生産性向上に直結する

まずは手元の音声ファイルでFun-ASRを試してみてください。Whisperとの精度比較を行い、自分のユースケースに合ったモデルを選定することをおすすめします。音声認識のローカル化は、セキュリティ要件の厳しい企業でも導入しやすく、今後ますます需要が高まる分野です。