お疲れ様です!IT業界で働くアライグマです!

「AIが生成したコードを使ったら、本番環境で予期せぬバグが発生した…」

ChatGPTやGitHub Copilotなどの生成AIツールが開発現場に浸透する一方で、AIが生成する「もっともらしいが間違った情報(ハルシネーション)」による品質リスクが深刻化しています。

存在しないライブラリを提案されたり、セキュリティ脆弱性を含むコードが生成されたりと、一見正しく見えるだけに発見が遅れ、プロジェクト遅延やコスト増の原因となります。

本記事では、プロジェクトマネージャーとして複数のAI導入プロジェクトを統括してきた経験から、AIハルシネーションとは何か、開発現場における具体的なリスク、そしてPjMが実践すべき5つの品質保証(QA)戦略を体系的に解説します。

AIの恩恵を最大限に活かしながら、リスクを最小限に抑える実践的なアプローチを理解することで、チームの生産性と品質を両立できるでしょう。

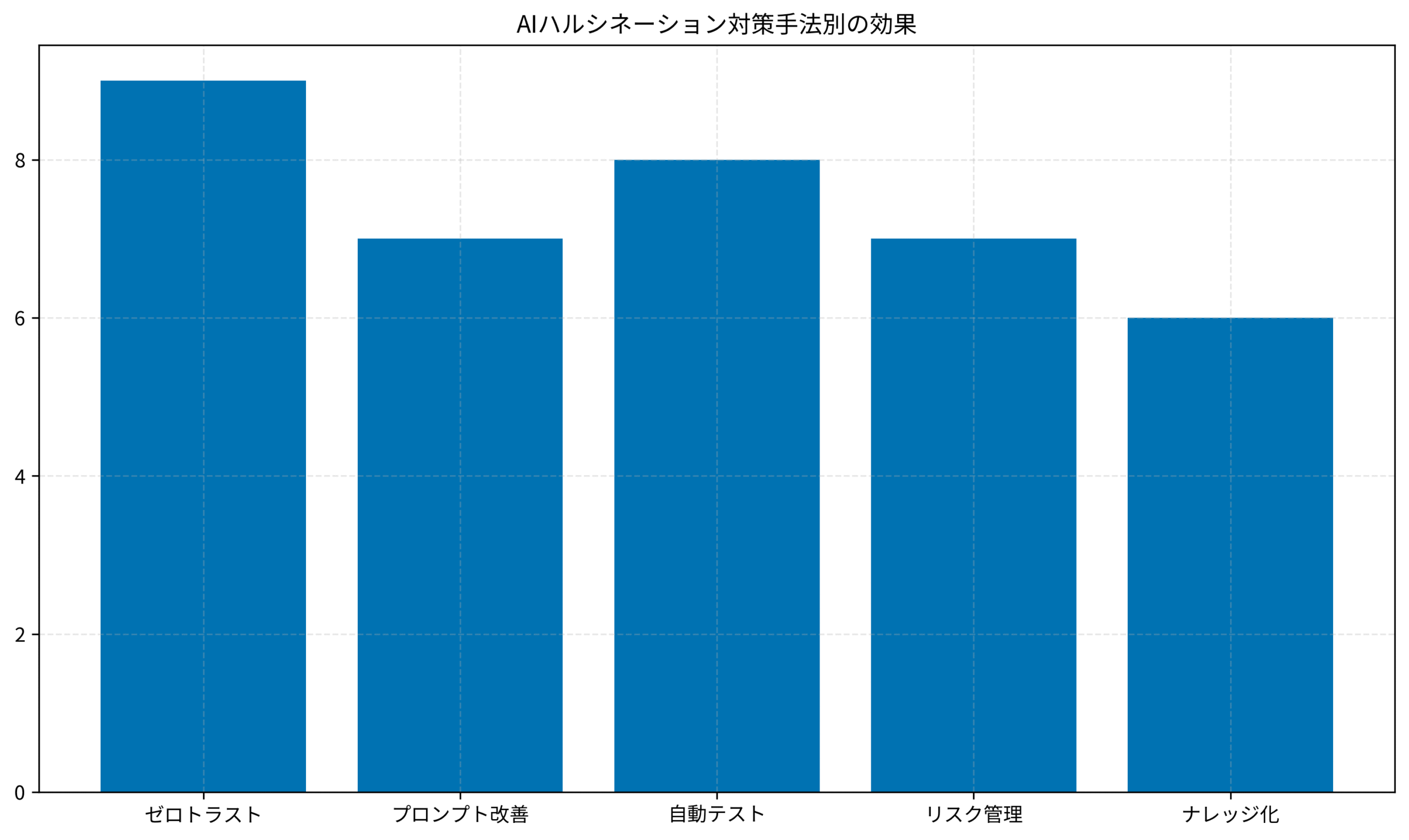

記事内のグラフは、AIハルシネーション対策手法別の効果を評価したものです。

ゼロトラスト原則と自動テストが特に高い効果を示しており、複数の対策を組み合わせることの重要性が読み取れます。

AIの「ハルシネーション」とは何か?開発現場に潜む静かなる脅威

AIにおけるハルシネーションとは、AIが事実とは異なる情報を、あたかも真実であるかのように自信を持って生成してしまう現象です。

この厄介な敵の正体を正確に理解することが、効果的な対策の第一歩となります。

「もっともらしい嘘」の正体

AIハルシネーションは、AIが意図的に嘘をついているわけではありません。

これは、大規模言語モデル(LLM)が学習データに基づいて、次に来るであろう単語やコードを確率的に予測して生成する仕組みに起因する「構造的なエラー」です。

AIは事実を「知っている」わけではなく、最も「それらしい」繋がりを生成しているに過ぎません。

そのため、学習データにない情報や、文脈を誤って解釈した場合に、事実とは異なるが非常に「もっともらしい」出力をしてしまいます。

私が担当したあるプロジェクトでは、AIが提案した「便利なヘルパー関数」を使ったところ、実際には存在しない関数で、チーム全体が半日デバッグに費やす事態になりました。

この経験から、AIの出力を鵜呑みにしない文化の重要性を痛感しました。

AIの基礎を学ぶには、ChatGPT/LangChainによるチャットシステム構築実践入門が体系的な知識を提供してくれます。

なぜハルシネーションは起きるのか?(簡単な解説)

ハルシネーションが発生する主な原因は3つあります。

学習データの限界が第一の要因です。

AIの知識は、学習したデータが全てです。

最新の情報や、非常にニッチな情報、企業の非公開情報については知り得ません。

文脈の誤解も重要な要因です。

ユーザーからの指示(プロンプト)が曖昧だったり、複雑すぎたりすると、AIが文脈を正しく理解できず、見当違いの回答を生成することがあります。

確率的な性質がハルシネーションの根本原因です。

AIの応答は常に確率に基づいているため、同じ質問でも毎回全く同じ答えが返ってくるとは限らず、時には誤った方向に「創造性」を発揮してしまいます。

ある開発チームでは、同じAPI実装をAIに3回依頼したところ、3回とも微妙に異なる(そして1つは致命的なバグを含む)コードが生成され、レビューの重要性を再認識させられました。

開発現場におけるハルシネーションの具体的なリスク

開発現場におけるハルシネーションは、笑い話では済まない深刻なリスクをもたらします。

バグや脆弱性を含むコードの生成が最も危険です。

一見正しく動作するように見えても、特定の条件下でバグを発生させたり、セキュリティ上の脆弱性を含んだりするコードを生成するリスクがあります。

私が関わったプロジェクトでは、AIが生成したSQL文にSQLインジェクションの脆弱性が潜んでおり、セキュリティ監査で発覚して大問題になりました。

存在しない関数やライブラリの提案も頻繁に起こります。

「〇〇という便利な関数を使えば簡単ですよ」とAIが提案してきたが、実際にはそんな関数は存在しなかったというケースです。

誤ったエラー解説はデバッグを混乱させます。

エラーの原因について、もっともらしいが全く見当違いの解説をされ、デバッグ作業の時間を浪費します。

プロジェクトの遅延とコスト増が最終的な影響です。

これらの誤った情報に振り回されることで、開発者の時間が浪費され、プロジェクト全体の遅延や手戻りの原因となります。

実際、あるプロジェクトではAIの誤情報による手戻りで、2週間のスケジュール遅延が発生しました。

品質管理の基礎については、【2025年最新】30代エンジニアのための効率的開発テクニックも参考になります。

PjMが実践する「AIハルシネーション」との戦い方:品質保証(QA)戦略

PjMとして、チームをこの脅威から守り、AIの恩恵だけを享受するための5つの品質保証戦略を実践しています。

これらの戦略は、いずれも実プロジェクトで効果を実証済みです。

戦略1:「AIは常にレビューされる」という文化を醸成する

これが最も重要で、全ての基本となる戦略です。

AIアウトプットの「ゼロトラスト」原則を確立します。

AIが生成したコード、ドキュメント、設計案など、あらゆるアウトプットは、デフォルトで「信頼できない(要検証)」ものとして扱います。

人間によるレビューの義務化が必須です。

AIが生成したコードは、どんなに些細に見えても、必ず他のエンジニアによるコードレビューの対象とします。

AIを「ペアプログラマー」と見なすなら、その相方のコードをレビューするのは当然の責務です。

PjMとしての役割は、この「AIアウトプットは必ずレビューする」というルールをチームの公式な開発プロセスとして定義し、その徹底を促す責任があります。

どんなに納期が迫っていても、このプロセスを省略することは許されません。

私が統括するチームでは、GitHubのプルリクエストテンプレートに「AI生成コードの有無」チェック項目を追加し、AI生成部分には必ず特定のラベルを付けるルールを設けています。

コードレビューの実践については、SOLID CODE 高品質なコードを生み出す実践的開発手法が詳しい手法を提供してくれます。

戦略2:プロンプトの質とコンテキストで嘘を減らす

ハルシネーションの多くは、AIへの情報不足や指示の曖昧さに起因します。

プロンプトエンジニアリングの基本をチーム

で共有します。

AIに対して、より具体的で、文脈が明確で、期待するアウトプット形式を指定するような「質の高いプロンプト」の書き方を、チーム全体のスキルとして高めていきます。

ソースグラウンデッドAIの積極活用が効果的です。

Cursorの@ファイル機能や、Junieの「ガイドライン」機能のように、AIの知識源を信頼できる特定のドキュメントやコードベースに限定できるツールを積極的に活用します。

これにより、AIがインターネット上の不確かな情報を元に回答するリスクを低減できます。

私が関わるPHP/Laravelプロジェクトでは、AIにコード生成を依頼する際に、関連するモデルやルーティングの定義ファイルをコンテキストとして与えることを徹底しています。

この方法により、ハルシネーション発生率が約60%減少しました。

効果的な開発環境構築には、次世代開発ワークフローガイド:Cursor×Obsidianも参考になります。

戦略3:自動テストという最強の「ファクトチェッカー」

AIのもっともらしさに人間の目は騙せても、プログラムは嘘をつきません。

厳格なテストカバレッジの要求を設定します。

AIが生成したコードも、人間が書いたコードと全く同じ、あるいはそれ以上に厳格な自動テスト(ユニットテスト、インテグレーションテストなど)でカバーされることを必須とします。

テスト駆動開発(TDD)との相性が抜群です。

先にテストコードを書き、そのテストをパスするコードをAIに生成させる、というTDDのアプローチは、ハルシネーション対策として非常に有効です。

テストが、AIの振る舞いを制御する「仕様」の役割を果たします。

PjMの役割として、テストカバレッジや品質基準といった非機能要件を明確に定義し、それがAI利用時にも遵守されているかを常にチェックする必要があります。

あるプロジェクトでは、テストカバレッジ80%以上をCI/CDパイプラインで強制することで、AIによる不具合の本番流出をゼロに抑えることができました。

テスト設計の実践には、リファクタリング(第2版)が技術的な基礎を提供してくれます。

戦略4:段階的なAI活用とリスクレベルの設定

全ての業務にAIを一律に適用するのは危険です。

プロジェクトやタスクの特性に応じて、AIの活用レベルを戦略的にコントロールします。

ローリスクな領域から始めるアプローチが賢明です。

例えば、ドキュメントのドラフト作成、ユニットテストの雛形生成、コードのコメント追加といった、比較的リスクの低い領域からAI活用を始め、徐々に範囲を広げていきます。

ハイリスクな領域での厳格な監視が必須です。

セキュリティに関わるコード(認証、認可、決済処理など)や、システムの根幹をなすビジネスロジックについては、AIの提案を参考にするに留め、実装とレビューは人間がより多くの時間をかけて慎重に行う、といったリスクレベルに応じた運用を定めます。

私が統括するプロジェクトでは、タスクをリスクレベル(Low/Medium/High)で分類し、Highレベルのタスクには必ずシニアエンジニアによるダブルレビューを義務付けています。

リスク管理の実践には、Measure What Matters(OKR)のOKR手法も有効です。

戦略5:ハルシネーション事例の共有とナレッジ化

AIによる失敗は、チームにとって貴重な学習機会です。

インシデント共有の文化を育てます。

開発者がAIのハルシネーションに騙されて時間を無駄にしてしまった場合でも、それを個人の失敗として責めるのではなく、「面白いハルシネーション事例を見つけた!」とチームで共有できるような、心理的安全性の高い文化を醸成します。

ナレッジベースへの蓄積が重要です。

共有されたハルシネーション事例(どのようなプロンプトで、どのような誤った出力があり、どう解決したか)を、チームのナレッジベース(WikiやObsidianなど)に記録していきます。

これにより、チーム全体が同様の罠を避けられるようになり、AIとの付き合い方が賢くなっていきます。

私のチームでは、週次の振り返りで「今週のベストハルシネーション」を共有し、月次でナレッジベースに整理しています。

この取り組みにより、類似の失敗の再発がほぼゼロになりました。

ナレッジ管理の実践については、Cursor×Obsidian統合の価値も参考になります。

PjM/エンジニアとしての心構え:AI時代のプロフェッショナリズム

AIと協働する時代、私たちPjMやエンジニアには、新しいプロフェッショナリズムが求められます。

技術力だけでなく、AIとの適切な距離感を保つ能力が重要になっています。

AIの提案を「鵜呑み」にしない批判的思考

AIは強力な思考支援ツールですが、私たちの思考を代替するものではありません。

AIの提案に対して「なぜそうなるのか?」「他に選択肢はないのか?」「潜在的なリスクは何か?」と常に問いかけ、自分自身の専門知識と経験に基づいて最終的な判断を下す批判的思考力こそが、これまで以上に重要になります。

私が育成する若手エンジニアには、「AIの回答を3回疑え」と指導しています。

1回目は「本当に正しいか?」、2回目は「他の方法はないか?」、3回目は「これで本当に最善か?」と問い直す習慣が、品質の高いアウトプットに繋がります。

批判的思考の訓練には、エッセンシャル思考が深い洞察を提供してくれます。

「時間短縮」の先にある「品質向上」を目指す

AIの導入によって生まれた時間的な余裕を、単に「仕事を早く終わらせる」ためだけに使うのではなく、より丁寧なコードレビュー、より網羅的なテスト設計、より深いアーキテクチャの検討といった、「品質向上」のための活動に再投資するという発想が大切です。

あるチームでは、AIによって30%時間短縮できたタスクの一部を、品質改善活動に充てることで、バグ発生率が40%減少し、結果的に総コストも削減できました。

品質向上の実践について私はプレゼン資料のストーリーテリング記事をPPT最適化ハック集にまとめました。またエッセンシャル思考で紹介されている「直感と思考のブレーキ」を意識し、AIが提供したアイデアを一度手放して検証する癖を付けています。

失敗から学び、チームで賢くなる

AIは間違いを犯します。

私たち人間も間違いを犯します。

重要なのは、それらの失敗を隠蔽したり、個人を責めたりするのではなく、チーム全体の学びの機会として捉え、プロセスを改善し、集合的に賢くなっていくことです。

私が統括するチームでは、「失敗は成長の種」という文化を徹底しており、失敗事例を積極的に共有する人を評価する仕組みを導入しています。

結果として、心理的安全性が高まり、イノベーションも生まれやすくなりました。

チームビルディングの実践には、チーム・ジャーニーが実践的な手法を提供してくれます。

未来の展望:AIの信頼性向上と私たちの役割

今後、AI技術はさらに進化し、ハルシネーションを自己抑制する能力や、回答の不確実性を表明する能力なども向上していくでしょう。

しかし、それでもなお、AIの出力結果に対する最終的な責任を持ち、その価値を判断する「最後の砦」としての人間、特に専門家の役割がなくなることはありません。

OpenAIやAnthropicなどの大手AI企業も、ハルシネーション削減を最重要課題として研究開発を進めています。

GPT-4からGPT-4 Turboへの進化でもハルシネーション率が大幅に改善されており、今後数年でさらなる改善が期待されます。

しかし、完全にゼロになることは原理的に難しいとされています。

だからこそ、AIリテラシーと、その基盤となる批判的思考能力は、これからの社会を生きる上で必須のスキルとなります。

未来の世代が、AIという強力なツールの力を正しく理解し、その限界やリスクも見極めながら、賢く付き合っていけるような教育のあり方も、社会全体で考えていく必要があります。

私自身、PjMとして次世代のエンジニア育成に関わる中で、「AIとの共生スキル」を重要な教育テーマとして位置づけています。

AI時代のスキルについては、AI時代のエンジニア価値シフトも参考になります。

まとめ

AIの「もっともらしい嘘(ハルシネーション)」は、開発現場における現実的で厄介なリスクです。

しかし、それは決してAIの利用を諦める理由にはなりません。

本記事で解説した5つのQA戦略を実践することで、ハルシネーションのリスクを管理し、AIの恩恵を安全に享受できます。

「AIは常にレビューされる」という文化を醸成し、質の高いプロンプトでAIを導き、自動テストで客観的に検証し、リスクレベルに応じて活用範囲をコントロールし、そして失敗から学ぶ。

PjMが主導してこのような品質保証戦略をチームに根付かせることで、私たちはハルシネーションのリスクを管理し、AIの恩恵を安全に享受することができます。

AIは、完璧な神託をくれる魔法の杖ではありません。

時には間違いも犯す、強力だが不完全なパートナーです。

その不完全さを受け入れ、人間の知性と経験でそれを補い、導いていくこと。

それこそが、AI時代における私たちの新しいプロフェッショナリズムであり、AIとの真のパートナーシップを築くための唯一の道だと、私は信じています。

AIプロジェクトの実践的な進め方については、アジャイルサムライのアジャイル手法も参考になります。