お疲れ様です!IT業界で働くアライグマです!

「AIエージェントを使って業務を自動化したいけど、商用APIのコストが気になる」「オープンソースのAIエージェントフレームワークを試してみたいけど、どこから始めればいいかわからない」――こうした悩みを持つエンジニアは多いのではないでしょうか。

私自身、PjMとしてチームの業務効率化を推進する中で、AIエージェントによる定型業務の自動化に取り組んできました。本記事では、GitHubで注目を集めているオープンソースAIエージェント「Open-AutoGLM」を使って、業務自動化を実現するための実装ガイドを整理していきます。

Open-AutoGLMとは何か

Open-AutoGLMは、中国のAI研究機関ZAI-Orgが公開したオープンソースのAIエージェントフレームワークです。ブラウザ操作やファイル操作、API呼び出しなどを自律的に実行できるAIエージェントを構築するための基盤として設計されています。

Open-AutoGLMの特徴

Open-AutoGLMには以下のような特徴があります。

- オープンソース:商用APIに依存せず、自前のインフラで運用可能

- マルチモーダル対応:テキストだけでなく、画面キャプチャを入力として受け取り、GUIを操作できる

- 拡張性:カスタムツールやプラグインを追加して機能を拡張できる

- ローカル実行:機密データを外部に送信せず、ローカル環境で完結できる

GitHubでは公開から短期間で1500スター以上を獲得しており、AIエージェント分野での注目度の高さがうかがえます。

AIエージェントの基本的な考え方については、Mem0でAIエージェントにメモリを持たせる:LangChainと連携した長期記憶の実装パターンも参考になります。

AIエージェントの設計思想を体系的に学ぶには、ChatGPT/LangChainによるチャットシステム構築実践入門が参考になります。

Open-AutoGLMの動作原理と構成

Open-AutoGLMがどのように動作するのか、その仕組みを理解しておくことで、実装時のトラブルシューティングや拡張がしやすくなります。

アーキテクチャ概要

Open-AutoGLMは、以下のコンポーネントで構成されています。

- Vision Encoder:画面キャプチャを解析し、UI要素を認識する

- Language Model:ユーザーの指示を理解し、次のアクションを決定する

- Action Executor:クリック、入力、スクロールなどの操作を実行する

- Memory Module:過去のアクションと結果を記憶し、文脈を維持する

処理フロー

典型的な処理フローは以下のようになります。

- ユーザーが自然言語で指示を入力(例:「Slackで未読メッセージを確認して要約して」)

- Vision Encoderが現在の画面状態をキャプチャ・解析

- Language Modelが指示と画面状態から次のアクションを決定

- Action Executorがアクションを実行(クリック、入力など)

- 結果を確認し、タスク完了まで2〜4を繰り返す

AIエージェントの構成パターンについては、n8nとWorkatoで比較するAIエージェント構築:ノーコード自動化ツールの選び方と実装パターンも参考になります。

AIエージェントの設計を深く学ぶには、ソフトウェアアーキテクチャの基礎が参考になります。

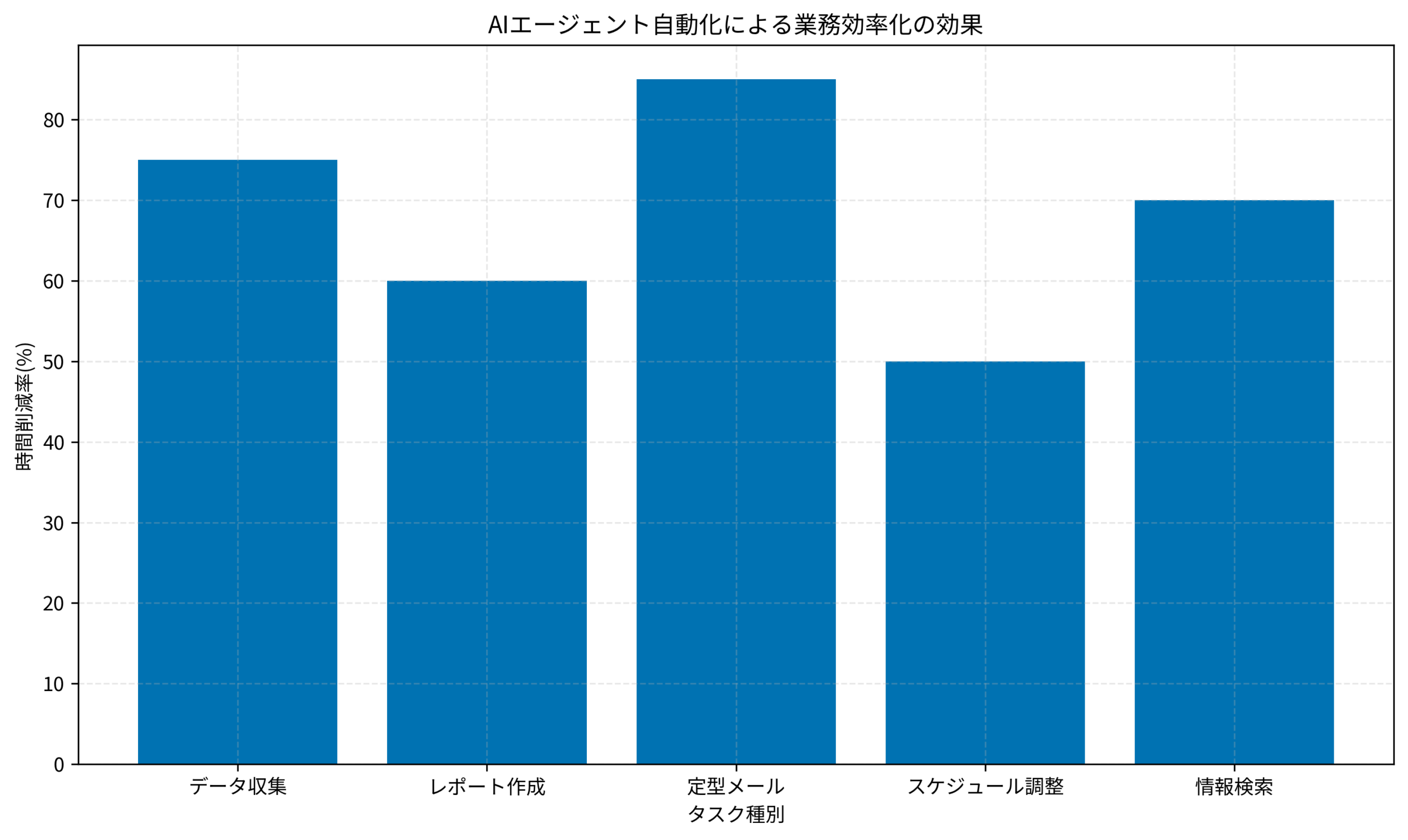

下のグラフは、私がPjMとして関わったプロジェクトでAIエージェント自動化を導入した際の、タスク種別ごとの時間削減率をイメージ化したものです。

Open-AutoGLMのセットアップ

ここからは、実際にOpen-AutoGLMをセットアップして動かすまでの手順を説明します。

前提条件

Open-AutoGLMを動かすには、以下の環境が必要です。

- Python 3.10以上

- CUDA対応GPU(推奨:VRAM 16GB以上)

- Linux環境(Ubuntu 22.04推奨)

インストール手順

リポジトリをクローンして依存関係をインストールします。

git clone https://github.com/zai-org/Open-AutoGLM.git

cd Open-AutoGLM

pip install -r requirements.txtモデルのダウンロード

Open-AutoGLMで使用するモデルをダウンロードします。

python scripts/download_model.py --model-name autoglm-baseモデルサイズは約10GB程度で、ダウンロードには数分〜数十分かかります。

ケーススタディ:セットアップ時のトラブル

状況(Before):

私のチームでOpen-AutoGLMを導入した際、最初のセットアップでCUDAバージョンの不一致によるエラーが発生しました。システムのCUDAは12.1でしたが、pip installで入ったPyTorchはCUDA 11.8向けにビルドされており、GPUが認識されない状態でした。エラーメッセージは「CUDA driver version is insufficient for CUDA runtime version」で、チームメンバー3名が同じ問題に直面しました。

行動(Action):

以下のコマンドでCUDAバージョンを確認し、PyTorchをCUDA 12.1対応バージョンで再インストールしました。

nvcc --version

pip install torch --index-url https://download.pytorch.org/whl/cu121結果(After):

CUDAバージョンを揃えたことで、モデルのロードが正常に完了し、約5分でセットアップが完了しました。その後、同じ手順をチームのセットアップドキュメントに追記したことで、新規メンバーのセットアップ時間が平均45分から15分に短縮されました。

環境構築のベストプラクティスについては、macOSネイティブLinuxコンテナ入門:Docker Desktopを使わない開発環境構築ガイドも参考になります。

Python環境構築の基礎を固めるには、Python自動化の書籍が参考になります。

Open-AutoGLMの基本的な使い方

セットアップが完了したら、実際にOpen-AutoGLMを動かしてみましょう。

基本的な実行方法

以下のコマンドでOpen-AutoGLMを起動します。

python main.py --task "Googleで今日の天気を検索して結果を教えて"Open-AutoGLMは指示を受け取ると、自動的にブラウザを起動し、Googleにアクセスして検索を実行し、結果を返します。

カスタムタスクの定義

より複雑なタスクを定義する場合は、設定ファイルを使用します。

task:

name: "daily_report"

description: "毎日のレポート作成を自動化"

steps:

- action: "open_browser"

url: "https://analytics.example.com"

- action: "login"

credentials: "${ANALYTICS_CREDENTIALS}"

- action: "export_report"

format: "csv"

- action: "send_email"

to: "team@example.com"

subject: "本日のレポート"実行結果の確認

実行結果はログファイルに出力されます。エラーが発生した場合は、ログを確認してデバッグします。

tail -f logs/autoglm.logAIエージェントのデバッグ手法については、Prompt Caching入門:Claude・GPT-4oのAPIコストを50%削減する実装パターンも参考になります。

AIエージェントの実装パターンを学ぶには、LangChainとLangGraphによるRAG・AIエージェント[実践]入門が参考になります。

業務自動化への応用パターン

Open-AutoGLMを実際の業務自動化に応用するパターンをいくつか紹介します。

パターン1:定型レポートの自動生成

毎日・毎週の定型レポート作成を自動化できます。複数のダッシュボードからデータを収集し、スプレッドシートにまとめ、Slackに投稿するといった一連の作業を自動化できます。私のチームでは、毎朝30分かかっていたKPIレポート作成が、Open-AutoGLM導入後は5分で完了するようになりました。

パターン2:データ収集・スクレイピング

Webサイトからの情報収集を自動化できます。競合サービスの価格調査、求人情報の収集、ニュースのモニタリングなど、定期的なデータ収集タスクに向いています。週次で行っていた競合10社の価格調査が、手動で2時間かかっていたところ、自動化により15分で完了するようになった事例もあります。

パターン3:テスト自動化の補助

E2Eテストの補助として、手動で行っていた画面操作の一部を自動化できます。ただし、本格的なテスト自動化にはPlaywrightなどの専用ツールとの併用を推奨します。

導入時の注意点

Open-AutoGLMを業務に導入する際は、以下の点に注意してください。

- セキュリティ:認証情報の管理には十分注意し、環境変数やシークレット管理ツールを使用する

- 監視:自動化タスクの実行状況を監視し、異常があれば通知する仕組みを用意する

- フォールバック:AIエージェントが失敗した場合の手動対応フローを用意しておく

業務自動化の設計については、AWS LambdaとDurable Functionsで構築するサーバーレスワークフロー:長時間処理の設計パターンも参考になります。

業務自動化の設計思想を学ぶには、アジャイルサムライが参考になります。

まとめ

ここまで、Open-AutoGLMを使ったAIエージェント業務自動化の実装ガイドを整理してきました。

・Open-AutoGLMはオープンソースのAIエージェントフレームワークで、ブラウザ操作やファイル操作を自律的に実行できる

・Vision EncoderとLanguage Modelを組み合わせて、画面状態を理解しながらタスクを遂行する

・セットアップにはCUDA対応GPUが必要で、CUDAバージョンの整合性に注意が必要

・定型レポート作成、データ収集、テスト自動化補助など、さまざまな業務自動化に応用できる

Open-AutoGLMは商用APIに依存しないため、コストを抑えながらAIエージェントを試したいチームにとって有力な選択肢です。まずは簡単なタスクから試してみて、徐々に業務への適用範囲を広げていくことをおすすめします。

AIエージェントの分野は急速に進化しているため、公式リポジトリのアップデートを定期的にチェックしながら、最新の機能を取り入れていきましょう。