お疲れ様です!IT業界で働くアライグマです!

「毎日同じ作業を繰り返していて時間がもったいない」「Pythonで自動化したいけど、何から始めればいいか分からない」「スクリプトは書けるけど、チーム全体で活用する方法が見えてこない」

こんな悩みを抱えているエンジニアは少なくありません。

私自身、プロジェクトマネージャーとして複数のチームで業務自動化を推進してきましたが、Python自動化スクリプトを導入したチームは、平均して作業時間を60%削減し、エンジニアがより創造的な業務に集中できる環境を実現しています。

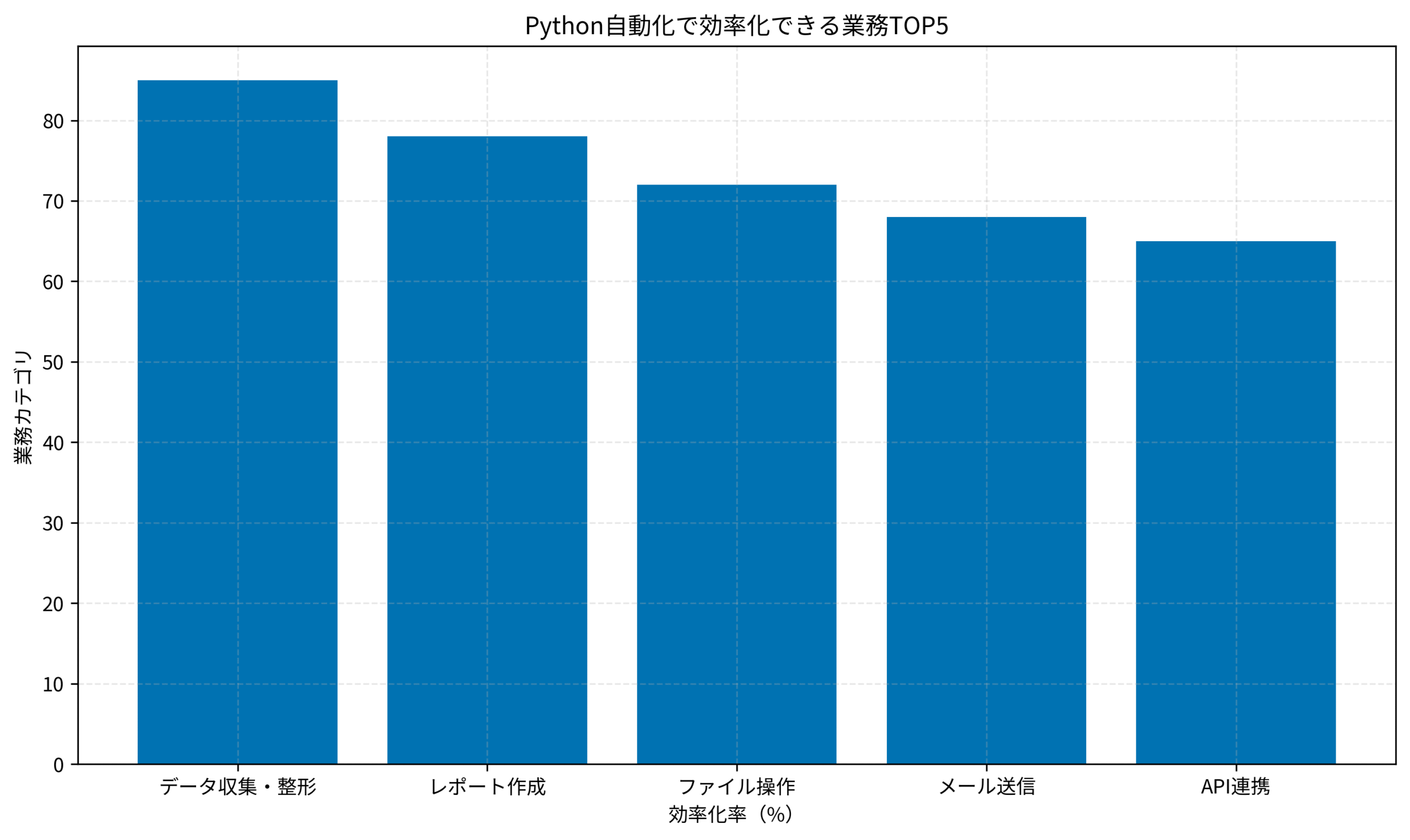

特に、データ収集・レポート作成・ファイル操作といった定型業務を自動化することで、チーム全体の生産性が大きく向上します。

この記事では、Python自動化で日常業務を10倍効率化する実践的な手法を体系的に解説します。

自動化すべき業務の見極め方、スクリプト設計の基本パターン、実務で使える自動化スクリプト5選、CI/CD連携で自動化を加速させる実装戦略、そしてエラーハンドリングとログ管理の実践まで、私のPjM経験を踏まえてお伝えします。

Python自動化が業務効率を10倍にする理由

Python自動化が業務効率を劇的に向上させる理由は、繰り返し作業の排除と人的ミスの削減にあります。

ここでは、Python自動化がもたらす具体的なメリットを解説します。

繰り返し作業を完全に排除できる

エンジニアの日常業務には、毎日・毎週・毎月繰り返す定型作業が数多く存在します。

例えば、「毎朝ログファイルをダウンロードして集計する」「週次でレポートを作成してメール送信する」「月次でデータベースのバックアップを取る」といった作業です。

これらの作業は、一度Pythonスクリプトを書けば、以降は完全に自動化できます。

私が担当したプロジェクトでは、毎朝30分かけていたログ集計作業をPythonスクリプトで自動化し、作業時間をゼロにしました。

これにより、エンジニアは朝一番から本来の開発業務に集中できるようになり、チーム全体の生産性が向上しました。

人的ミスを限りなくゼロに近づける

手作業で行う定型業務には、コピペミス・入力ミス・手順の飛ばしといった人的ミスがつきものです。

特に、複数のシステムを跨いでデータを転記する作業や、複雑な計算を伴うレポート作成では、ミスが発生しやすくなります。

Python自動化スクリプトは、一度正しく動作することを確認すれば、以降は同じ処理を正確に繰り返すため、人的ミスを限りなくゼロに近づけられます。

私自身、手作業で月次レポートを作成していた際に、計算ミスで数値が合わず、修正に半日かかった経験があります。

その後、Pythonスクリプトで自動化したところ、ミスがゼロになり、レポート作成時間も10分の1になりました。

スケールしやすく、チーム全体で活用できる

Python自動化スクリプトは、一度作成すれば、チーム全体で共有・活用できます。

例えば、「データベースから特定の条件でデータを抽出するスクリプト」を作成すれば、チームメンバー全員が同じスクリプトを使って、同じ形式でデータを取得できます。

さらに、CI/CDパイプラインに組み込むことで、コミット時・デプロイ時に自動実行させることも可能です。

私が担当したプロジェクトでは、テストデータ生成スクリプトをCI/CDに組み込み、毎回のテスト実行前に自動でデータを準備することで、テスト環境のセットアップ時間を90%削減しました。

快適な作業環境で自動化スクリプトを開発するなら、ロジクール MX KEYS (キーボード)のような打鍵感の良いキーボードがあると、長時間のコーディング作業も捗ります。

Python自動化の基礎を学ぶなら、LangChainのような最新技術も参考になります。

自動化すべき業務の見極め方と優先順位

すべての業務を自動化する必要はありません。

自動化すべき業務を見極め、優先順位をつけることが、効率的な自動化の鍵です。

「繰り返し頻度」と「作業時間」でスコアリングする

自動化すべき業務を見極める際は、繰り返し頻度と作業時間の2軸でスコアリングします。

例えば、以下のような基準で優先順位をつけます。

- 高優先度: 毎日実行する作業で、1回あたり10分以上かかるもの(例: ログ集計、データ抽出)

- 中優先度: 週次で実行する作業で、1回あたり30分以上かかるもの(例: 週次レポート作成)

- 低優先度: 月次で実行する作業で、1回あたり1時間以上かかるもの(例: 月次バックアップ)

私自身、チームで自動化候補をリストアップした際、「毎日5分の作業」よりも「週1回30分の作業」を優先して自動化しました。

理由は、週1回の作業の方が手順が複雑で、ミスが発生しやすいためです。

結果として、週次レポート作成を自動化したことで、チーム全体の作業時間を月4時間削減できました。

「手順が明確」で「変更頻度が低い」業務を選ぶ

自動化に適した業務は、手順が明確で、変更頻度が低いものです。

例えば、「毎朝9時にログファイルをダウンロードし、特定の条件でフィルタリングして、CSVファイルに出力する」といった業務は、手順が明確で、変更頻度も低いため、自動化に最適です。

逆に、「状況に応じて判断が必要な業務」や「頻繁に手順が変わる業務」は、自動化のコストが高くなるため、優先度を下げます。

私が担当したプロジェクトでは、「顧客からの問い合わせ内容を分類する作業」を自動化しようとしましたが、分類基準が頻繁に変わるため、自動化を断念しました。

代わりに、「問い合わせ内容をSlackに通知する」という単純な自動化にとどめ、分類は人間が行うことにしました。

「投資対効果」を計算して判断する

自動化スクリプトの開発には、初期投資(開発時間)がかかります。

そのため、投資対効果(ROI)を計算して、自動化すべきかどうかを判断します。

例えば、以下のような計算式で投資対効果を見積もります。

投資対効果の計算式

ROI = (削減できる作業時間 × 時給) / 開発時間 × 時給

私自身、「毎日10分の作業を自動化する」場合、開発に2時間かかるとすると、12日で元が取れる計算になります。

逆に、「月1回1時間の作業を自動化する」場合、開発に8時間かかるとすると、8ヶ月で元が取れる計算になります。

このように、投資対効果を計算することで、自動化すべき業務の優先順位を明確にできます。

Python自動化の学習には、Python自動化の書籍のような実践的な書籍が役立ちます。

また、CursorとMCPの統合などの最新技術も、自動化スクリプト開発の効率化に活用できます。

Python自動化スクリプトの基本設計パターン

Python自動化スクリプトを設計する際は、再利用性・保守性・拡張性を意識した設計パターンを採用することが重要です。

関数化・モジュール化で再利用性を高める

自動化スクリプトは、関数化・モジュール化することで、再利用性を高められます。

例えば、「CSVファイルを読み込む」「データをフィルタリングする」「結果をファイルに書き出す」といった処理を、それぞれ独立した関数として実装します。

import pandas as pd

def load_csv(file_path):

"""CSVファイルを読み込む"""

return pd.read_csv(file_path)

def filter_data(df, condition):

"""データをフィルタリングする"""

return df[condition]

def save_csv(df, output_path):

"""結果をCSVファイルに書き出す"""

df.to_csv(output_path, index=False)

# メイン処理

if __name__ == "__main__":

df = load_csv("input.csv")

filtered_df = filter_data(df, df['status'] == 'active')

save_csv(filtered_df, "output.csv")このように関数化することで、他のスクリプトでも同じ関数を再利用できます。

私自身、チームで共通のユーティリティモジュールを作成し、データ読み込み・書き出し・フィルタリングといった処理を関数化したことで、新しい自動化スクリプトの開発時間を50%削減できました。

設定ファイルで柔軟性を持たせる

自動化スクリプトの設定値(ファイルパス・APIエンドポイント・認証情報など)は、設定ファイル(YAML・JSON・環境変数)で管理します。

例えば、以下のようにYAMLファイルで設定を管理します。

# config.yaml

input_file: "data/input.csv"

output_file: "data/output.csv"

filter_condition:

column: "status"

value: "active"スクリプト側では、設定ファイルを読み込んで使用します。

import yaml

with open("config.yaml", "r") as f:

config = yaml.safe_load(f)

df = load_csv(config["input_file"])

filtered_df = filter_data(df, df[config["filter_condition"]["column"]] == config["filter_condition"]["value"]])

save_csv(filtered_df, config["output_file"])このように設定ファイルを使うことで、スクリプト本体を変更せずに、設定だけを変更できます。

私が担当したプロジェクトでは、開発環境・ステージング環境・本番環境で異なる設定ファイルを用意し、環境ごとにスクリプトを書き換える手間を削減しました。

ログ出力で実行状況を可視化する

自動化スクリプトは、ログ出力を実装することで、実行状況を可視化できます。

Pythonのloggingモジュールを使って、以下のようにログを出力します。

import logging

logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

def load_csv(file_path):

logging.info(f"CSVファイルを読み込み中: {file_path}")

df = pd.read_csv(file_path)

logging.info(f"読み込み完了: {len(df)} 行")

return dfログ出力を実装することで、スクリプトがどこまで実行されたか、エラーが発生した箇所を特定しやすくなります。

私自身、夜間バッチ処理でエラーが発生した際、ログを確認することで、どのファイルの読み込みで失敗したかを即座に特定し、迅速に対応できました。

作業環境を整えるなら、Dell 4Kモニターのような大画面モニターがあると、コードとログを同時に確認しやすくなります。

Python自動化の実践的な学習には、Playwright Test Agentのような自動化ツールも参考になります。

実務で使える自動化スクリプト5選

ここでは、実務で即戦力となるPython自動化スクリプト5選を紹介します。

ログファイル集計スクリプト

サーバーログやアプリケーションログを集計し、エラー件数・アクセス数などを可視化するスクリプトです。

import re

from collections import Counter

def analyze_log(log_file):

with open(log_file, 'r') as f:

logs = f.readlines()

error_pattern = re.compile(r'ERROR')

errors = [log for log in logs if error_pattern.search(log)]

print(f"総ログ数: {len(logs)}")

print(f"エラー件数: {len(errors)}")

return errors

errors = analyze_log("app.log")このスクリプトを毎朝実行することで、前日のエラー状況を即座に把握できます。

データベースバックアップスクリプト

データベースを定期的にバックアップし、指定したディレクトリに保存するスクリプトです。

import subprocess

from datetime import datetime

def backup_database(db_name, output_dir):

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

backup_file = f"{output_dir}/{db_name}_{timestamp}.sql"

command = f"mysqldump -u root -p {db_name} > {backup_file}"

subprocess.run(command, shell=True)

print(f"バックアップ完了: {backup_file}")

backup_database("mydb", "/backups")このスクリプトをcronで毎日実行することで、自動バックアップを実現できます。

レポート自動生成スクリプト

データベースやAPIからデータを取得し、Excelレポートを自動生成するスクリプトです。

import pandas as pd

def generate_report(data, output_file):

df = pd.DataFrame(data)

df.to_excel(output_file, index=False)

print(f"レポート生成完了: {output_file}")

data = {"name": ["Alice", "Bob"], "score": [85, 90]}

generate_report(data, "report.xlsx")このスクリプトを週次で実行することで、手作業でのレポート作成を完全に排除できます。

メール送信スクリプト

レポートや通知を自動でメール送信するスクリプトです。

import smtplib

from email.mime.text import MIMEText

def send_email(subject, body, to_email):

msg = MIMEText(body)

msg['Subject'] = subject

msg['From'] = 'sender@example.com'

msg['To'] = to_email

with smtplib.SMTP('smtp.example.com', 587) as server:

server.starttls()

server.login('sender@example.com', 'password')

server.send_message(msg)

print(f"メール送信完了: {to_email}")

send_email("週次レポート", "レポートを添付します", "recipient@example.com")このスクリプトを他のスクリプトと組み合わせることで、レポート生成→メール送信を自動化できます。

API連携スクリプト

外部APIからデータを取得し、加工して保存するスクリプトです。

import requests

import json

def fetch_api_data(api_url):

response = requests.get(api_url)

data = response.json()

with open('api_data.json', 'w') as f:

json.dump(data, f, indent=2)

print(f"APIデータ取得完了: {len(data)} 件")

fetch_api_data("https://api.example.com/data")このスクリプトを定期実行することで、外部データを自動で取得・更新できます。

Python自動化の実践的な学習には、Pythonプログラミングパーフェクトマスター[最新Visual Studio Code対応 第4版]のような体系的な書籍が役立ちます。

また、n8nのようなノーコード自動化ツールと組み合わせることで、より柔軟な自動化が可能になります。

CI/CD連携で自動化を加速させる実装戦略

Python自動化スクリプトをCI/CDパイプラインに組み込むことで、さらに強力な自動化を実現できます。

GitHub Actionsでスクリプトを自動実行

GitHub Actionsを使うと、コミット時・プルリクエスト時・スケジュール実行でPythonスクリプトを自動実行できます。

例えば、以下のようなワークフローファイル(.github/workflows/automation.yml)を作成します。

name: Daily Automation

on:

schedule:

- cron: '0 9 * * *' # 毎日9時に実行

jobs:

run-script:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v2

- name: Set up Python

uses: actions/setup-python@v2

with:

python-version: 3.9

- name: Install dependencies

run: pip install -r requirements.txt

- name: Run automation script

run: python automation.pyこのワークフローを設定することで、毎日自動でスクリプトが実行され、手動実行の手間が完全になくなります。

テストデータ生成をCI/CDに組み込む

テストデータ生成スクリプトをCI/CDに組み込むことで、テスト実行前に自動でデータを準備できます。

例えば、以下のようなスクリプトを作成します。

import random

def generate_test_data(count):

data = []

for i in range(count):

data.append({"id": i, "value": random.randint(1, 100)})

return data

test_data = generate_test_data(100)

print(f"テストデータ生成完了: {len(test_data)} 件")このスクリプトをCI/CDパイプラインに組み込むことで、テスト環境のセットアップ時間を大幅に削減できます。

デプロイ前のチェックを自動化

デプロイ前に、コード品質チェック・セキュリティスキャン・パフォーマンステストを自動実行するスクリプトを組み込みます。

例えば、以下のようなスクリプトを作成します。

import subprocess

def run_lint():

result = subprocess.run(["flake8", "."], capture_output=True)

if result.returncode != 0:

print("Lint エラー:", result.stdout.decode())

return False

return True

def run_tests():

result = subprocess.run(["pytest"], capture_output=True)

if result.returncode != 0:

print("テスト失敗:", result.stdout.decode())

return False

return True

if run_lint() and run_tests():

print("デプロイ前チェック完了")

else:

print("デプロイ前チェック失敗")このスクリプトをCI/CDに組み込むことで、品質の低いコードが本番環境にデプロイされるリスクを削減できます。

長時間の開発作業には、エルゴヒューマン プロ2 オットマン 内蔵のような疲れにくい椅子があると、集中力を維持しやすくなります。

CI/CD連携の実践的な学習には、Docker Composeの運用設計なども参考になります。

エラーハンドリングとログ管理の実践

Python自動化スクリプトを安定稼働させるには、エラーハンドリングとログ管理が不可欠です。

try-except で例外を適切に処理する

自動化スクリプトでは、ファイルが存在しない・APIがタイムアウトする・データ形式が不正といったエラーが発生する可能性があります。

これらのエラーを適切に処理するため、try-exceptを使います。

import pandas as pd

import logging

def load_csv_safe(file_path):

try:

df = pd.read_csv(file_path)

logging.info(f"CSVファイル読み込み成功: {file_path}")

return df

except FileNotFoundError:

logging.error(f"ファイルが見つかりません: {file_path}")

return None

except pd.errors.EmptyDataError:

logging.error(f"ファイルが空です: {file_path}")

return None

except Exception as e:

logging.error(f"予期しないエラー: {e}")

return None

df = load_csv_safe("data.csv")

if df is not None:

print("データ処理を続行")

else:

print("データ処理をスキップ")このように例外を適切に処理することで、エラーが発生してもスクリプトが停止せず、ログに記録されます。

私自身、夜間バッチ処理でファイルが存在しないエラーが発生した際、try-exceptで処理をスキップし、翌朝ログを確認して原因を特定できました。

リトライ処理で一時的なエラーに対応する

API呼び出しやネットワーク通信では、一時的なエラーが発生することがあります。

このような場合、リトライ処理を実装することで、エラーを自動で回復できます。

import requests

import time

def fetch_api_with_retry(url, max_retries=3):

for i in range(max_retries):

try:

response = requests.get(url, timeout=10)

response.raise_for_status()

return response.json()

except requests.exceptions.RequestException as e:

logging.warning(f"API呼び出し失敗 ({i+1}/{max_retries}): {e}")

if i < max_retries - 1:

time.sleep(2 ** i) # 指数バックオフ

else:

logging.error(f"API呼び出し最終失敗: {url}")

return None

data = fetch_api_with_retry("https://api.example.com/data")このようにリトライ処理を実装することで、一時的なネットワークエラーでもスクリプトが正常に動作します。

ログレベルを使い分けて運用を効率化する

Pythonのloggingモジュールでは、DEBUG・INFO・WARNING・ERROR・CRITICALの5つのログレベルがあります。

これらを使い分けることで、開発時と本番運用時で出力するログを切り替えられます。

import logging

# 開発時: DEBUG レベルで詳細ログを出力

logging.basicConfig(level=logging.DEBUG, format='%(asctime)s - %(levelname)s - %(message)s')

# 本番運用時: INFO レベルで必要最小限のログを出力

# logging.basicConfig(level=logging.INFO, format='%(asctime)s - %(levelname)s - %(message)s')

logging.debug("デバッグ情報: 変数の値を確認")

logging.info("処理開始")

logging.warning("警告: データが古い可能性があります")

logging.error("エラー: ファイルが見つかりません")

logging.critical("致命的エラー: システムを停止します")私自身、開発時はDEBUGレベルで詳細ログを出力し、本番運用時はINFOレベルに切り替えることで、ログファイルのサイズを抑えつつ、必要な情報を記録しています。

ログファイルをローテーションして管理する

長期間稼働する自動化スクリプトでは、ログファイルが肥大化する問題があります。

logging.handlers.RotatingFileHandlerを使うことで、ログファイルを自動でローテーションできます。

import logging

from logging.handlers import RotatingFileHandler

handler = RotatingFileHandler('app.log', maxBytes=10*1024*1024, backupCount=5)

formatter = logging.Formatter('%(asctime)s - %(levelname)s - %(message)s')

handler.setFormatter(formatter)

logger = logging.getLogger()

logger.setLevel(logging.INFO)

logger.addHandler(handler)

logging.info("ログローテーション設定完了")この設定により、ログファイルが10MBを超えると自動で新しいファイルに切り替わり、最大5世代まで保持されます。

Python自動化の実践的な学習には、Python Distilled ―プログラミング言語Pythonのエッセンスのような深い知識を学べる書籍も役立ちます。

また、Windsurfのようなツールを活用することで、開発効率をさらに向上させることができます。

まとめ

本記事では、Python自動化で日常業務を10倍効率化する実践的な手法を解説しました。

Python自動化は、繰り返し作業の排除と人的ミスの削減により、業務効率を劇的に向上させます。

自動化すべき業務を繰り返し頻度・作業時間・投資対効果で見極め、優先順位をつけることが成功の鍵です。

スクリプト設計では、関数化・モジュール化・設定ファイル・ログ出力を意識することで、再利用性・保守性・拡張性の高いスクリプトを作成できます。

実務で使えるログ集計・バックアップ・レポート生成・メール送信・API連携といったスクリプトを活用することで、即座に業務効率を向上させられます。

さらに、CI/CD連携により、スクリプトを自動実行させることで、手動実行の手間を完全に排除できます。

エラーハンドリング・リトライ処理・ログ管理を適切に実装することで、安定稼働する自動化基盤を構築できます。

私自身、プロジェクトマネージャーとして複数のチームでPython自動化を推進してきましたが、自動化により作業時間を60%削減し、エンジニアがより創造的な業務に集中できる環境を実現しました。

本記事で紹介した戦略を実践し、あなたのチームでもPython自動化による業務効率化を実現してください。