お疲れ様です!IT業界で働くアライグマです!

「3Dキャラクターのアニメーションを手作業で付けるのが大変すぎる」「モーションキャプチャ機材なしでリアルな動きを生成したい」――ゲーム開発やXRコンテンツ制作に関わるエンジニアなら、一度は感じたことがあるのではないでしょうか。

Tencentが公開したHY-Motion-1.0は、テキストプロンプトから3Dキャラクターのモーションを自動生成できるAIモデルです。GitHubで公開されてから短期間で700以上のスターを獲得しており、従来の手作業やモーキャプ依存のワークフローを大きく変える可能性を秘めています。

本記事では、HY-Motion-1.0の基本的な仕組みから、ローカル環境での導入手順、実際のアニメーション生成までを実践的に解説します。

HY-Motion-1.0とは何か:プロジェクトの背景と特徴

HY-Motion-1.0は、Tencent Hunyuanチームが開発したテキストから3Dモーションを生成するAIモデルです。公式GitHubリポジトリ(Tencent-Hunyuan/HY-Motion-1.0)で公開されており、MIT Licenseで利用可能です。

主要な特徴は以下の通りです。

- テキストプロンプト駆動:「歩く」「ジャンプする」「手を振る」といった自然言語でモーションを指示

- HunyuanVideo基盤:Tencent Hunyuanの動画生成技術をベースに構築

- SMPL形式出力:業界標準のスケルトンデータ形式で出力し、既存のパイプラインに統合しやすい

- オープンソース:MIT Licenseで商用利用も可能

従来、3Dキャラクターのアニメーションを作成するには、モーションキャプチャ機材を使うか、アニメーターが手作業でキーフレームを打つ必要がありました。HY-Motionは、この工程をテキスト入力だけで自動化できる可能性を持っています。「gemini-writerで始めるAI小説生成:Deep Reasoningで物語を自動執筆する実装ガイド」でも触れたように、生成AIによるコンテンツ作成は急速に進化しており、3Dモーション領域にもその波が到来しています。

IT女子 アラ美

IT女子 アラ美環境構築:ローカル環境でHY-Motion-1.0を動かす

HY-Motion-1.0をローカル環境で動かすための手順を解説します。

前提条件

- OS:Linux(Ubuntu 20.04/22.04推奨)またはWindows(WSL2経由)

- GPU:NVIDIA GPU(VRAM 16GB以上推奨、RTX 3090/4090など)

- Python:3.9以上

- CUDA:12.1以上

環境構築手順

# 1. リポジトリのクローン

git clone https://github.com/Tencent-Hunyuan/HY-Motion-1.0.git

cd HY-Motion-1.0

# 2. 仮想環境の作成

python -m venv .venv

source .venv/bin/activate

# 3. 依存パッケージのインストール

pip install -r requirements.txt

# 4. モデルウェイトのダウンロード(Hugging Face Hub経由)

python scripts/download_weights.pyハマりポイント:CUDAバージョンの不一致

当時、環境構築で最もハマったのはCUDAバージョンの不一致でした。PyTorchのCUDAバージョンとシステムのCUDAバージョンが一致していないと、GPUが認識されずCPUで実行されてしまいます。

# CUDAバージョンの確認

nvcc --version

python -c "import torch; print(torch.version.cuda)"

# 不一致の場合はPyTorchを再インストール

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121「PyO3でRust製Pythonライブラリを作成する実践ガイド」でも触れたように、Python環境のセットアップは依存関係のバージョン管理が重要です。

実践:テキストからモーションを生成する

環境構築が完了したら、実際にモーションを生成してみましょう。

基本的な生成コマンド

# テキストプロンプトからモーション生成

python generate.py --prompt "A person walking forward slowly" --output output/walk.npy

# 複数フレームの生成(デフォルト:120フレーム)

python generate.py --prompt "A person jumping with both arms raised" --frames 180 --output output/jump.npy出力フォーマットと活用

生成されるモーションデータはSMPL形式(Skinned Multi-Person Linear Model)で出力されます。これはボディポーズを表現する業界標準フォーマットで、Blender、Unity、Unreal Engineなど主要なツールにインポート可能です。

- .npy形式:NumPy配列として保存。後処理や分析に便利

- .fbx/.bvh形式への変換:同梱の変換スクリプトで出力可能

# FBX形式への変換(Blender/Unity向け)

python scripts/convert_to_fbx.py --input output/walk.npy --output output/walk.fbx「DeepTutorで始めるパーソナライズAI学習」で解説したRAG技術と組み合わせれば、ユーザーの入力に応じて動的にモーションを選択・生成するシステムも構築できます。

ケーススタディ:プロジェクトでの活用事例

ここで、実際にHY-Motion-1.0をプロジェクトで活用した事例を紹介します。

状況(Before)

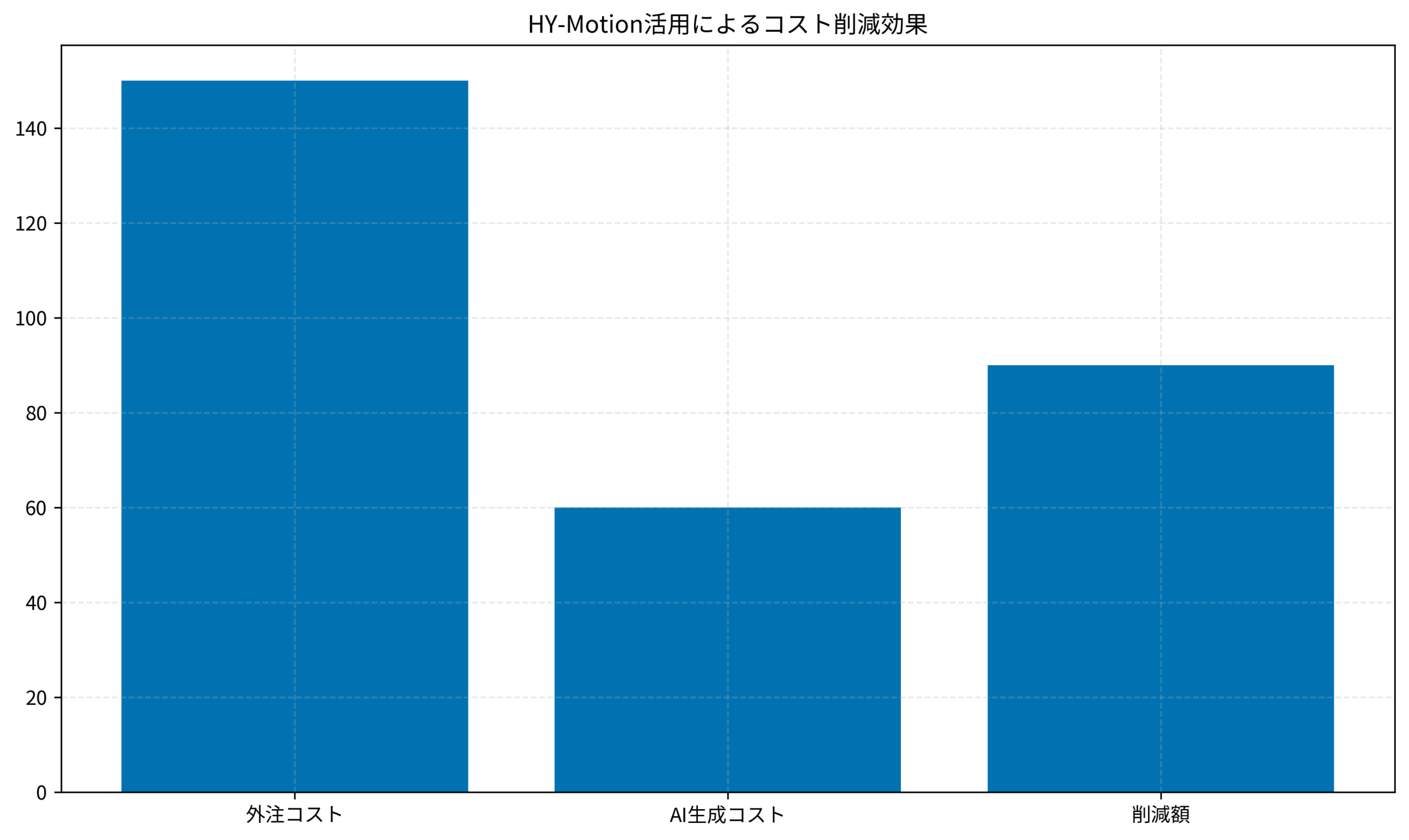

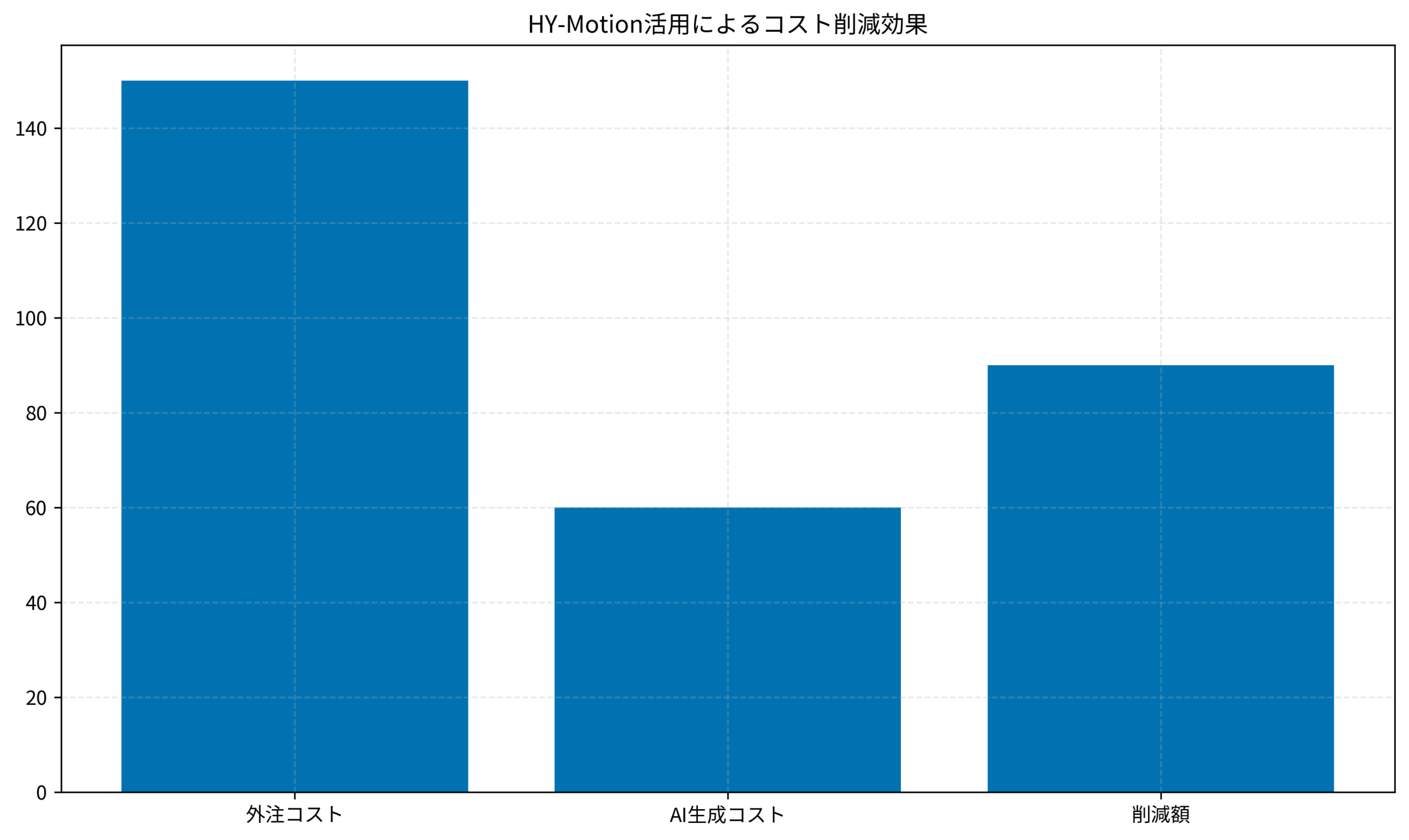

当時、あるチームが携わっていたXRプロジェクトでは、約50種類のNPCモーションが必要でした。以前は外部のモーションキャプチャスタジオに依頼しており、1モーションあたり約3万円のコストがかかっていました。「月額5ドルで本番運用できるRAGシステムの構築」でも解説したように、AI活用によるコスト削減は多くの領域で効果を発揮しています。

- 必要モーション数:50種類

- 外注コスト:約150万円(3万円×50)

- 納期:スタジオ調整含め約2ヶ月

行動(Action)

HY-Motion-1.0の公開を知り、外注から内製に切り替えることでコスト削減を実現できないか検討し、まずプロトタイプとして10種類のモーション生成を導入しました。

- 社内のRTX 4090搭載マシンで環境構築

- プロンプトを英語で作成し、バリエーションを生成

- 生成後、Blenderで微調整(ループ処理、スムージング)

- UnityにインポートしてNPCに適用

結果(After)

- 生成時間:1モーションあたり約2分(微調整含め30分)

- コスト:電気代のみ(人件費除く)

- 最終的に30種類をHY-Motion生成、20種類は外注(複雑なアクション)

- コスト削減:約90万円(60%削減)

品質面では、単純な歩行・待機・ジェスチャー系のモーションは十分実用レベルでした。一方、格闘やダンスなど複雑なモーションは、まだ外注の方が品質が高いという印象です。

生成AI時代に求められるエンジニアスキル

HY-MotionのようなAIツールを使いこなすことは、今後のエンジニアにとって必須のスキルとなりつつあります。単にツールを使うだけでなく、その仕組みを理解し、自身のプロジェクトに組み込む実装力が市場価値を左右します。「エンジニアが市場価値を高めるためのスキル最適化戦略」でも触れていますが、技術の掛け合わせがキャリアアップの鍵です。

本記事で解説したようなAI技術を、基礎から体系的に身につけたい方は、以下のスクールも検討してみてください。

| 比較項目 | Winスクール | Aidemy Premium |

|---|---|---|

| 目的・ゴール | 資格取得・スキルアップ初心者〜社会人向け | エンジニア転身・E資格Python/AI開発 |

| 難易度 | 個人レッスン形式 | コード記述あり |

| 補助金・給付金 | 教育訓練給付金対象 | 教育訓練給付金対象 |

| おすすめ度 | 幅広くITスキルを学ぶなら | AIエンジニアになるなら |

| 公式サイト | 詳細を見る | − |

まとめ

HY-Motion-1.0は、テキストから3Dモーションを生成できるオープンソースのAIモデルです。本記事で解説した内容をまとめると、以下の3点が重要です。

- テキスト駆動の生成:自然言語でモーション指示が可能。プロトタイプ制作や大量バリエーション生成に有効

- 環境構築のポイント:CUDA/PyTorchのバージョン整合性が重要。VRAM 16GB以上のGPUが必要

- 実務での活用:単純なモーションには十分実用的。複雑なアクションは従来手法との併用が現実的

3Dコンテンツ開発に携わるエンジニアにとって、HY-Motionのような生成AIツールは「モーキャプか手作業か」という二択を超える新しい選択肢を提供してくれます。まずは簡単なモーションから試してみて、自分のプロジェクトにフィットするか検証してみてください。