お疲れ様です!IT業界で働くアライグマです!

「CursorのAI機能は便利だけど、APIコストが気になる…」

「ローカルLLMを使いたいけど、設定が複雑そうで手が出せない…」

こんな悩みを抱えているエンジニアの方は多いのではないでしょうか。

私自身、PjMとしてチームの開発環境を整備する中で、Cursor×Ollamaの組み合わせがコスト削減と開発効率の両立に非常に効果的だと実感しています。

本記事では、CursorとOllamaを連携させてローカルAI開発環境を構築する方法を、実際の設定手順とともに解説します。

月額数万円のAPIコストを数百円レベルに抑えながら、高速なコード補完を実現する構成をお伝えします。

ローカルLLM開発環境の全体像とメリット

まず、ローカルLLM開発環境がなぜ注目されているのか、その背景を整理しておきましょう。

クラウドAPIを使ったAI開発は便利ですが、コスト・プライバシー・レイテンシの3つの課題があります。

特にチーム開発では、メンバー全員がAPIを叩くとコストが膨らみやすく、機密性の高いコードを外部に送信することへの懸念もあります。

ローカルLLMを使えば、これらの課題を一気に解決できます。

初期のハードウェア投資は必要ですが、ランニングコストはほぼゼロ。

コードは自分のマシン内で完結するため、セキュリティ面でも安心です。

私のチームでは、以前はGPT-4のAPIを使っていましたが、メンバー5人で月額3万円近くかかっていました。

ローカルLLMに切り替えてからは、そのコストがほぼゼロになり、浮いた予算を他のツールやトレーニングに回せるようになりました。

ローカルLLMの基本的な構築方法については、ローカルLLM環境構築ガイドも参考にしてください。

開発環境の効率化を体系的に学ぶには、AI駆動開発完全入門 ソフトウェア開発を自動化するLLMツールの操り方でAI駆動開発の全体像を把握しておくと、ツール選定の判断基準が明確になります。

ローカルLLM開発環境の全体像とメリット

Cursor×Ollamaの環境を構築する前に、必要なスペックと前提条件を確認しておきましょう。

推奨スペック

ローカルLLMを快適に動かすには、以下のスペックが目安になります。

- GPU:NVIDIA RTX 3060以上(VRAM 8GB以上推奨)

- RAM:16GB以上(32GB推奨)

- ストレージ:SSD 50GB以上の空き容量

- OS:Windows 10/11、macOS 12以上、Ubuntu 20.04以上

Apple Siliconを搭載したMacの場合、M1以上であれば十分な性能が出ます。

私のチームでは、M2 Pro搭載のMacBook Proで7Bパラメータのモデルを快適に動かしています。

使用するツール

今回の構成で使用するツールは以下のとおりです。

- Cursor:AI機能を内蔵したコードエディタ(VSCode派生)

- Ollama:ローカルLLMを簡単に動かせるランタイム

- CodeQwen 7B / DeepSeek Coder:コード生成に特化したモデル

Cursorの詳細な設定方法については、CursorでローカルLLMを使う完全ガイドも参考にしてください。

開発効率を上げるには、SOLID CODE 高品質なコードを生み出す実践的開発手法でコーディングのベストプラクティスを学んでおくと、AIが生成したコードの品質を判断しやすくなります。

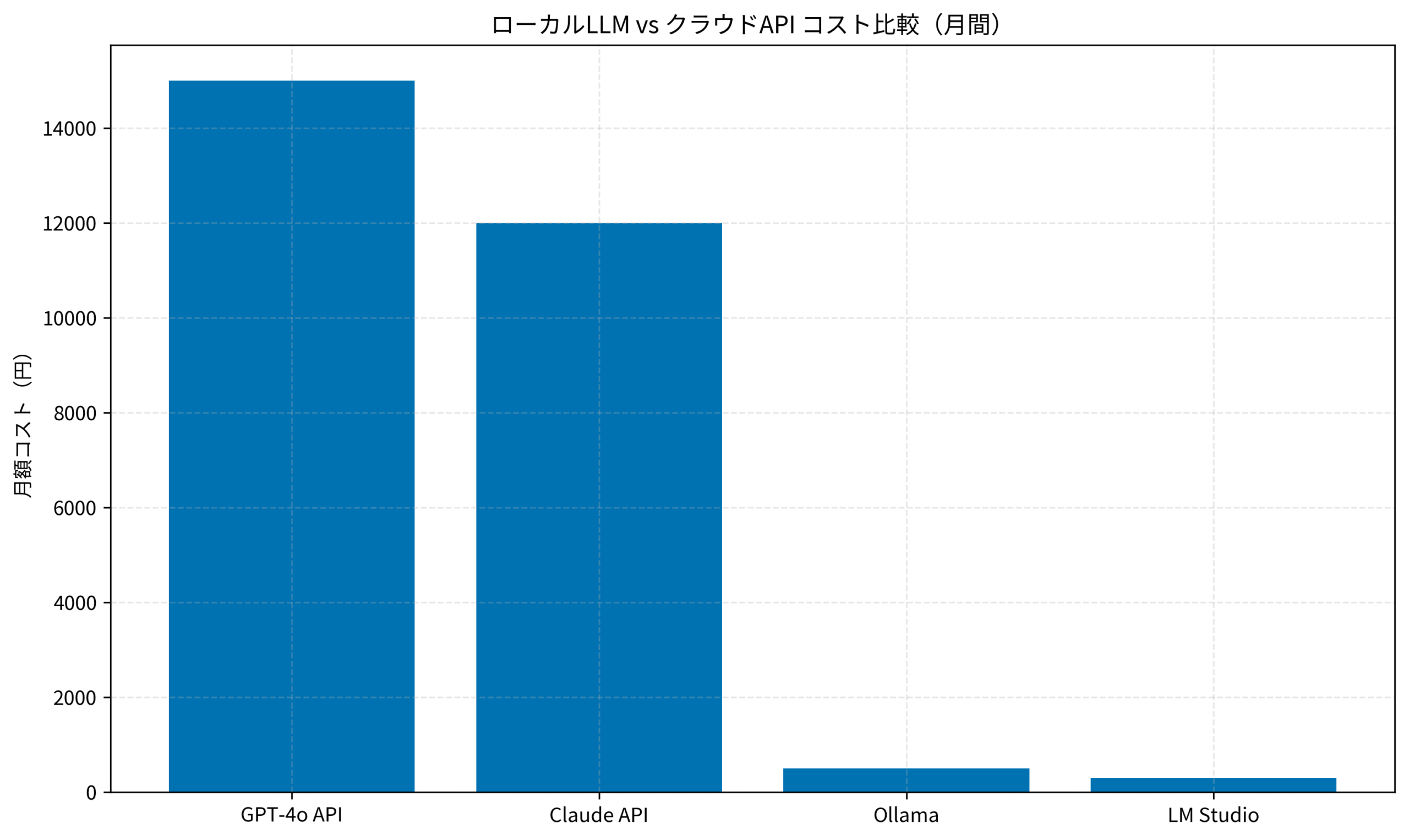

以下のグラフは、クラウドAPIとローカルLLMの月間コストを比較したものです。

GPT-4oやClaude APIを日常的に使うと月額1万円以上かかりますが、Ollamaなら電気代程度で済みます。

Ollamaのインストールと初期設定

それでは、実際にOllamaをインストールしてモデルをダウンロードしていきましょう。

Ollamaは、ローカルLLMを簡単に動かすためのオープンソースツールです。

Dockerのようにモデルをpull/runするだけで使えるため、複雑な環境構築が不要なのが特徴です。

Ollamaのインストール

Ollamaのインストールは非常にシンプルです。

公式サイトからインストーラをダウンロードするか、以下のコマンドを実行します。

WindowsユーザーはMicrosoft Storeからもインストールできます。

# macOS / Linux

curl -fsSL https://ollama.com/install.sh | sh

# Windows(PowerShell)

winget install Ollama.Ollamaインストールが完了したら、ターミナルで以下のコマンドを実行してバージョンを確認します。

ollama --version

# ollama version is 0.4.xコード生成用モデルのダウンロード

Cursorと組み合わせる場合、コード生成に特化したモデルを選ぶのがポイントです。

私のおすすめは以下の2つです。

# CodeQwen 7B(軽量で高速)

ollama pull codeqwen:7b

# DeepSeek Coder 6.7B(精度重視)

ollama pull deepseek-coder:6.7bモデルのダウンロードには数分〜十数分かかります。

ダウンロード完了後、以下のコマンドでモデルが正常に動作するか確認しましょう。

初回起動時はモデルのロードに数秒かかりますが、2回目以降はキャッシュが効いて高速に応答が返ってきます。

ollama run codeqwen:7b "Write a Python function to calculate fibonacci"Ollamaと他のエディタとの連携については、Ollama×Voidエディタ設定ガイドも参考になります。

コードの品質を保つには、Clean Code アジャイルソフトウェア達人の技でクリーンコードの原則を学んでおくと、AIが生成したコードのリファクタリング判断がしやすくなります。

CursorとOllamaの連携設定

OllamaとCursorを連携させる設定を行いましょう。

この設定により、Cursorのコード補完やチャット機能でローカルLLMを使えるようになります。

CursorはOpenAI互換のAPIエンドポイントに対応しているため、Ollamaが提供するAPIをそのまま利用できます。

Ollamaサーバーの起動

まず、Ollamaをサーバーモードで起動します。

Ollamaはデフォルトでバックグラウンドサービスとして動作しますが、明示的に起動する場合は以下のコマンドを実行してください。

# Ollamaサーバーを起動

ollama serve

# バックグラウンドで起動する場合

nohup ollama serve &サーバーが起動すると、デフォルトでhttp://localhost:11434でAPIが公開されます。

以下のコマンドで動作確認ができます。

curl http://localhost:11434/api/tags

# 利用可能なモデル一覧が返ってくればOKCursorの設定

Cursorを開き、設定画面からローカルLLMを使う設定を行います。

- Settings → Models → OpenAI API Baseに

http://localhost:11434/v1を入力 - Model Nameに

codeqwen:7bまたはdeepseek-coder:6.7bを入力 - API Keyは空欄または任意の文字列でOK(Ollamaは認証不要)

私のチームでは、この設定を.cursor/settings.jsonに記述してGitで共有しています。

新メンバーが参加したときも、リポジトリをクローンするだけで同じ環境が再現できるのが便利です。

モデルの使い分け

実際の開発では、タスクに応じてモデルを使い分けるのが効果的です。

- CodeQwen 7B:日常的なコード補完や簡単なリファクタリングに最適。軽量で高速なため、ストレスなく使えます。

- DeepSeek Coder 6.7B:複雑なロジックの実装やデバッグ支援に向いています。精度が高い分、応答に少し時間がかかります。

- Llama 3.2:汎用的なタスクやドキュメント作成に便利。コード以外の質問にも対応できます。

私のチームでは、普段はCodeQwen 7Bを使い、複雑な実装やレビュー時にはDeepSeek Coderに切り替える運用をしています。

モデルの切り替えはollama run モデル名で簡単にできるので、状況に応じて柔軟に対応できます。

Cursorのセキュリティ設定については、Cursorのセキュリティ・プライバシー設定ガイドも確認しておくと安心です。

チーム開発の設計パターンを学ぶには、Clean Architecture 達人に学ぶソフトウェアの構造と設計でアーキテクチャの基本を押さえておくと、AI支援ツールの導入判断がしやすくなります。

まとめ

本記事では、Cursor×Ollamaを組み合わせたローカルAI開発環境の構築方法を解説しました。

要点を整理します。

- コスト削減:クラウドAPIの月額1万円以上が、ローカルLLMなら電気代程度に

- プライバシー確保:コードを外部に送信せず、ローカルで完結

- 高速レスポンス:ネットワーク遅延がなく、即座にコード補完が返ってくる

- 推奨モデル:CodeQwen 7B(軽量高速)またはDeepSeek Coder 6.7B(精度重視)

まずはOllamaをインストールして、CodeQwen 7Bを試してみてください。

GPUがなくても、Apple Silicon搭載Macや最新のCPUであれば十分実用的な速度で動作します。

インストールから動作確認まで30分もあれば完了するので、週末の空き時間に試してみるのがおすすめです。

ローカルLLMの世界は日々進化しています。

新しいモデルが登場したら、ollama pullで簡単に試せるのもOllamaの魅力です。

ぜひ自分のワークフローに合ったモデルを見つけて、AI開発の効率化を進めてみてください。

今後もローカルLLMの性能は向上し続けるでしょう。

クラウドAPIとローカルLLMを状況に応じて使い分けるハイブリッド構成も、今後の選択肢として検討してみてください。

コスト削減とプライバシー確保を両立しながら、AI支援開発の恩恵を最大限に活用していきましょう。

ローカルLLMの導入は、開発チームの生産性向上とコスト最適化の第一歩として、ぜひ検討してみてください。

この記事が、皆さんのAI開発環境構築の参考になれば幸いです。