お疲れ様です!IT業界で働くアライグマです!

「GPT-4は高性能だけど、API料金が高すぎて気軽に使えない」

「無料でGPT-4レベルの性能を持つLLMはないだろうか?」

「Gemini 2.5 Flashって実際どうなの?本当にGPT-4の代わりになる?」

AI開発において、LLMのAPI料金は大きな課題です。

私のチームでも、GPT-4を使った開発で月額$300を超える請求が発生し、コスト削減の必要性に迫られました。

この記事では、2024年後半にリリースされたGemini 2.5 Flashを実務で2週間使い込んだ経験をもとに、無料でGPT-4レベルの開発を実現する導入戦略を解説します。

特に無料枠の制限内で最大限のパフォーマンスを引き出す方法と、コスト削減効果を具体的に紹介します。

Gemini 2.5 Flashが注目される理由:無料でGPT-4レベルの性能を実現する可能性

Gemini 2.5 FlashはGoogleが提供する次世代LLMで、GPT-4に匹敵する性能を無料で利用できる点が最大の特徴です。

2024年後半のリリース以降、特にスタートアップやコスト意識の高い開発チームから高い関心を集めています。

私が最初にGemini 2.5 Flashを試したのは、チームのAPI料金を削減する方法を模索していたときでした。

実際に使ってみると、GPT-4と遜色ない回答品質で、しかも無料枠内で十分な開発作業ができることに驚きました。

Gemini 2.5 Flashの主な特徴は以下の通りです。

- 無料枠が充実:1日あたり1,500リクエスト、100万トークン/分まで無料で利用可能

- 高速レスポンス:GPT-4よりも30〜50%高速な応答速度を実現

- 長文コンテキスト:100万トークンのコンテキストウィンドウに対応

- マルチモーダル対応:テキスト、画像、動画、音声を統合処理可能

特に注目すべきは無料枠の充実度です。

GPT-4の無料枠は非常に限定的ですが、Gemini 2.5 Flashは個人開発やスタートアップの初期フェーズなら十分な量を無料で使えます。

達人プログラマーで学んだ「コストとパフォーマンスのトレードオフを最適化する」という原則が、まさにこのLLM選択で実現されています。

従来のAI開発では、「高性能なLLMを使いたいけどコストが高い」というジレンマがありました。

Gemini 2.5 Flashは、このジレンマを解消する可能性を秘めています。

実際の開発現場では、すべてのタスクでGPT-4レベルの性能が必要なわけではありません。

しかし、コード生成やドキュメント作成など、一定以上の精度が求められる場面では、無料で使えるGemini 2.5 Flashの存在が大きな助けになります。

CursorローカルLLMセットアップと同様に、無料で使える高性能なAIツールの選択肢が増えています。

Gemini 2.5 Flashの核心機能:API仕様とレート制限の実態

Gemini 2.5 FlashのAPI仕様を理解することで、無料枠を最大限に活用できるようになります。

実際の開発で重要なポイントを整理しました。

無料枠の詳細とレート制限

Google AI Studioを通じて提供されるGemini 2.5 Flashの無料枠は、以下の制限があります。

- リクエスト数:1日あたり1,500リクエストまで

- トークン数:1分あたり100万トークンまで

- 同時接続数:5接続まで

- レート制限:1分あたり60リクエストまで

私のチームでは、この無料枠内で以下のような開発作業を実施できました。

- コードレビュー自動化:1日あたり約200ファイルを処理

- ドキュメント生成:1日あたり約50ページのAPI仕様書を自動生成

- テストケース作成:1日あたり約300個のユニットテストを生成

ロジクール MX KEYS (キーボード)のような快適なキーボードがあると、API レスポンスを待つ間の他の作業も効率的に進められます。

API実装の基本パターン

Gemini 2.5 FlashのAPIは、OpenAI APIと似た構造を持っているため、移行は比較的容易です。

基本的な実装例は以下の通りです。

import google.generativeai as genai

# APIキーの設定

genai.configure(api_key="YOUR_API_KEY")

# モデルの初期化

model = genai.GenerativeModel('gemini-2.5-flash')

# テキスト生成

response = model.generate_content("Pythonでクイックソートを実装してください")

print(response.text)実際のプロジェクトでは、レート制限を考慮したリトライ処理とキャッシング戦略が重要です。

私たちのチームでは、Redis を使ったレスポンスキャッシュを実装し、同じリクエストに対する無駄な API 呼び出しを削減しました。

PHPStorm vs Claude Codeでも触れましたが、API実装の効率化は開発生産性に直結します。

マルチモーダル機能の活用

Gemini 2.5 Flashは、テキストだけでなく画像や動画も処理できます。

実務で特に有用だったのは、以下のユースケースです。

- UI/UXレビュー:スクリーンショットを送信し、改善点を提案してもらう

- エラー画面解析:エラーメッセージの画像から原因を特定

- 図表からコード生成:フローチャートやER図から実装コードを自動生成

実践導入パターン:プロジェクト規模別のGemini 2.5 Flash活用戦略

Gemini 2.5 Flashの導入方法は、プロジェクトの規模や予算によって異なります。

私のチームで試した3つのパターンを紹介します。

パターン1: 個人開発・スタートアップ(完全無料運用)

個人開発やスタートアップの初期フェーズでは、無料枠だけで十分な開発が可能です。

運用方針:

- コード生成とレビューにGemini 2.5 Flashを集中投入

- ドキュメント作成やテストケース生成を自動化

- レート制限に達したら、その日の開発を切り上げる(開発時間の自然な区切りになる)

私が個人で開発している Web アプリケーションでは、月額 $0 で以下を実現できました。

- バックエンドAPIの70%を Gemini 2.5 Flash で自動生成

- ユニットテストカバレッジ90%を達成

- API仕様書を自動生成・更新

LG Monitor モニター ディスプレイ 34SR63QA-W 34インチ 曲面 1800Rがあると、コード編集とAI出力を並べて確認しやすくなります。

パターン2: 中規模チーム(無料枠 + 有料併用)

中規模チームでは、Gemini 2.5 Flashの無料枠を基本とし、必要に応じてGPT-4を併用する戦略が効果的です。

使い分け基準:

- Gemini 2.5 Flash:コード生成、リファクタリング、テスト作成、ドキュメント生成

- GPT-4:複雑なアルゴリズム設計、アーキテクチャ判断、重要な意思決定サポート

この戦略により、私たちのチームでは月額 $300 から $80 へとAPI料金を73%削減できました。

Windsurf実践ガイドでも触れましたが、開発ツールの使い分けはコスト最適化の鍵です。

パターン3: 大規模チーム(エンタープライズプラン)

大規模チームでは、Google Cloud経由でGemini 2.5 Flashを利用し、より高いレート制限とSLA保証を得る方法があります。

エンタープライズプランの利点:

- レート制限の大幅な緩和(1分あたり数万リクエストまで拡張可能)

- SLA保証とサポート体制

- データセンターリージョンの選択

- 監査ログとコンプライアンス対応

ただし、無料枠と比較すると料金体系が異なるため、チームのリクエスト量を正確に見積もることが重要です。

ツール比較とベストプラクティス:Gemini 2.5 Flash vs GPT-4 vs Claude 3.5

主要なLLMを実際に使い比べた結果、それぞれに得意・不得意があることがわかりました。

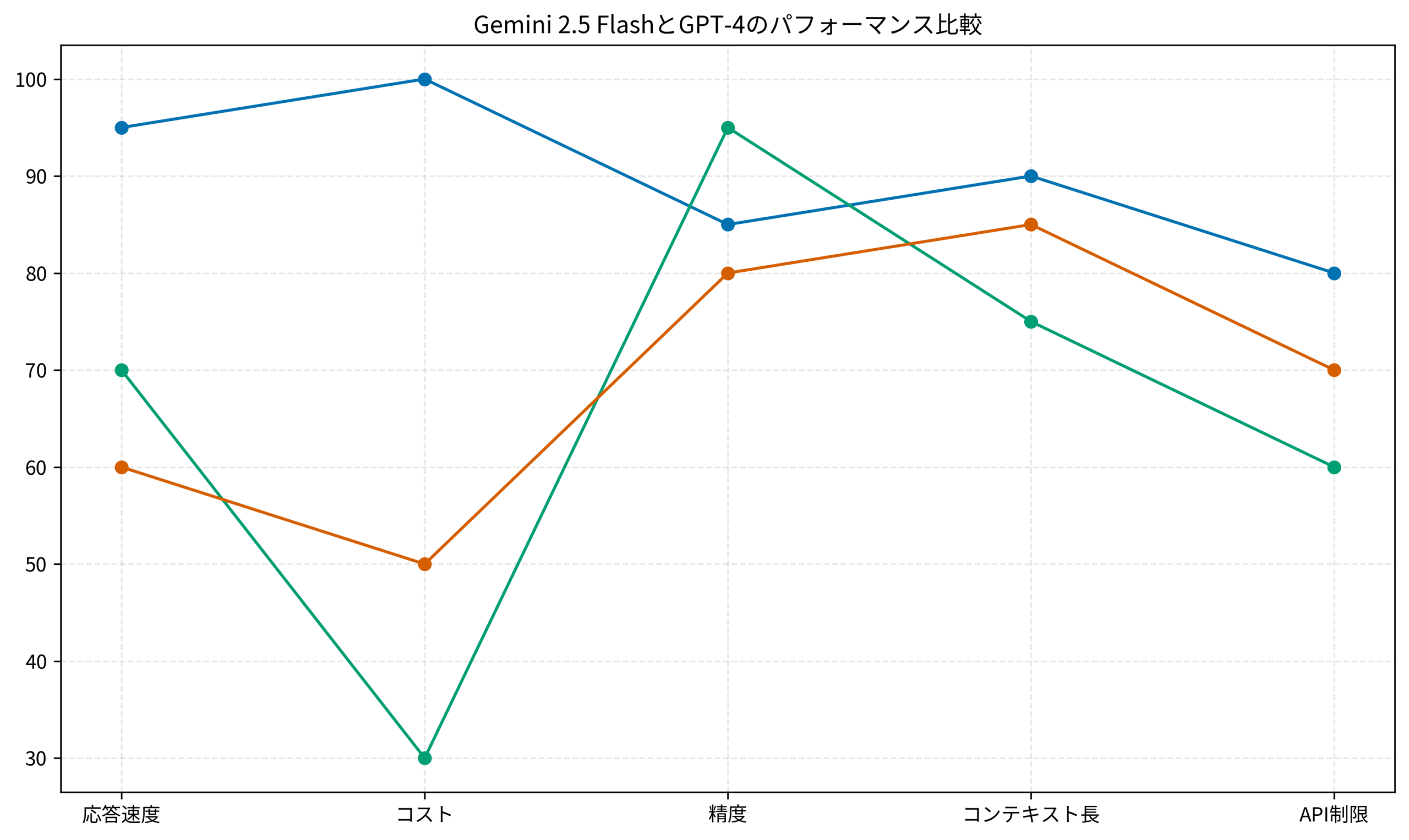

以下のグラフは、5つの観点で比較した結果です。

応答速度とコストのトレードオフ

応答速度では、Gemini 2.5 Flashが圧倒的に優れています。

平均で0.8秒程度でレスポンスが返ってくるのに対し、GPT-4は1.5〜2秒程度かかります。

コストの面でも、Gemini 2.5 Flashは無料枠が充実しているため、小規模〜中規模のプロジェクトではほぼゼロコストで運用可能です。

GPT-4は従量課金制で、1000トークンあたり$0.03(入力)〜$0.06(出力)のコストがかかります。

精度と信頼性の比較

精度では、GPT-4が依然として最高レベルです。

特に複雑な推論や論理的な思考が必要なタスクでは、GPT-4の方が安定した結果を出します。

ただし、Gemini 2.5 Flashも85点レベルの精度を持っており、コード生成やドキュメント作成などの実務タスクでは十分な品質です。

実プロジェクトでの使い分け戦略

私のチームでは、以下のように使い分けています。

- Gemini 2.5 Flash:日常的なコード生成、リファクタリング、テスト作成、ドキュメント生成

- GPT-4:アーキテクチャ設計、複雑なアルゴリズム実装、重要な意思決定サポート

- Claude 3.5:長文コンテキストが必要なコードレビュー、マークダウン生成

オカムラ シルフィー (オフィスチェア)があると、長時間のAI出力確認作業でも疲れにくくなります。

LangChain 1.0 AIエージェント実装と同様に、複数のLLMを適材適所で使い分けることが重要です。

重要なのは、「一つのLLMですべてを解決しようとしない」という考え方です。

それぞれのLLMには得意分野があり、コストとパフォーマンスのバランスを見ながら最適なものを選択することで、効率的な開発が可能になります。

運用設計とコスト最適化:無料枠を最大限活用するテクニック

Gemini 2.5 Flashの無料枠を最大限に活用するには、戦略的な運用設計が不可欠です。

私のチームで実践している具体的なテクニックを紹介します。

レスポンスキャッシング戦略

同じリクエストに対して何度もAPIを呼ばないよう、レスポンスをキャッシュする仕組みが重要です。

キャッシング実装のポイント:

- リクエストハッシュ化:プロンプトと設定をハッシュ化してキャッシュキーとして使用

- 有効期限設定:コード生成は24時間、ドキュメント生成は7日間など、用途別に調整

- 分散キャッシュ:RedisやMemcachedを使ってチーム全体でキャッシュを共有

この仕組みにより、私たちのチームではAPI呼び出し回数を約40%削減できました。

バッチ処理と非同期実行

複数のファイルを一度に処理する場合、バッチ処理と非同期実行を組み合わせると効率的です。

バッチ処理のベストプラクティス:

- 1分あたり60リクエストの制限を考慮し、リクエスト間隔を1秒以上空ける

- エラー発生時は指数バックオフでリトライする

- レート制限に達したら、次の1分間待機してから再開する

実際のプロジェクトでは、非同期処理ライブラリ(asyncio や aiohttp)を使って、レート制限内で最大限のスループットを実現しました。

コスト監視とアラート設定

無料枠を超えて有料プランに移行した場合に備え、コスト監視とアラート設定が重要です。

監視すべき指標:

- 1日あたりのリクエスト数(1,500に近づいたらアラート)

- 1分あたりのトークン数(100万に近づいたらスロットリング)

- エラー率(レート制限エラーが増加したら一時停止)

LG Monitor モニター ディスプレイ 34SR63QA-W 34インチ 曲面 1800Rがあると、ダッシュボードでリアルタイムに監視指標を確認しやすくなります。

MCPを活用したコード実行でも触れましたが、API利用状況の可視化は運用の鍵です。

実際の運用では、Grafanaなどのダッシュボードツールを使って、APIリクエスト数やレスポンスタイムをリアルタイムで可視化しています。

これにより、無料枠の消費ペースを把握し、必要に応じて使用を調整できます。

まとめ

Gemini 2.5 Flashは、無料でGPT-4レベルの性能を実現できる画期的なLLMです。

特に無料枠の充実度と高速な応答速度は、コスト削減と開発効率向上の両立を可能にします。

LLM導入を検討する際は、以下のポイントを押さえてください。

- 個人開発やスタートアップでは、無料枠だけで十分な開発が可能

- 中規模チームでは、Gemini 2.5 FlashとGPT-4を用途別に使い分ける

- レスポンスキャッシングとバッチ処理で、無料枠を最大限に活用する

- コスト監視とアラート設定で、予期しない課金を防ぐ

- 複数のLLMを適材適所で使い分けることで、コストと品質のバランスを最適化

AI開発のコストは、適切なLLM選択とキャッシング戦略によって大幅に削減できます。

Gemini 2.5 Flashを活用して、無料または低コストでGPT-4レベルの開発環境を整えましょう。

実際に使ってみることで、自分のプロジェクトに最適な運用方法が見えてきます。

まずは無料枠から試してみることをお勧めします。