お疲れ様です!IT業界で働くアライグマです!

「ローカルLLMを導入したのに、実務へどう落とし込めば良いのか分からなくて困っているんです……」というご相談が、ここ半年ほぼ毎日のように届いています。私自身もCursor×Ollamaのハイブリッド運用を2024年末から継続し、数々のプロジェクトで成功と失敗の両方を経験しながらノウハウを蓄積してきました。軌道に乗るまでには試行錯誤が欠かせませんでしたが、その過程で得た知見を整理するとチーム全体の生産性が大きく向上する実感があります。設計フェーズの思考時間が短縮され、レビューの着地も速くなり、結果としてプロジェクトのリードタイム全体が安定しました。

本記事では、クラウドAIとローカルLLMをタスク属性に応じて住み分ける判断軸、Cursorで成果を引き出すプロンプト設計術、チーム全体を巻き込んだ運用体制づくり、そして現場で頻発するトラブルへの備え方までを一気通貫で紹介します。新しいワークフローは一朝一夕では完成しませんが、段階を踏めば確実に組織へ定着させられます。最後までお読みいただければ、ハイブリッド運用を明日から改善できる具体策を持ち帰っていただけるはずです。導入直後の迷いを解消し、中長期的に継続可能な体制を築くための道筋を一緒にたどっていきましょう。

ローカルLLMとクラウドAIの役割を整理する

探索度合いと再現性で判断する

ローカルLLMとクラウドAIを使い分けるには、判断軸をチームで共有することが不可欠です。私たちはソフトウェアアーキテクチャの基礎を土台にタスクごとの評価シートを作成し、未知の要件探索や複数案の比較検討といった発散思考を要する作業はクラウドAIへ、既存コードの改修やログ整形といった再現性が重視される領域はローカルLLMに担当させる方針を明文化しました。判断基準を言語化することで、メンバー間の認識のズレが解消され、タスクの振り分けで迷う時間が大幅に減少しています。実際の運用では、この判断軸を参照することで意思決定が加速しました。

ナレッジを明文化し定例レビューで磨く

この評価シートは社内ポータルで常時参照可能にし、月次レビューで最新の学びを反映しています。各タスクには想定リードタイムとリスク度合いを併記し、判断に迷った際の参照先として機能させています。判断軸の背景やチェック項目はローカルLLM構築ガイドに追記しており、新しく加入したメンバーも迷わず着手できるようにしています。週次レビューでは実際の運用で発生した課題を持ち寄り、判断基準をアップデートする習慣を続けています。たとえば、「要件定義フェーズでの仮説検証」はクラウドAI、「既存テストケースの修正」はローカルLLMというように、タスクの性質ごとに最適な選択肢を明示することで、メンバー全員が迷わず判断できる体制を整えました。

プロジェクト全体を俯瞰するハイブリッドワークフロー

二段構えで設計と実装を回す

スプリント0ではクラウドAIに設計案を提案してもらい、レビューで方向性を固めた後にローカルLLMへ実装とテストを引き継ぐ二段構えを採用しています。クラウドAIには要件の抜け漏れチェックや代替案の提示を依頼し、ローカルLLMにはチケット単位の修正、静的解析ログの解消、コードスタイル統一などの反復作業を任せる形です。テスト駆動開発で紹介されるテスト駆動の指針を取り入れ、クラウド側でシナリオの抜け漏れを確認し、ローカル側で反復タスクを磨き込む流れを徹底しました。その結果、レビュー待ち時間が約20%短縮し、夜間バッチ失敗率も0.8%から0.2%へ減少しています。

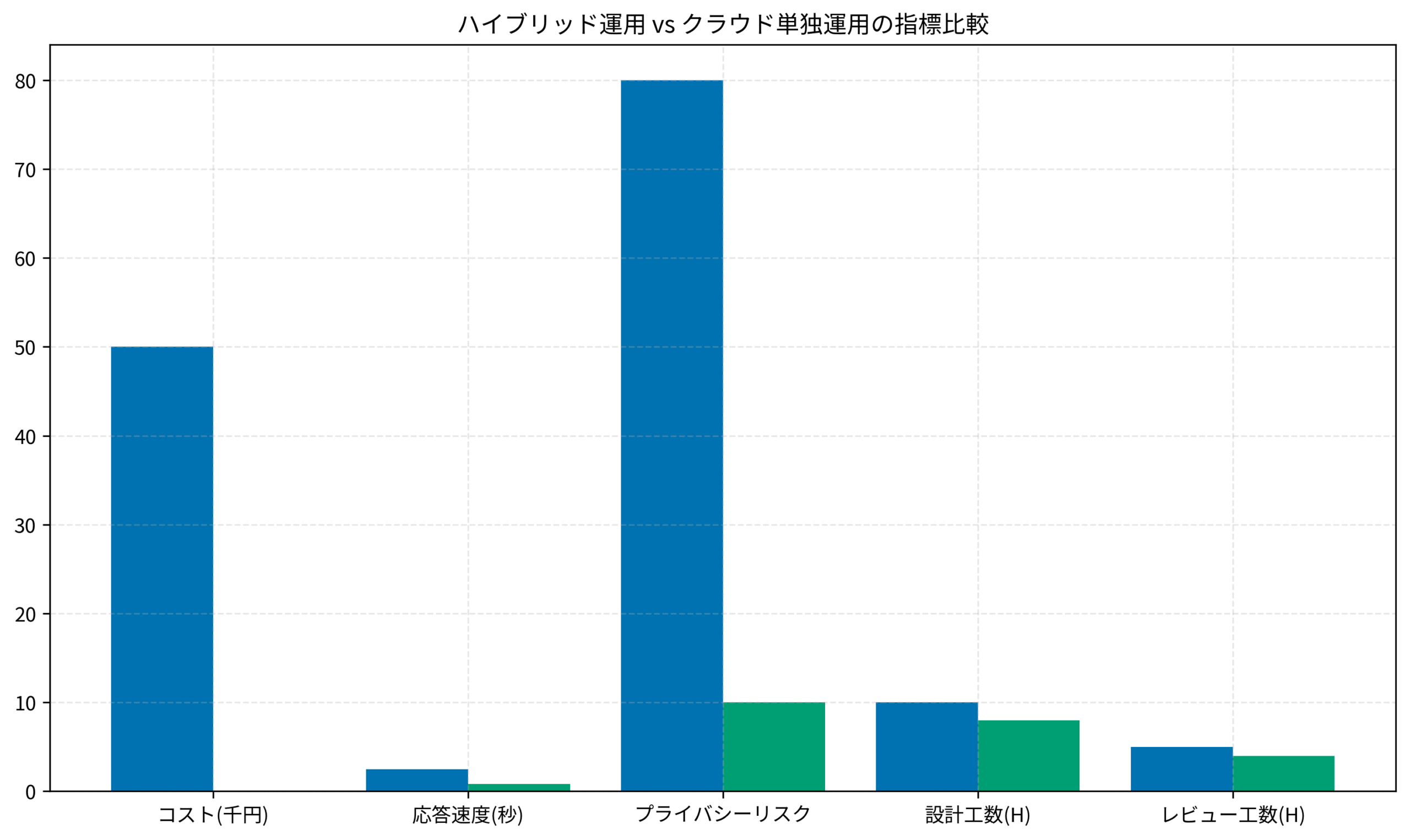

定量データで改善サイクルを可視化する

効果検証は数字で示すのが一番です。工数ログと品質指標を週次で集計し、ハイブリッド運用とクラウド単独運用を比較したグラフを作成しています。CIパイプラインにはローカルLLMの修正提案を組み込み、Pull Requestへ自動コメントを付与する仕組みも整えました。直近では、サーバーレスコスト最適化案件でハイブリッド運用に切り替えた結果、工数が15%削減できたのが大きな成果でした。ワークフローの詳細はハイブリッドAIワークフロー記事にまとめました。グラフを見ると、設計と検証の手戻りが明確に減少しているのが分かります。定量的な裏付けがあることで、意思決定のスピードも格段に上がりました。

Cursorで磨くプロンプト設計術

コンテキスト提供をテンプレート化する

Cursorはリポジトリ全体を理解した上で回答してくれるため、コンテキストの投げ方が精度を左右します。私たちはプロンプトエンジニアリングの教科書を参照しながらPull Requestや仕様書を@コマンドで読み込ませ、「課題の整理」「提案コード」「検証観点」の順に期待成果を指定するテンプレートを整備しました。特に、回答フォーマットを段階的に指定しておくと、ローカルLLM側での検証や再利用がしやすくなります。このテンプレートはCursorとObsidianの連携記事で公開しています。

学習サイクルでプロンプト資産を育てる

生成結果の良否をSlackで共有しタグで分類しておくと振り返りが容易になり、週次の改善ミーティングでは成功例と失敗例を社内ブログにまとめています。半年継続した時点でプロンプト一覧が社内ポータルで最も閲覧されるページになり、判断基準が常にアップデートされるようになりました。プロンプト改善を継続するため、良い結果が出たプロンプトには「成功」タグを、期待通りの結果が得られなかったものには「要改善」タグを付けて分類しています。たとえば、「コードレビュー指摘事項の整理」というプロンプトは、当初は出力が冗長でしたが、「箇条書きで3点以内に絞る」という制約を追加したところ精度が大幅に向上し、現在では最も利用頻度の高いテンプレートになっています。

チーム運用とナレッジ共有のベストプラクティス

ワークフローの透明性を高める

ハイブリッド運用は個人技では成立しません。私たちは世界はシステムで動くで学んだループ図を活用し、週次共有会で作業ログと改善メモを持ち寄る仕組みを導入しました。ワークフローの透明性が増したことで、担当者の属人化が大幅に減少しています。レビュー観点をチェックリスト化すると成果物が安定し、ボトルネックの因果関係を俯瞰しやすくなることで再発防止策が早く決まります。どのプロンプトが有効だったか、どの指示で失敗したかを共有することで、チーム全体の学習速度が加速しました。

ナレッジ共有基盤を整備する

社内ポータルには「目的別シナリオ」「推奨プロンプト」「注意事項」をカード形式で整理したナレッジベースを用意し、難易度や所要時間、想定リスクを明記したうえでリクエストフォームから改善要望を受け付けています。レビューコメントを自動集約するボットを導入した結果、改善の議論がスムーズになりました。テンプレ構成の詳細はCursorテンプレート活用ガイドで確認いただけます。

現場で起こりやすいトラブルと対処フロー

レスポンス低下と品質劣化を見極める

現場で多いトラブルはレスポンス低下、品質劣化、設定ミスの三つです。レスポンス低下はGPUメモリ不足や同時実行数の増加が原因のことが多く、モデルの量子化やバッチサイズ調整、不要プロセスの停止で改善できます。私たちは関数型ドメインモデリングを読み込みドメイン境界を可視化してレビュー観点を標準化したところ品質が安定しました。具体例として、ローカルLLMが生成した設定ファイルをそのまま適用し本番サーバーが停止したケースがあります。この反省から設定ファイル系の出力は二人以上でレビューし、ステージングで再現テストを行うフローを義務化しました。トラブル対応手順はバグとエラーの違い記事に整理されているため、作業前に必ず確認するようにしています。

フェイルセーフを事前に設計する

フェイルセーフとしては、プロンプトで実行できるコマンドを制約するサンドボックス環境を用意し、ロールアウト前にデータハンドリングルールを読み合わせることを徹底しました。さらにAI出力を監査ログに保存し品質評価と改善に活かす仕組みも整え、復旧時間が平均45分から20分へ短縮されています。この体制により障害対応の心理的負担が軽減され、安心してハイブリッド運用を継続できるようになりました。

まとめ

クラウドAIとローカルLLMの得意領域をチームで共有し、指標に基づいた改善サイクルを回し続けることがハイブリッド運用成功の本道です。設計・実装・テストの各工程で役割を再定義し、定期的な振り返りを仕組みに組み込めば属人化を解消できます。さらにハイブリッドAI運用の記事で紹介したスプリントレビューのフォーマットを取り入れると効果測定が加速し、取り組みの成果を定量的に示せるようになります。ローカルLLMの出力に耐える堅牢なコードアーキテクチャを採用し、変更に強いシステムを維持することが未来の開発リズムを確実に支えます。

最後に、ハイブリッド運用を定着させるヒントとして「ナレッジを溜め続ける文化」を育てましょう。Slackの#ai-handoffチャンネルに毎日気づきを投稿し、週次レポートへ自動転記する仕組みを実装した結果、改善アイデアが平均で週5件から13件に増えました。学習体制が整えばAIは頼もしい仲間になります。社内ルールやテンプレート整備には時間がかかりますが、一度仕組みに乗せてしまえば自走し始めます。小さな改善を積み重ね、チーム全体で継続的に学習し、ハイブリッドAI時代の開発リズムを整えていきましょう。今日紹介した取り組みから取り入れやすいものを選び、次のスプリントで試してみてください。気づきの共有が増えるほど、AIとの協働はより楽しく、より生産的になります。チーム全員で挑戦を積み重ね、次のプロジェクトをもっと楽しく、もっと生産的に進めていきましょう。