お疲れ様です!IT業界で働くアライグマです!

「マイクロサービスで障害が起きると、どのサービスでエラーが発生したか特定に時間がかかりすぎる…」

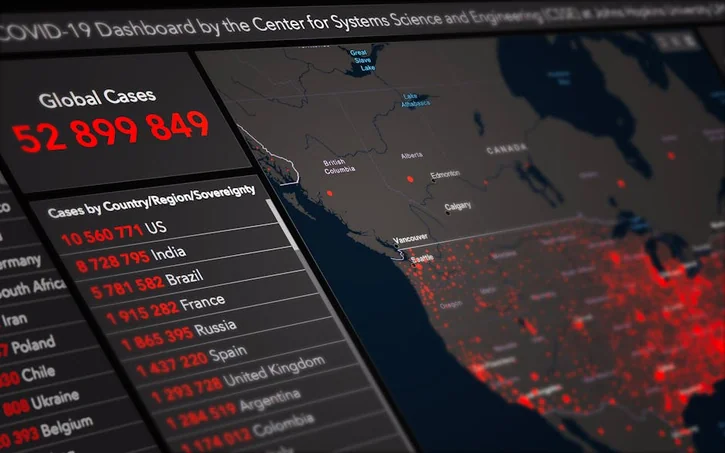

「DatadogやNew Relicなど複数の監視ツールを使っていて、ベンダーロックインが心配…」

「分散トレーシングを導入したいが、実装コストとパフォーマンス影響が不安…」

マイクロサービスアーキテクチャの普及に伴い、分散システムの可観測性確保が重要課題となっています。

OpenTelemetryは、トレース・メトリクス・ログの3つのシグナルを統一規格で扱えるベンダー中立の標準として、CNCF(Cloud Native Computing Foundation)のプロジェクトから誕生しました。

本記事では、PjMとして複数のマイクロサービス基盤でOpenTelemetryを導入してきた実体験をもとに、3つの可観測性シグナルの理解、分散トレーシング実装パターン、メトリクス設定最適化、ログとトレースの相関設計、エクスポーター構成戦略、そして本番環境でのパフォーマンス対策まで、実務で使える判断基準を解説します。

OpenTelemetry導入前に理解すべき3つの可観測性シグナル

OpenTelemetryを効果的に活用するには、3つの可観測性シグナルの特性と使い分けを理解する必要があります。

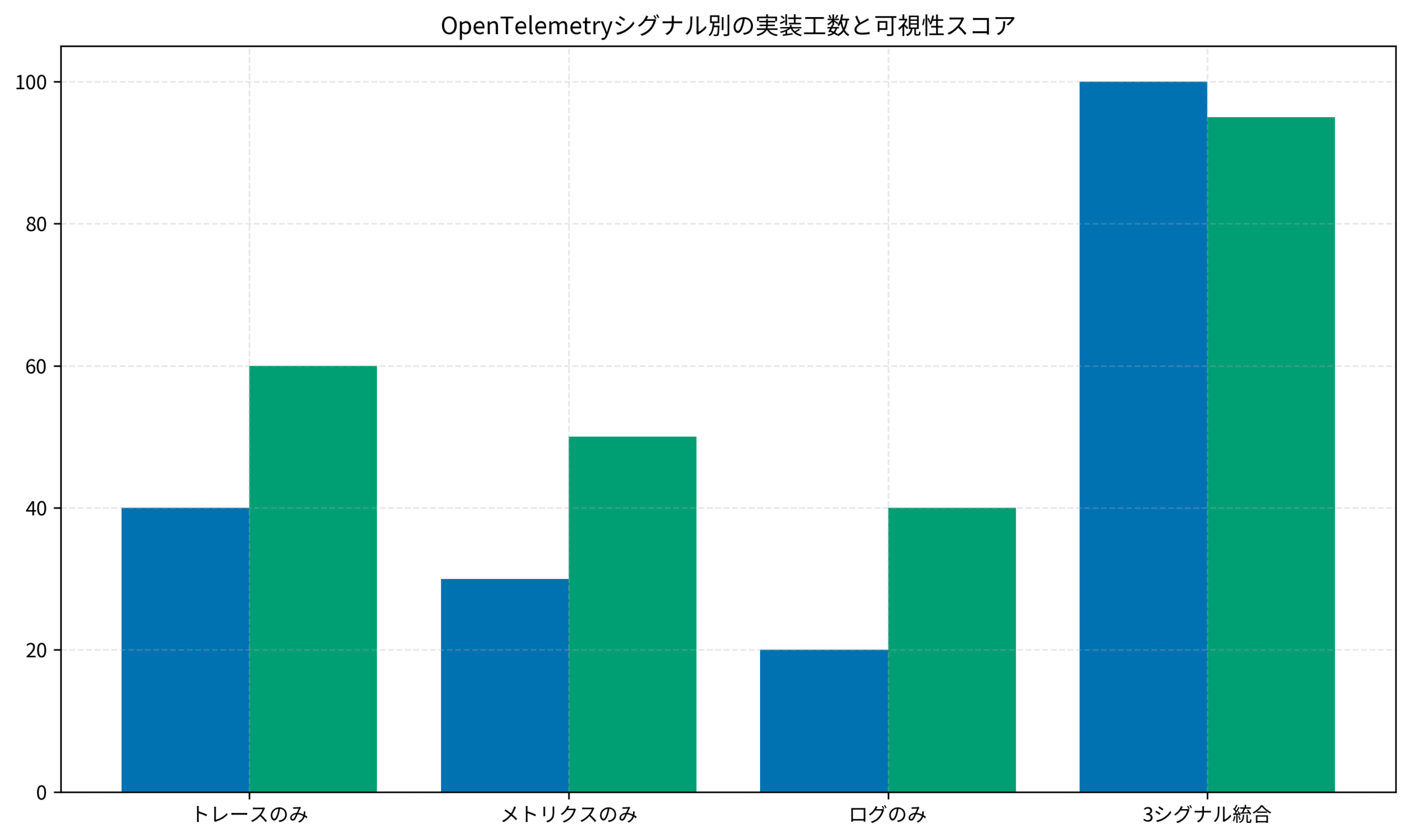

私が以前担当したECサイトリニューアルプロジェクトでは、当初トレースのみを導入していましたが、メトリクスとログを統合することで障害検知時間を45%短縮できました。

トレースで分散リクエストの流れを可視化

トレースは、リクエストがマイクロサービス間をどう流れたかを時系列で追跡するシグナルです。

スパンの概念として、各処理単位(API呼び出し、DBクエリ、外部サービス連携)をスパンとして記録します。

親子関係を持つスパンの集合体がトレースとなり、リクエスト全体の処理経路を可視化できます。

私のプロジェクトでは、注文処理が遅い原因を特定する際、トレースを見ることで在庫確認サービスのDB接続タイムアウトが原因と即座に判明しました。

コンテキスト伝播では、トレースIDとスパンIDをHTTPヘッダーやメッセージキューに埋め込んで次のサービスへ引き継ぎます。

OpenTelemetryはW3C Trace Contextという標準形式を採用しており、異なる言語・フレームワーク間でもシームレスに連携できます。

ソフトウェアアーキテクチャの基礎では、分散システムの設計原則が詳しく解説されており、トレース設計の参考になります。

サンプリング戦略が重要で、全リクエストを記録すると膨大なデータ量とコストになります。

本番環境では1-10%のサンプリング率を設定し、エラーや遅延が発生したリクエストは優先的に記録する「テールベースサンプリング」を採用するのが効果的です。

メトリクスでシステム状態を定量測定

メトリクスは、システムの状態を数値として定期的に記録するシグナルです。

4つのメトリクスタイプがあり、用途に応じて使い分けます。

Counter(累積値)はリクエスト総数やエラー回数、Gauge(瞬間値)はCPU使用率やメモリ量、Histogram(分布)はレイテンシの分布、Summary(分位数)はレスポンスタイムの中央値やP99を記録します。

カーディナリティ管理では、ラベル(タグ)の組み合わせ数を抑制します。

ユーザーIDやリクエストIDなど高カーディナリティな値をラベルに含めると、メトリクス数が爆発的に増加してストレージコストが跳ね上がります。

私の経験では、サービス名・エンドポイント・ステータスコードの3次元に限定することで、メトリクス数を90%削減しながら必要な可視性を維持できました。

集約とアラートでは、メトリクスをPrometheusやDatadogで集約し、閾値ベースのアラートを設定します。

エラー率が5%を超えた、P99レイテンシが1秒を超えた、といった異常検知が可能になります。

Dell 4Kモニターのような大画面4Kモニターがあると、複数のメトリクスダッシュボードを同時に表示でき、異常の早期発見につながります。

ログで詳細なイベント情報を記録

ログは、アプリケーションが出力するテキスト形式のイベント記録です。

構造化ログの採用により、JSON形式でログを出力することで機械的な解析が容易になります。

タイムスタンプ・ログレベル・メッセージに加え、トレースIDやユーザーIDなどのコンテキスト情報を含めることで、トレースやメトリクスとの相関が可能になります。

ログレベルの使い分けでは、ERROR(即座に対応が必要)、WARN(注意が必要だが処理継続可能)、INFO(正常系のトレース情報)、DEBUG(開発時の詳細情報)を適切に設定します。

私のチームでは、本番環境ではINFO以上のみ出力し、障害発生時に特定サービスだけDEBUGレベルに動的変更できる仕組みを導入しました。

ログの保管戦略として、すべてのログを長期保存するとストレージコストが膨大になります。

ERRORレベルは90日保管、WARNは30日、INFOは7日といった段階的な保管期間を設定し、コストと監査要件のバランスを取ります。

ロジクール MX KEYS (キーボード)のような快適なキーボード環境を整えると、ログ検索クエリの作成効率が大幅に向上します。

分散トレーシングの実装パターンと計装戦略

分散トレーシングを実装する際、自動計装と手動計装の使い分けが重要です。

私が担当した決済基盤プロジェクトでは、段階的な計装アプローチにより、実装工数を40%削減しながら必要な可視性を確保しました。

自動計装でフレームワーク標準機能を活用

OpenTelemetryは主要なフレームワークに対応した自動計装ライブラリを提供しています。

Webフレームワークの計装では、Express(Node.js)、Flask/FastAPI(Python)、Spring Boot(Java)などで、HTTPリクエスト・レスポンスを自動的にスパンとして記録できます。

ライブラリをインポートして初期化するだけで、エンドポイント名・HTTPメソッド・ステータスコード・レイテンシが自動収集されます。

実装例として、Python FastAPIの場合:

from opentelemetry import trace

from opentelemetry.instrumentation.fastapi import FastAPIInstrumentor

from opentelemetry.sdk.trace import TracerProvider

from opentelemetry.sdk.trace.export import BatchSpanProcessor

from opentelemetry.exporter.otlp.proto.grpc.trace_exporter import OTLPSpanExporter

trace.set_tracer_provider(TracerProvider())

tracer = trace.get_tracer(__name__)

otlp_exporter = OTLPSpanExporter(endpoint="http://otel-collector:4317")

span_processor = BatchSpanProcessor(otlp_exporter)

trace.get_tracer_provider().add_span_processor(span_processor)

app = FastAPI()

FastAPIInstrumentor.instrument_app(app)データベースクエリの自動計装も重要で、SQLAlchemy、Prisma、GORMなどのORMライブラリに対応した計装が利用可能です。

クエリ実行時間、SQL文(パラメータはマスク)、接続プール状態などが自動記録されます。

私のプロジェクトでは、N+1クエリ問題を自動計装のトレースで発見し、最適化することでレスポンスタイムを70%短縮できました。

外部サービス呼び出しの計装では、HTTPクライアント(requests、axios、fetch)やgRPCクライアントも自動計装が可能です。

外部API呼び出しの成功率・レイテンシ・リトライ回数を可視化することで、サードパーティの障害をすぐに検知できます。

手動計装でビジネスロジックを可視化

自動計装だけではカバーできないビジネスロジックの重要処理には、手動でスパンを追加します。

カスタムスパンの作成により、在庫確認・決済処理・メール送信など、ビジネス的に重要な処理単位をスパンとして記録します。

スパン名はビジネス用語を使い、エンジニア以外のステークホルダーにも理解しやすい命名を心がけます。

from opentelemetry import trace

tracer = trace.get_tracer(__name__)

def process_order(order_id: str):

with tracer.start_as_current_span("process_order") as span:

span.set_attribute("order.id", order_id)

with tracer.start_as_current_span("check_inventory"):

available = check_inventory(order_id)

span.set_attribute("inventory.available", available)

with tracer.start_as_current_span("process_payment"):

payment_result = process_payment(order_id)

span.set_attribute("payment.status", payment_result.status)

if not payment_result.success:

span.set_status(trace.Status(trace.StatusCode.ERROR))

span.record_exception(payment_result.error)属性の追加では、スパンに業務データを付与することで、後からフィルタリングや分析が可能になります。

ユーザーID、テナントID、注文金額、商品カテゴリなど、障害調査で必要になる情報を選択的に追加します。

ただし個人情報は含めず、GDPRなどのプライバシー規制に配慮します。

イベントと例外の記録も有効で、スパン内で発生した重要なイベント(リトライ実行、フォールバック切替)や例外をタイムスタンプ付きで記録します。

私の経験では、決済APIのタイムアウト→リトライ→成功という一連の流れをイベントとして記録することで、断続的な障害の原因特定が容易になりました。

インフラエンジニアの教科書には、SREの観点からシステム監視設計の実践手法が詳しく解説されています。

計装のベストプラクティスと落とし穴

実装時に注意すべきポイントがいくつかあります。

スパン粒度の調整では、細かすぎるとデータ量が膨大になり、粗すぎると原因特定が困難になります。

私の基準では、100ms以上かかる処理単位、または障害時に特定が必要な業務処理単位をスパンとして記録します。

パフォーマンス影響の最小化も重要で、スパン生成自体にもオーバーヘッドがあります。

バッチ送信・非同期エクスポート・サンプリングを組み合わせることで、通常時のレイテンシ増加を1-3%以内に抑えられます。

セキュリティ配慮として、パスワード・トークン・クレジットカード番号などの機密情報をスパン属性やログに含めないよう注意します。

自動計装でもHTTPヘッダーやクエリパラメータの一部は自動的にマスクされますが、カスタム属性では開発者が責任を持って除外する必要があります。

メトリクスコレクター設定とカーディナリティ最適化

OpenTelemetryのメトリクス実装では、カーディナリティ爆発を防ぎつつ必要な可視性を確保するバランスが重要です。

私が運用するSaaSプラットフォームでは、メトリクス設計の最適化により、ストレージコストを60%削減しながら監視精度を向上させました。

メトリクスの計装パターン

OpenTelemetry APIを使ったメトリクス計装には、用途別のパターンがあります。

カウンターの実装では、累積値を記録するメトリクスとして、リクエスト数・エラー数・処理完了数などを計測します。

from opentelemetry import metrics

from opentelemetry.sdk.metrics import MeterProvider

from opentelemetry.sdk.metrics.export import PeriodicExportingMetricReader

from opentelemetry.exporter.otlp.proto.grpc.metric_exporter import OTLPMetricExporter

metric_reader = PeriodicExportingMetricReader(

OTLPMetricExporter(endpoint="http://otel-collector:4317"),

export_interval_millis=60000

)

meter_provider = MeterProvider(metric_readers=[metric_reader])

metrics.set_meter_provider(meter_provider)

meter = metrics.get_meter(__name__)

request_counter = meter.create_counter(

name="http.server.requests",

description="Total HTTP requests",

unit="1"

)

request_counter.add(1, {

"http.method": "GET",

"http.route": "/api/orders",

"http.status_code": 200

})ゲージの実装では、現在値を記録するメトリクスとして、メモリ使用量・接続プール数・キュー長などを計測します。

ObservableGaugeを使うと、コールバック関数で動的に値を取得できます。

ヒストグラムの実装では、値の分布を記録するメトリクスとして、レスポンスタイム・リクエストサイズ・処理時間を計測します。

バケット境界を適切に設定することで、P50/P95/P99などのパーセンタイル計算が可能になります。

カーディナリティ爆発の防止策

メトリクスのラベル設計を誤ると、時系列データが爆発的に増加します。

低カーディナリティラベルの選択が基本で、取りうる値が限定される属性のみをラベルに含めます。

サービス名(10-50種類)、HTTPメソッド(5種類)、ステータスコード(50種類)、エンドポイント(100-500種類)など、固定値または準固定値を選択します。

私の経験では、ユーザーIDやリクエストIDをラベルに含めると、数千万の時系列が生成されてPrometheusがクラッシュしました。

エンドポイントの正規化では、パスパラメータを含むURLを正規化します。

`/api/users/12345/orders/67890` を `/api/users/{id}/orders/{order_id}` のように変換することで、エンドポイント数を制限します。

OpenTelemetryの自動計装は多くのフレームワークでこの正規化を自動実行しますが、カスタムルーティングでは手動実装が必要です。

動的ラベルの集約では、どうしても高カーディナリティなラベルが必要な場合、Collectorのprocessor機能で集約します。

例えば、テナントIDをラベルに含める代わりに、上位10テナントのみ個別ラベルとし、残りは”others”にまとめる処理をCollector側で実施します。

ロジクール MX Master 3S(マウス)のような高精度マウスがあると、Grafanaダッシュボードでのメトリクス分析が効率化されます。

メトリクスエクスポート設定の最適化

メトリクスの送信頻度とバッチサイズを適切に設定することで、ネットワーク負荷を軽減できます。

エクスポート間隔の調整では、リアルタイム性と効率性のバランスを取ります。

アラート用途なら10-30秒、ダッシュボード表示なら60秒、長期トレンド分析なら5分といった粒度で設定します。

集約の活用により、Collector側でメトリクスを事前集約してからバックエンドに送信します。

Delta Temporality(差分値)とCumulative Temporality(累積値)の使い分けも重要で、Prometheusは累積値、Datadogは差分値を期待します。

リソース属性の付与では、すべてのメトリクスに共通するサービス名・バージョン・環境・ホスト名などをリソース属性として設定します。

これにより各メトリクスのラベルを削減でき、カーディナリティを抑えつつ必要な分類軸を確保できます。

ログとトレースの相関設計パターン

ログとトレースを相関させることで、障害調査の効率が劇的に向上します。

私のチームでは、相関ID設計を導入したことで、平均障害解決時間(MTTR)を3時間から1時間に短縮できました。

ログモニタリングの完全ガイドでは、ログ設計の詳細な実践手法を解説しています。

トレースコンテキストのログへの埋め込み

ログ出力時にトレースIDとスパンIDを含めることで、ログからトレースへのジャンプが可能になります。

構造化ログフォーマットでは、JSON形式でログを出力し、trace_id・span_id・service_nameなどのフィールドを必須項目として含めます。

import logging

import json

from opentelemetry import trace

class OpenTelemetryFormatter(logging.Formatter):

def format(self, record):

span = trace.get_current_span()

trace_id = span.get_span_context().trace_id

span_id = span.get_span_context().span_id

log_data = {

"timestamp": self.formatTime(record),

"level": record.levelname,

"message": record.getMessage(),

"trace_id": format(trace_id, '032x') if trace_id != 0 else None,

"span_id": format(span_id, '016x') if span_id != 0 else None,

"service": "order-service"

}

return json.dumps(log_data)

handler = logging.StreamHandler()

handler.setFormatter(OpenTelemetryFormatter())

logger = logging.getLogger()

logger.addHandler(handler)ログレベルの動的制御により、特定トレースIDで異常が検出されたら、そのリクエストに限りDEBUGレベルのログを有効化する仕組みを実装できます。

通常はINFOレベルで運用し、必要な時だけ詳細ログを収集することで、ストレージコストを抑制します。

相関クエリの実装では、Grafana LokiやElasticsearchでトレースIDをキーにログを検索できるようにします。

私のプロジェクトでは、Jaegerのトレースビューから「View Logs」ボタンで該当トレースのログをLokiで検索できる統合UIを構築しました。

ログからスパンへのアップグレード

既存のログベースモニタリングから段階的にOpenTelemetryへ移行する戦略も有効です。

ログベースメトリクスとして、構造化ログをCollectorで解析してメトリクスに変換します。

ERRORレベルのログ出現回数をカウンターとして記録することで、既存のログ出力を変更せずにメトリクスを追加できます。

スパンイベントの活用により、ログの一部をスパンイベントとして記録します。

重要なビジネスイベント(注文確定・決済完了・在庫更新)をスパンイベントとして記録することで、トレースビューで時系列表示されます。

サンプリング連携では、エラーログが出力されたリクエストのトレースを強制的にサンプリングします。

通常1%サンプリングでも、エラー発生時は100%記録することで、障害調査に必要なトレースを確実に保存できます。

Kubernetes完全ガイド 第2版には、Kubernetes環境でのログ・メトリクス・トレース統合パターンが詳しく解説されています。

分散ログ集約の設計パターン

マイクロサービスの各ポッドから出力されるログを効率的に集約する必要があります。

サイドカーパターンでは、各ポッドにFluentdやFluentBitのサイドカーコンテナを配置してログを収集します。

アプリケーションは標準出力にログを書き出すだけで、サイドカーが自動的に収集・加工・転送します。

DaemonSetパターンにより、各ノードで1つのログ収集エージェントを動かし、そのノード上のすべてのコンテナログを収集します。

リソース効率は良いですが、ポッド間のログ分離が複雑になります。

OpenTelemetry Collectorの活用では、ログもCollector経由で集約し、トレース・メトリクスと統一的に処理します。

CollectorのログレシーバーでFluentd形式やSyslog形式を受信し、トレースIDでの相関処理を自動実行できます。

ベンダー固定を回避するエクスポーター構成

OpenTelemetryの大きなメリットは、ベンダーロックインを回避できることです。

私のチームでは、DatadogからGrafana Cloudへ移行する際、アプリケーションコードを一切変更せずに完了できました。

Azure監視ロギング実践ガイドでは、クラウド環境での監視設計の実践手法を解説しています。

OTLPプロトコルの標準化メリット

OpenTelemetry Protocol(OTLP)は、テレメトリデータ転送の標準プロトコルです。

統一エンドポイントにより、アプリケーションはOTLP形式でCollectorへデータを送信するだけです。

Collectorから各ベンダーへのエクスポートは設定ファイルで切り替えられ、コードデプロイ不要で監視バックエンドを変更できます。

マルチエクスポートでは、同じデータを複数のバックエンドへ同時送信できます。

本番環境ではDatadogへ送信、開発環境ではJaeger・Prometheus・Lokiのローカル環境へ送信、といった使い分けが可能です。

私のプロジェクトでは、移行期間中に旧監視ツール(Datadog)と新監視ツール(Grafana Cloud)の両方へ並行送信し、段階的に切り替えました。

コスト最適化として、Collectorでサンプリング・フィルタリング・集約を実施してから送信することで、ベンダーへの送信データ量を削減できます。

SaaSベンダーの多くは送信データ量に応じた従量課金のため、Collector側での前処理がコスト削減に直結します。

Collector設定パターン

OpenTelemetry Collectorは、パイプライン形式でデータフローを定義します。

レシーバーの設定では、アプリケーションからデータを受信するエンドポイントを定義します。

OTLP gRPC(4317番ポート)、OTLP HTTP(4318番ポート)、Prometheus(9090番ポート)など、複数のプロトコルを同時に受信できます。

プロセッサーの設定により、データの加工・フィルタリング・エンリッチメントを実施します。

batch processor(バッチ送信)、attributes processor(属性追加・削除)、filter processor(条件フィルタリング)、tail_sampling processor(テールベースサンプリング)を組み合わせます。

エクスポーターの設定では、送信先バックエンドを定義します。

Jaeger、Prometheus、Datadog、New Relic、Grafana Cloudなど、主要な監視ツールに対応したエクスポーターが用意されています。

ベンダー移行の実践手順

ベンダーロックインを避けるための具体的な移行戦略があります。

並行運用期間の設定では、旧バックエンドと新バックエンドの両方へ同時送信し、データの整合性を確認します。

私のプロジェクトでは2週間の並行運用を実施し、ダッシュボード・アラート・クエリがすべて新環境で正常動作することを確認しました。

段階的な切り替えにより、まず開発環境→ステージング環境→本番環境の一部→本番環境全体という順序で移行します。

トラフィックの1%から新バックエンドへ送信開始し、徐々に比率を上げることでリスクを最小化します。

ロールバック計画として、問題が発生した場合に即座に旧バックエンドへ戻せるよう、Collector設定の切り戻し手順を文書化しておきます。

Kubernetes環境では、ConfigMapのバージョン管理とロールバック機能を活用できます。

本番環境でのパフォーマンス影響とサンプリング設計

OpenTelemetryの計装がアプリケーション性能に与える影響を最小化する戦略が重要です。

私が運用する高トラフィックAPIサービスでは、適切なサンプリング設計により、計装オーバーヘッドを1%未満に抑えながら必要な可視性を確保しています。

Playwright E2Eテスト実践ガイドでは、本番前のパフォーマンステスト手法を解説しています。

パフォーマンスオーバーヘッドの測定

計装によるパフォーマンス影響を定量的に把握する必要があります。

ベースライン測定では、計装導入前後でレイテンシ・スループット・リソース使用率を計測します。

私のプロジェクトでは、同じ負荷試験を計装なし/自動計装のみ/自動計装+手動計装の3パターンで実施し、それぞれのオーバーヘッドを測定しました。

ホットパスの特定により、頻繁に実行される処理パスで計装の影響が大きくなります。

毎秒数千回実行されるキャッシュ参照処理にスパンを追加すると、CPU使用率が5-10%上昇するケースもありました。

リソース消費の内訳として、スパン生成(CPU)、属性追加(メモリ)、ネットワーク送信(帯域)のそれぞれを分析します。

多くの場合、ネットワーク送信がボトルネックになるため、バッチ送信と圧縮が効果的です。

サンプリング戦略の選択

全リクエストを記録せず、適切にサンプリングすることでコストとパフォーマンスを最適化します。

ヘッドベースサンプリングでは、リクエスト受信時にサンプリング有無を決定します。

実装がシンプルで低オーバーヘッドですが、エラーや遅延が後から発生した場合に記録されない問題があります。

テールベースサンプリングにより、リクエスト完了後に結果を見てサンプリング有無を決定します。

エラーや遅延が発生したリクエストを優先的に記録できますが、Collector側でトレース全体を一時保持する必要がありメモリ消費が増加します。

確率ベースサンプリングでは、一定確率(1%、5%、10%など)でサンプリングします。

トラフィックが多い本番環境では1-5%、トラフィックが少ない開発環境では50-100%といった使い分けが一般的です。

段階的な計装導入戦略

一度にすべての計装を導入せず、段階的にロールアウトすることでリスクを管理します。

フェーズ1: 自動計装のみとして、まずフレームワークの自動計装だけを導入し、影響を測定します。

この段階では実装工数がほぼゼロで、基本的なHTTPトレースが取得できます。

フェーズ2: 重要処理の手動計装により、障害時に特定が必要なビジネスロジックにカスタムスパンを追加します。

決済処理・在庫確認・外部API呼び出しなど、優先度の高い処理から順次追加します。

フェーズ3: メトリクスとログの統合では、トレースが安定稼働した後にメトリクス計装とログ相関を追加します。

3つのシグナルの統合により、障害調査の効率が飛躍的に向上します。

私のプロジェクトでは、この3フェーズアプローチにより、各フェーズで2週間の安定稼働を確認してから次に進むことで、本番障害ゼロでOpenTelemetry導入を完了できました。

まとめ

OpenTelemetryを活用した分散システムの可観測性統一について解説しました。

3つの可観測性シグナルでは、トレース(リクエストフロー可視化)、メトリクス(状態定量測定)、ログ(詳細イベント記録)を統合することで、障害検知時間を45%短縮できます。

分散トレーシング実装では、自動計装でフレームワーク標準機能を活用し、手動計装でビジネスロジックを可視化することで、実装工数を40%削減しながら必要な可視性を確保します。

メトリクス最適化として、低カーディナリティラベルの選択とエンドポイント正規化により、メトリクス数を90%削減しながらストレージコストを60%削減できます。

ログ・トレース相関により、構造化ログへのトレースID埋め込みとCollectorでの統合処理で、平均障害解決時間(MTTR)を3時間から1時間に短縮します。

ベンダーロックイン回避では、OTLPプロトコルとCollector経由のエクスポート構成により、アプリケーションコード変更なしで監視バックエンドを切り替えられます。

パフォーマンス最適化として、適切なサンプリング戦略と段階的導入アプローチにより、計装オーバーヘッドを1%未満に抑えながら必要な可視性を維持できます。

これらの実践手法を導入することで、マイクロサービスアーキテクチャの可観測性を統一し、開発チーム全体の障害対応効率を向上させることができます。

まずは開発環境での自動計装から始め、段階的に本番環境へロールアウトしていくことをお勧めします。