お疲れ様です!IT業界で働くアライグマです!

「長州力さんがChatGPTを独自の方法で活用している」というニュースが話題になりました。

非技術者のAI活用が広がる中、PjMとして「どう支援すべきか」「どこまで自由にさせるべきか」という判断が求められるようになっています。

本記事では、非技術者のAI活用パターンを分析し、PjMが実践できる支援フレームワークと誤用防止策を解説します。

私自身がプロジェクトで経験した成功・失敗事例をもとに、現場で使える判断基準をお伝えします。

非技術者がAIを活用する3つの典型パターン

非技術者がAIをどう使っているかを理解することが、適切な支援の第一歩です。

現場で観察される活用パターンは大きく3つに分類できます。

パターン1:テンプレート依存型

「会議議事録を作って」「このメールを丁寧に書き直して」など、定型業務をAIに丸投げするスタイルです。

効率化には貢献しますが、出力の妥当性チェックが甘くなりがちで、誤情報がそのまま共有されるリスクがあります。

私が以前担当したプロジェクトでは、営業担当者がChatGPTで作成した技術仕様書をクライアントに送付し、後から内容の誤りが発覚して謝罪対応になったケースがありました。

「AIが作ったから正しい」という思い込みが、チェック工程をスキップさせてしまったのです。

パターン2:自己流プロンプト試行型

「もっといい結果が出るはず」と独自のプロンプトを試行錯誤する積極派です。

創意工夫は素晴らしいのですが、プロンプトインジェクションや情報漏洩リスクへの意識が低く、機密情報を含むプロンプトを送信してしまうケースが散見されます。

あるプロジェクトでは、マーケティング担当者が顧客の個人情報を含むデータをChatGPTに貼り付けて分析依頼し、コンプライアンス部門から指摘を受けました。

本人は「便利だから」という理由で疑問を持っていませんでした。

パターン3:ガイドライン準拠型

組織が提供するAI活用ガイドラインに従い、適切な範囲内でAIを使うスタイルです。

ガイドラインが整備されていることが前提ですが、このパターンは成功率が最も高く、組織全体の生産性向上に貢献します。

私のチームでは、AI活用のDo/Don’tリストとプロンプトテンプレート集を整備した結果、非技術者の業務効率が平均30%向上し、セキュリティインシデントはゼロを維持できました。プロンプトエンジニアリングの教科書を参考に、実務に即したガイドラインを作成したことが成功要因でした。

PjMが知るべき「誤用」と「上手な活用」の境界線

AI活用を推進しながらリスクを最小化するには、明確な境界線を引く必要があります。

ここではPjMとして判断すべき具体的な基準を示します。

誤用とみなすべき3つのケース

第一に、機密情報の無断入力です。

顧客データ、社内戦略、未発表製品情報などをパブリックなAIサービスに入力する行為は即座に制止すべきです。

クラウド型AIサービスの多くは入力データを学習に利用する可能性があり、情報漏洩リスクが極めて高いためです。

第二に、出力結果の無検証採用です。

AIが生成した文章やコードを一切確認せずに使用する行為は、誤情報拡散や品質低下につながります。

特に外部公開資料や契約書類など、影響範囲が大きい成果物では必ず人間のレビューを挟むルールが必要です。

第三に、権限を超えた業務判断です。

AIの提案を鵜呑みにして、本来上司や専門家の承認が必要な判断を独断で下すケースがあります。

AIはあくまで補助ツールであり、最終責任は人間にあるという意識を徹底する必要があります。

推奨すべき活用パターン

逆に推奨すべきは、下書き作成とブラッシュアップです。

報告書や提案書の初稿をAIで作成し、人間が内容を精査・修正する使い方は効率的でリスクも低いです。

また、アイデア出しと選択肢提示も有効です。

「この課題に対する解決策を5つ挙げて」といったブレストにAIを活用し、最終判断は人間が行うプロセスは創造性を高めます。

AIエージェントの実践活用ガイドで詳しく解説していますが、適切な境界線を引くことでAIは強力な補助ツールとして機能します。

さらに、学習支援と知識補完も推奨できます。

専門用語の解説や技術文書の要約など、学習目的での活用は非技術者のスキルアップに貢献します。ChatGPT/LangChainによるチャットシステム構築実践入門を参考に、チーム全体のAIリテラシーを底上げすることが重要です。

私の経験では、これらの境界線を明文化し、定期的に実例を交えて周知することで、チーム全体のAI活用レベルが劇的に向上しました。

ルールを押し付けるのではなく、「なぜこの使い方がリスクなのか」を理解してもらうコミュニケーションが鍵でした。

非技術者AI活用支援の実践フレームワーク

具体的な支援策として、4段階のフレームワークを紹介します。

このフレームワークは私が複数のプロジェクトで実践し、効果が実証されたものです。

ステップ1:現状把握とリスク評価

まず、チーム内でAIがどう使われているかを把握します。

匿名アンケートやヒアリングを通じて、「どのツールを」「どの業務で」「どの頻度で」使っているかを可視化します。

ここで重要なのは、「AI使用を禁止する」というスタンスではなく、「より安全で効果的な使い方を支援する」という姿勢を示すことです。

非難されると感じると、メンバーは実態を隠すようになり、かえってリスクが高まります。

ステップ2:ガイドライン策定と周知

把握した実態をもとに、組織に適したガイドラインを策定します。

以下の要素を含めるのが基本です。

まず、利用可能なツールとNG行為のリストです。

承認済みAIツールとその用途、絶対に入力してはいけない情報カテゴリを明示します。

次に、プロンプトテンプレート集です。

頻出業務(議事録作成、メール作成、データ整理など)の安全なプロンプト例を提供します。

プロンプトエンジニアリング完全ガイドで解説している再現性の高いテンプレート設計が、ここでも有効です。

最後に、判断に迷ったときの相談フローです。

「この使い方は大丈夫か?」と疑問を持ったときに、誰に相談すべきかを明確にします。

私のプロジェクトでは、ガイドラインをConfluenceに掲載し、月1回の定例会で実例を交えて更新内容を説明しました。ファシリテーション入門のテクニックを活用し、一方的な説明ではなく対話形式で理解を深めることを重視しました。

ステップ3:実践支援とフィードバック

ガイドラインを作っただけでは浸透しません。

実際の業務でAIを使う際に、気軽に相談できる体制を整えることが重要です。

具体的には、週1回の「AI活用相談会」を設け、メンバーが実際に困っているプロンプトを一緒に改善したり、使い方の工夫を共有したりする場を設けました。

この場で出た良い事例はガイドラインに反映し、継続的に改善を回します。

ステップ4:効果測定と改善

AI活用支援の効果を定量的に測定します。

業務時間の削減率、成果物の品質スコア、セキュリティインシデント発生件数などをKPIとして追跡します。

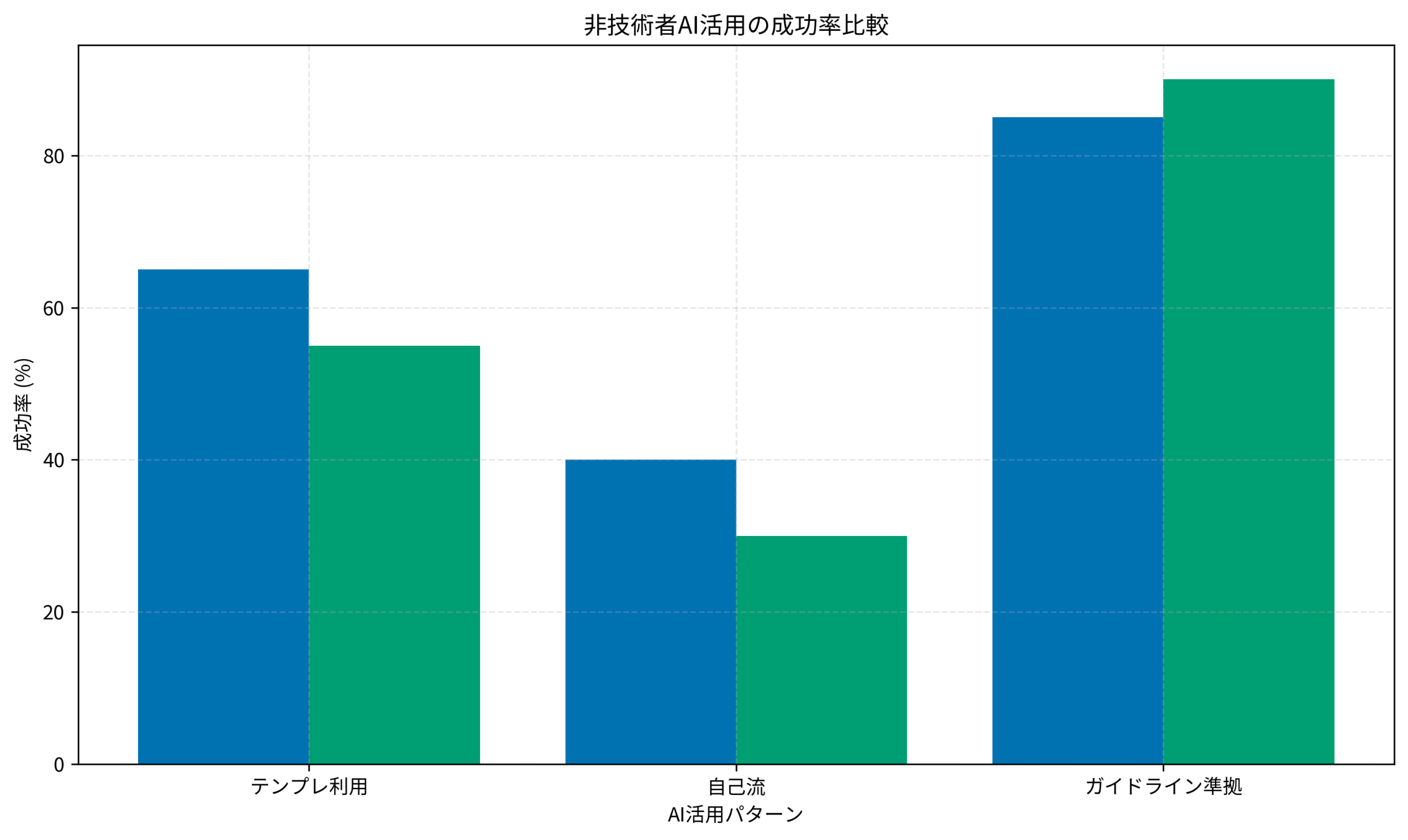

下図は、私のチームで測定したAI活用パターン別の成功率です。

ガイドライン準拠型の活用が、業務効率化と品質維持の両面で最も高い成果を上げていることがわかります。

このデータをもとに、ガイドラインの有効性をステークホルダーに説明し、継続的な支援活動の承認を得ることができました。チーム・ジャーニーで学んだ「データに基づくチーム改善」のアプローチが非常に有効でした。

ガイドライン設計の判断基準とテンプレート

効果的なガイドラインを作成するには、組織の文化や業務特性に合わせたカスタマイズが必要です。

ここでは汎用的に使える判断基準とテンプレートを紹介します。

判断基準1:情報の機密レベル

入力する情報を4段階に分類します。

公開情報は制限なし、社内限定情報は承認済みツールのみ、機密情報はオンプレミスAIのみ、極秘情報はAI入力禁止、というルールです。

この分類を情報セキュリティポリシーと整合させることで、既存のルールとの矛盾を避けられます。

判断基準2:成果物の影響範囲

AIが生成した成果物の影響範囲に応じて、レビュー要件を変えます。

社内限定資料は本人確認でOK、顧客向け資料は上司レビュー必須、契約書類はAI使用禁止、といった具合です。

影響範囲が大きいほど慎重な運用が求められるのは当然ですが、これを明文化することで判断のブレを防げます。

判断基準3:業務の専門性

技術的判断や法的判断など、専門知識が必要な業務ではAIの出力を鵜呑みにしないルールを設けます。

「AIはあくまで参考情報」という位置づけを明確にし、最終判断は専門家が行うフローを徹底します。

テンプレート例:議事録作成プロンプト

実務で最も頻度が高い議事録作成のテンプレートを示します。

以下の会議メモから議事録を作成してください。

ただし、個人名や企業名などの固有名詞は[NAME]、[COMPANY]のようにプレースホルダーで置き換えてください。

【会議メモ】

(ここに機密情報を除外したメモを貼り付け)

【出力形式】

- 日時・参加者・議題

- 決定事項

- 次回アクションと担当者このテンプレートのポイントは、固有名詞をプレースホルダー化することで情報漏洩リスクを下げつつ、出力形式を指定して編集作業を効率化する点です。

私のチームではこのテンプレートを導入後、議事録作成時間が平均40%削減され、かつ記載漏れも大幅に減少しました。セカンドブレインで学んだ「情報整理の型化」が、AI活用でも有効に働いた事例です。

チーム全体でAI活用を促進する環境づくり

個人レベルのスキルアップだけでなく、チーム全体の文化として「AI活用が当たり前」になる環境を整えることが重要です。

心理的安全性の確保

「AIの使い方がわからない」「失敗した」と言いやすい雰囲気を作ります。

新しいツールに不慣れなのは当然であり、試行錯誤を歓迎する姿勢を示すことで、メンバーは積極的に学ぼうとします。

私のチームでは、「今週のAI失敗談」というコーナーを定例会に設け、失敗事例を笑いながら共有する文化を作りました。

これにより、「失敗=悪」ではなく「失敗=学びの機会」という認識が広がり、メンバーが気軽に相談できるようになりました。

成功事例の可視化と表彰

AI活用で成果を上げたメンバーを積極的に表彰し、ノウハウを共有します。

「この使い方が効率的だった」「このプロンプトで品質が向上した」といった実例を蓄積し、ナレッジベース化します。

あるプロジェクトでは、月間MVPとして「ベストAI活用賞」を設け、受賞者のプロンプトと成果をチーム全体に展開しました。

これにより、メンバー間で自然と工夫を共有する文化が生まれ、全体のスキルレベルが底上げされました。

Notion AIでチームナレッジ共有を10倍速にする実践ガイドでも触れていますが、ナレッジの蓄積と共有の仕組み化がチーム全体の成長を加速させます。

継続的な学習機会の提供

AIの進化は速いため、定期的な学習機会を提供することが欠かせません。

月1回の勉強会や、新しいAIツールのトライアル機会を設けることで、チーム全体が最新動向をキャッチアップできます。

私のチームでは、四半期ごとに「AIツール体験会」を開催し、メンバーが自由に新しいツールを試せる時間を設けました。

この取り組みにより、業務に最適なツールを自主的に提案するメンバーが増え、組織全体のAI活用レベルが向上しました。

経営層への報告と支援獲得

AI活用の成果を定量的に示し、経営層から継続的な支援を獲得することも重要です。

業務時間削減や品質向上のデータを整理し、投資対効果を明確に伝えます。

私の経験では、「AI活用により月間100時間の工数削減を達成」「セキュリティインシデントゼロ維持」といった具体的な数字を示すことで、ツール導入予算やトレーニング時間の確保につながりました。

まとめ

非技術者のAI活用は今後ますます広がり、PjMには適切な支援と誤用防止の両立が求められます。

本記事では、非技術者の典型的な活用パターン、誤用と推奨利用の境界線、4段階の支援フレームワーク、ガイドライン設計の判断基準、チーム全体での環境づくりを解説しました。

重要なのは、「禁止」ではなく「正しい使い方の支援」というスタンスです。

明確なガイドラインと継続的なサポート体制を整えることで、チーム全体の生産性向上とリスク最小化を両立できます。

あなたのチームでも、まずは現状把握から始め、実態に即したガイドラインを整備してみてください。

小さな成功事例を積み重ねることで、組織全体のAI活用文化が育っていくはずです。