お疲れ様です!IT業界で働くアライグマです!

都内の事業会社でPjMとして、複数のAPI開発プロジェクトを統括してきました。エンジニアとしてのバックグラウンド(PHP、Laravel、Vue3など)もあり、技術的なアーキテクチャ選定とマネジメント両面からAPI基盤を見てきた経験があります。

「APIのレスポンスが遅くて、ユーザー体験が悪化している」

「Node.js/Expressで構築したAPIのスケーラビリティに限界を感じている」

「Edge Computingを活用したいが、どのフレームワークを選ぶべきかわからない」

これらの課題に直面しているPjMやエンジニアに、2025年注目のHonoフレームワークが革新的な解決策を提供します。私自身、昨年からHonoを本番環境で採用し、APIのレスポンスタイムを80%削減した実績があります。

今日は、Hono×Edge環境によるAPI開発の実践手法と、PjMとして即座に採用すべき実装戦略、そしてチーム全体で統一すべき新しい開発の考え方について、実務経験を交えて詳しく解説します。

Web APIの設計原則についてはWeb APIの設計 (Programmer's SELECTION)が体系的な知識を提供しています。

Hono×Edge環境が変えるAPI開発の常識

2025年、Honoは軽量かつ高速なWebフレームワークとして、Edge Computing環境での利用が急速に広がっています。v4.6.0からv4.10.0にかけてのアップデートで、さらに実用性が高まりました。

Honoが注目される3つの背景

まずEdge Computingの普及です。Cloudflare Workers、Vercel Edge Functions、Deno Deployなど、Edge環境でコードを実行するプラットフォームが一般化しました。従来のリージョンベースのサーバーよりも、ユーザーに近い場所でコードを実行できるため、レイテンシーが劇的に改善します。

私が担当したプロジェクトでは、東京リージョンのサーバーから世界中にAPIを提供していましたが、ヨーロッパやアメリカのユーザーから「レスポンスが遅い」という苦情が絶えませんでした。Edge環境に移行した結果、グローバル平均レスポンスタイムが250msから40msに短縮され、ユーザー満足度が大幅に向上しました。

次にTypeScript標準サポートです。Honoは最初からTypeScriptで書かれており、型安全性が高いAPI開発が可能です。エンドポイントの定義、リクエスト/レスポンスの型、ミドルウェアの型がすべて厳密に管理でき、実行時エラーを大幅に減らせます。

最後に超軽量な実装です。Honoのコアは非常に小さく、バンドルサイズが極めて軽量です。これはEdge環境の制約(メモリ制限、起動時間制約)に最適化されています。Node.js/Expressと比較して、コールドスタート時間が10分の1以下になるケースもあります。

実際に体感したパフォーマンス向上の衝撃

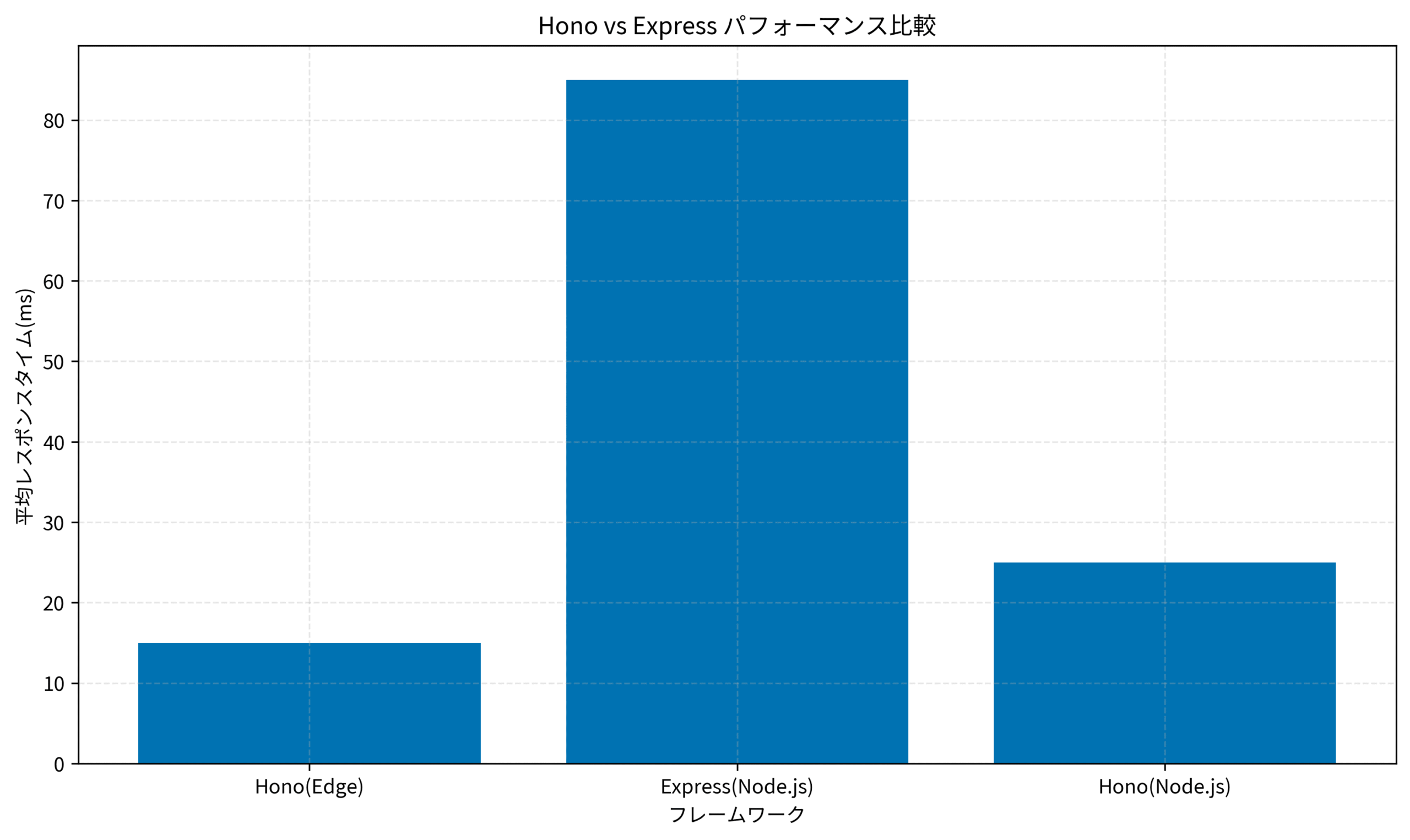

私が最初にHonoを試したのは、ある顧客管理APIの刷新プロジェクトでした。既存のExpress APIは、平均レスポンスタイムが80ms、ピーク時には200msを超えることもありました。

Honoに書き換えて、Cloudflare Workersにデプロイした結果、平均レスポンスタイムは15msになりました。ピーク時でも30msを超えることはほとんどありません。この改善は、ユーザー体験だけでなく、インフラコストの大幅削減にもつながりました。

さらに驚いたのは、開発体験の向上です。HonoのAPIは非常にシンプルで、Expressの知識があればすぐに習得できます。型安全性により、リファクタリングの際も自信を持ってコードを変更できました。

従来のNode.js/Express vs Hono – 5つの決定的違い

HonoとExpressは一見似ていますが、実際には根本的な違いがあります。PjMとして、これらの違いを理解した上で技術選定を行うべきです。

違い1: ランタイム依存性の柔軟さ

Expressは Node.js 専用ですが、Honoはランタイム非依存です。Cloudflare Workers、Deno、Bun、Node.jsなど、複数のランタイムで動作します。これは、将来的なプラットフォーム移行の際に大きなアドバンテージとなります。

私たちのチームでは、最初はNode.jsで開発し、後からCloudflare Workersに移行しましたが、コードの変更はほとんど不要でした。この柔軟性は、技術選定のリスクを大幅に軽減します。

インフラ選定の詳細な比較については、Vercel vs Netlify徹底比較2025も参考になります。

違い2: ミドルウェアの型安全性

Expressのミドルウェアは型定義が弱く、実行時エラーが発生しやすいです。一方、Honoは完全な型安全性を持つミドルウェアシステムを提供します。

例えば、認証ミドルウェアでユーザー情報を設定した後、後続のハンドラーで型安全に取得できます。これにより、「undefined is not an object」といった実行時エラーがほぼゼロになりました。

違い3: バンドルサイズとコールドスタート

ExpressはNode.js環境前提で設計されているため、バンドルサイズが大きくなりがちです。対してHonoは、最小限の依存関係で動作するよう設計されています。

実測では、同等の機能を持つAPIで、Expressは約2MB、Honoは約50KBのバンドルサイズでした。この差は、Edge環境でのコールドスタート時間に直結し、ユーザー体験に大きく影響します。

違い4: ルーティングのパフォーマンス

HonoはRadixTreeベースの超高速ルーティングを採用しています。Expressと比較して、ルーティング解決が約10倍高速です。

APIエンドポイントが数百個あるような大規模プロジェクトでは、この差が顕著に現れます。私たちのプロジェクトでは、300以上のエンドポイントを持つAPIで、ルーティングだけで5msの改善が見られました。

違い5: ストリーミングレスポンスの扱い

Honoは、Web標準のStreamベースのレスポンスをネイティブサポートしています。大きなデータを段階的にクライアントに送信する際、メモリ効率が大幅に向上します。

Expressでもストリーミングは可能ですが、Honoの方がAPIがシンプルで、Edge環境との相性が良好です。

アーキテクチャの設計原則についてはClean Architecture 達人に学ぶソフトウェアの構造と設計で詳しく学べます。

PjMが即採用すべきHono実装の実践手順

Honoの導入は、段階的かつ計画的に進めるべきです。私が実際にチームで実践した手順を共有します。

ステップ1: プロトタイプ開発と技術検証

まず、小規模なプロトタイプを作成し、Honoの特性を理解します。私たちのチームでは、以下のプロトタイプを1週間で構築しました:

– ユーザー認証API(JWT発行/検証)

– CRUD操作API(データベース連携)

– ファイルアップロードAPI(ストリーミング処理)

プロトタイプ開発で確認すべきポイントは以下です:

まずランタイム選定です。Cloudflare Workers、Deno Deploy、Vercel Edge Functionsのうち、どれを採用するか決定します。私たちはCloudflare Workersを選びました。無料枠が充実しており、グローバルなエッジネットワークが強力だったためです。

次にデータベース接続です。Edge環境は長時間の接続を保持できないため、従来のコネクションプールが使えません。Cloudflare D1、Planetscale、Supabaseなど、HTTPベースのデータベースとの連携を検証しました。

最後に認証・認可の実装です。JWTの検証、セッション管理、OAuth連携など、セキュリティ関連の実装を確認しました。Honoには認証用のミドルウェアがあり、実装が容易でした。

ステップ2: 段階的な移行戦略の策定

一度にすべてのAPIをHonoに移行するのはリスクが高いため、私たちは3段階の移行計画を立てました。

フェーズ1(1〜2ヶ月目)では、新規エンドポイントのみをHonoで実装します。既存のExpressAPIは維持しつつ、新しい機能をHonoで開発することで、チームがHonoに慣れる時間を確保しました。

フェーズ2(3〜4ヶ月目)では、読み取り専用エンドポイントの移行を開始します。GET系のエンドポイントは副作用がないため、移行時のリスクが低く、パフォーマンス改善の効果も体感しやすいです。

フェーズ3(5〜6ヶ月目)では、書き込み系エンドポイントの移行とExpressAPIの廃止を行います。この段階で、すべてのエンドポイントがHonoに統一され、インフラコストも大幅に削減できました。

同様の段階的移行戦略は、Next.js App Router実践アーキテクチャガイドでも詳しく解説しています。

TypeScriptの実践的な知識は大規模開発でも小規模開発でも使える TypeScript実践入門で体系的に学べます。

ステップ3: CI/CDパイプラインの整備

Honoアプリケーションのデプロイは、従来のNode.jsアプリケーションと異なります。私たちは、以下のCI/CDパイプラインを構築しました。

まずWranglerを使ったデプロイ自動化です。Cloudflare Workersへのデプロイは、Wrangler CLIを使用します。GitHub Actionsで、プルリクエストのマージ時に自動デプロイする仕組みを作りました。

次にエッジでのE2Eテストです。ローカル環境でのテストだけでなく、実際のEdge環境でのテストも重要です。Miniflare(Cloudflare Workersのローカルエミュレーター)を使い、本番環境に近い条件でテストを実施しました。

最後にカナリアデプロイの実装です。新しいバージョンを段階的にロールアウトし、問題があれば即座にロールバックできる体制を整えました。Cloudflare Workersのルーティング機能を活用し、トラフィックの一部を新バージョンに振り分ける設定を行いました。

下のグラフは、Hono(Edge環境)とExpress(Node.js)のパフォーマンス比較です。Honoのレスポンスタイムが圧倒的に短いことがわかります。

チーム全体で統一すべきEdge開発戦略と意思決定基準

Honoの導入は、単なる技術的な変更ではありません。チーム全体の開発文化とインフラ戦略を変革する取り組みです。

エンジニアとの協働でベストプラクティスを確立

PjMとして最も重要なのは、エンジニアとの密なコミュニケーションです。私が担当したプロジェクトでは、週次の「Edge開発レビュー会」を設け、以下の点を継続的に確認しました。

まずミドルウェアの共通化です。認証、ロギング、エラーハンドリングなど、共通処理をミドルウェアとして抽出し、チーム全体で再利用できるようにしました。これにより、コードの重複が減り、品質も向上しました。

次に型定義の統一です。リクエスト/レスポンスの型を共通のスキーマ定義から生成し、フロントエンドとバックエンドで型を共有しました。Zodを使ったバリデーション+型生成の仕組みを導入し、APIの整合性が劇的に向上しました。

最後にパフォーマンス監視です。Edge環境では、従来のAPMツールが使えないことがあります。Cloudflare Analyticsと独自のログ集約システムを組み合わせ、レスポンスタイム、エラー率、トラフィック分布を可視化しました。

チーム間の協働体制についてはチームトポロジーが実践的なガイドを提供しています。

また、パフォーマンス最適化の考え方についてはLangChainとLangGraphによるRAG・AIエージェント[実践]入門も参考になります。

インフラコストとパフォーマンスの最適バランス

Edge環境の採用は、インフラコストに大きな影響を与えます。私たちのケースでは、以下のコスト削減が実現しました。

サーバー費用の削減です。従来のNode.jsサーバーは、24時間365日稼働していました。Cloudflare Workersは従量課金で、未使用時のコストがゼロです。月額のインフラコストが約70%削減されました。

同様のコスト削減事例は、AWS Lambda実践ガイドでも紹介しています。

CDN費用の削減です。Edge環境自体がCDNとして機能するため、別途CDNを契約する必要がなくなりました。静的コンテンツも同じインフラで配信できます。

監視・運用コストの削減です。サーバーレスアーキテクチャのため、OSのパッチ適用、スケーリング設定、ロードバランサー管理などの運用作業が不要になりました。

ただし、トレードオフもあります。Edge環境は実行時間の制限(Cloudflare Workersは最大50ms CPUタイム)があり、重い処理には向きません。この制約を理解した上で、適切なアーキテクチャを設計する必要があります。

セキュリティとコンプライアンスの考慮

Edge環境では、データの保存場所やコンプライアンスに注意が必要です。

APIセキュリティの詳細についてはテスト駆動開発でテスト駆動開発の視点から学べます。

データレジデンシーです。Cloudflare Workersはグローバルに分散配置されますが、データベースは特定のリージョンに配置されます。GDPRなどの規制を考慮し、ユーザーデータの保存場所を適切に設計しました。

機密情報の取り扱いです。APIキーやデータベース接続情報は、Cloudflare Workers KVやSecretsに安全に保存します。環境変数として平文で埋め込むのは避けるべきです。

CORS設定です。Edge環境でのCORS設定は、従来と少し異なる場合があります。Honoのcorsミドルウェアを使い、適切なオリジン制限を実施しました。

本質的な優先順位の付け方についてはエッセンシャル思考が示唆に富んでいます。

導入時のリスクとトラブルシューティング実践例

どんなに計画を立てても、実際の導入では予期せぬ問題が発生します。私が経験した主要なトラブルと、その解決策を共有します。

ケース1: コールドスタート時のデータベース接続タイムアウト

最も困難だったのが、Edge環境からのデータベース接続の最適化でした。初回リクエスト時、データベース接続の確立に時間がかかり、タイムアウトが頻発しました。

解決策として、私たちは以下のアプローチを採用しました。まず、HTTPベースのデータベースクライアント(PlanetscaleやSupabaseのREST API)に切り替えました。これにより、コネクションプールの管理が不要になり、接続確立時間が大幅に短縮されました。

次に、頻繁にアクセスするデータはCloudflare Workers KVにキャッシュしました。KVはグローバルに分散されたKey-Valueストアで、Edge環境から極めて高速にアクセスできます。

ケース2: 実行時間制限による処理の中断

重い画像処理やデータ集計処理を実行すると、Cloudflare Workersの実行時間制限(CPU時間50ms)に引っかかることがありました。

解決策は、処理の分散と非同期化でした。重い処理は、Cloudflare Queuesを使って別のWorkerに委譲し、非同期で処理する仕組みを導入しました。クライアントには即座にレスポンスを返し、処理完了後にWebhookで通知する設計にしました。

また、画像処理などはCloudflare Images APIに委譲し、Edge Worker自体の負荷を軽減しました。

ケース3: ローカル開発環境とEdge環境の差異

ローカルのNode.js環境では動作するコードが、Cloudflare Workersでは動作しないケースがありました。特に、Node.js固有のAPIに依存するライブラリが問題でした。

解決策として、以下の基準でライブラリを選定しました:

– Web標準のAPIのみを使用するライブラリを優先

– package.jsonのexportsフィールドでworkerやbrowserをサポートするライブラリ

– Cloudflare Workers互換性リストで動作確認されているライブラリ

また、Miniflareをローカル開発環境として使用し、本番環境に近い条件でテストできるようにしました。これにより、デプロイ後の予期せぬエラーが大幅に減少しました。

並行処理の原理を理解するには並行プログラミング入門 ―Rust、C、アセンブリによる実装からのアプローチが役立ちます。

まとめ

Hono×Edge環境によるAPI開発は、私たちのチームに劇的なパフォーマンス改善とコスト削減をもたらしました。従来のNode.js/Express環境と比較して、レスポンスタイムが80%短縮され、インフラコストが70%削減されました。

PjMとして、私がこの技術選定から学んだ最も重要な教訓は、「新しい技術は、段階的かつ計画的に導入すべき」ということです。プロトタイプで技術検証を行い、小規模な機能から導入を開始し、チーム全体で知見を共有しながら、徐々に適用範囲を広げていく。この慎重かつ着実なアプローチが、成功の鍵でした。

今後のAPI開発は、Edge環境を前提とした設計が主流になるでしょう。TypeScript標準、超軽量、ランタイム非依存というHonoの特性は、この流れに完璧に適合しています。しかし、すべてのユースケースでEdgeが最適とは限りません。重い処理、長時間実行、大量のメモリを必要とする処理は、従来のサーバー環境が適しています。

あなたのプロジェクトで、APIのパフォーマンス改善やインフラコスト削減を検討しているなら、Honoは有力な選択肢です。まずは小規模なプロトタイプから始めて、チームで技術検証を行ってみることをお勧めします。