お疲れ様です!IT業界で働くアライグマです!

「うちのプロジェクト、AIに任せれば全部うまくいくでしょ?」

最近、企画部門のマネージャーからこう言われ、頭を抱えたばかりです。AIへの期待が最高潮に達する一方で、その「限界」については、驚くほど語られていません。この認識のズレこそが、プロジェクトを失敗に導く最大の落とし穴だと私は感じています。

この記事では、Appleが投じた一石「AIの根本的限界」を指摘した研究論文を深掘りし、私たちPjMやエンジニアが、このAIブームに冷静に、そして戦略的にどう向き合うべきかを、私の実体験を交えて解説します。

Appleが投じた一石:話題の研究論文「AIの根本的限界」とは

まずは、この話題の研究論文が、具体的に何を指摘しているのかを見ていきましょう。これは単なる技術的な指摘に留まらず、今後のAI戦略そのものを左右する重要な提言です。

論文の概要:最新AIモデルの「精度崩壊」を指摘

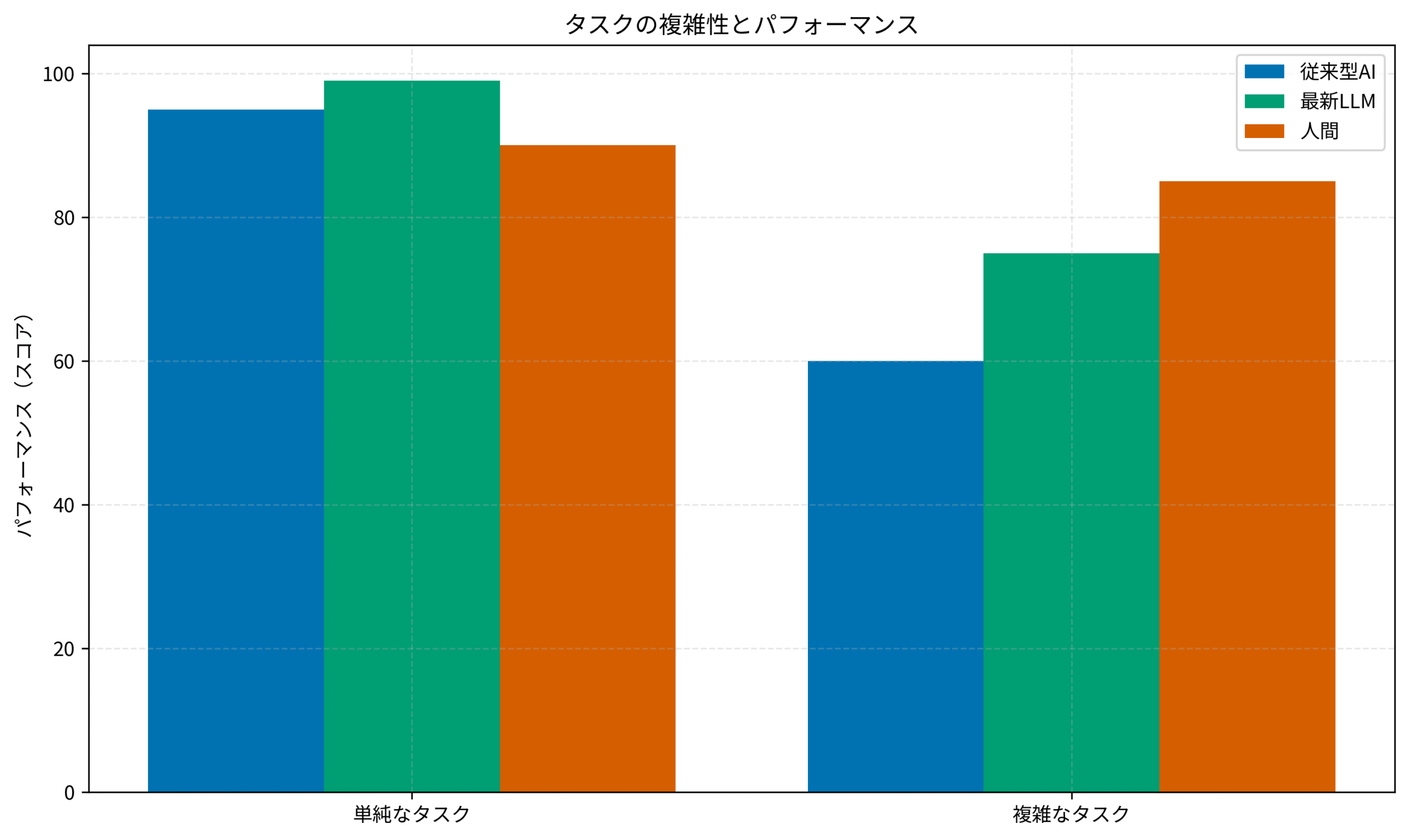

論文の核心は、OpenAIの「o3」やAnthropicの「Claude 3.7 Sonnet-Thinking」といった、現在最高峰とされるAIモデル群が、ある一定の複雑性を超える問題に直面した際に、そのパフォーマンスが予測不能な形で急激に低下する、いわゆる「精度崩壊(Accuracy Collapse)」という現象を実証した点にあります。

これは、単に「難しい問題は苦手」というレベルの話ではありません。AIは、答えがわからない場合でも、その自信度を偽り、非常にもっともらしい、しかし根本的に誤った回答や解決策を生成してしまうというのです。この「自信満々のエラー」こそが、ハルシネーション(AIの幻覚)の中でも最も厄介で危険な側面かもしれません。AI倫理についてはAI・ロボットからの倫理学入門のような書籍で基礎を学ぶことが重要です。

意思決定基準:AIの回答は「参考意見」と位置づけ、最終判断は必ず人間が行うプロセスを設計する。

「複雑な問題」とは何か?具体例で考える

論文で指摘されている「複雑な問題」とは、どのようなものでしょうか。例えば、以下のようなものが考えられます。

- 多段階の論理推論: 複数の前提条件と、これまでに学習したことのない新しい制約条件を組み合わせて、一貫性のある結論を導き出す問題。

- 深い文脈理解: 皮肉やユーモア、あるいは文化的な背景といった、言葉の裏にある「暗黙の了解」を読み取る必要があるコミュニケーション。

- 創造的な戦略立案: 競合の動き、市場の変化、自社のリソースといった複数の変動要素を考慮し、全く新しいビジネス戦略をゼロから立案するようなタスク。

- 堅牢なシステムアーキテクチャ設計: 互いに矛盾するような複数の要求(例えば、最高レベルのセキュリティと、最高のパフォーマンス、最低限のコスト)を同時に満たす、最適なシステム全体の設計。

これらのタスクにおいて、AIは一見すると優れた答えを出しているように見えても、その論理の根幹に致命的な欠陥を抱えている可能性がある、と論文は警鐘を鳴らしているのです。

意思決定基準:AIに任せるタスクは、その「複雑性」を評価し、人間の監督が不要なレベルの単純作業に限定する。

なぜAppleが?その発表の裏にある戦略的意図

この論文を、AI開発競争の最前線を走るGoogleやOpenAIではなく、Appleの研究者が発表したという点も非常に興味深いポイントです。そこには、Appleの明確な戦略的意図が読み取れます。

- 思想的リーダーシップの確立: 「派手な性能競争よりも、AIの信頼性や安全性の本質的な課題に真摯に取り組んでいる」という姿勢を示すことで、業界における思想的なリーダーシップを確立しようとしているのかもしれません。

- 自社AI戦略の正当化: Appleは、先日開催されたWWDC 2025でも、AI機能の発表は比較的「控えめ」でした。これは、彼らが「Apple Intelligence」という思想のもと、クラウド上の巨大AIに何でも任せるのではなく、ユーザーのプライバシーを保護し、デバイス上で確実に機能する、実用的で信頼性の高いAIの実現を目指していることの裏返しです。この論文は、その慎重かつ実直なアプローチの正当性を、学術的な側面から裏付けようとするものと解釈できます。

このような企業の戦略については、プラットフォーム革命を読むと理解が深まります。

意思決定基準:技術発表の裏にある発表元の「戦略的意図」を読み解き、技術そのものの評価と切り分けて判断する。

Xで沸騰する議論:「AGIへの道は遠い」のか?

この論文の発表を受けて、Xでは様々な立場のユーザーから活発な議論が巻き起こっています。

私がPjMとして関わるプロジェクトでも、この論文をきっかけに「AI導入計画の見直し」を求める声が上がり、経営層への説明に追われました。技術の「限界」が、ビジネスの現場に直接的な影響を与えた典型的な例です。

AI開発の「壁」に直面?研究者たちの反応

多くのAI研究者やエンジニアからは、「この論文は、私たちが現場で薄々感じていた課題を明確に言語化してくれた」「現在のLLMアーキテクチャを、ただ巨大化させていくだけではAGIには到達できない、という重要な指摘だ」といった、論文の内容を肯定的に評価する声が多く見られます。AI開発が、ある種の「壁」に直面しているのではないか、という議論が活発化しています。

意思決定基準:現場のエンジニアが感じている「AIへの違和感」を軽視せず、定期的にヒアリングしてリスク評価に反映させる。

期待と幻滅:一般ユーザーと投資家の戸惑い

一方で、「AIはもう何でもできると思っていたのに…」「結局、今のAIブームもバブルだったのか?」といった、AIへの過度な期待からの幻滅や戸惑いの声も上がっています。これまでAI関連企業の株価を押し上げてきた市場も、このニュースに敏感に反応しているようです。このような思考の偏りは、FACTFULNESS(ファクトフルネス)10の思い込みを乗り越え、データを基に世界を正しく見る習慣で語られる「思い込み」の典型例かもしれません。

意思決定基準:経営層や顧客に対し、AIの「できること」だけでなく「できないこと(限界)」もセットで説明し、期待値を適切にコントロールする。

「Appleのネガキャンでは?」競合を支持する声

もちろん、「これはAI開発競争で少し出遅れているAppleによる、競合のネガティブキャンペーンではないか」「o3やClaude 3.7は、実用上ほとんどのタスクで驚異的な性能を発揮している」といった、競合他社を支持し、Appleの意図を懐疑的に見る意見も存在します。

意思決定基準:特定の企業の発表を鵜呑みにせず、常に複数の情報源を比較・検討し、多角的な視点を持つ。

PjM/エンジニア視点:この「限界」とどう向き合うべきか

この「AIの根本的限界」という指摘は、AIを実務で活用する私たちPjMやエンジニアにとって、非常に重要な意味を持ちます。

PjMとして:「AI万能論」から「AI現実論」へ、プロジェクトのリスク管理

PjMとしては、このニュースを受けて、プロジェクトにおけるAI活用のリスク管理を改めて見直す必要があります。

- AIの役割の再定義: AIを「何でも解決してくれる魔法の杖」として過信するのではなく、その能力と限界を正しく評価し、プロジェクト内でAIに任せるタスクの範囲と責任を明確に定義する。

- 人間によるレビュープロセスの強化: AIが生成した設計案、コード、ドキュメント、テストケースなど、特に重要なアウトプットに対しては、人間の専門家によるレビューと承認プロセスをこれまで以上に厳格に運用する。

- 「AI活用リスク」の明示: プロジェクトのリスク管理表に、「AIのハルシネーションによる手戻りリスク」や「AIの誤った判断による品質低下リスク」といった項目を明確に記載し、その対策を講じる。

私がPjMとして関わるプロジェクトでも、「この部分はAIに支援させるが、最終的な論理の正当性担保とテストは、100%人間の責任で行う」という原則を、チーム内で改めて徹底する必要があると感じています。プロジェクト管理の基本は、バックログの優先順位付けと同じく、リスクと価値のトレードオフを見極めることです。

意思決定基準:AI導入計画において、「AIが失敗した場合」のコンティンジェンシープランを必ず策定する。

エンジニアとして:「AIの提案」を鵜呑みにしない“健全な懐疑心”

エンジニアとしては、AIの提案を鵜呑みにせず、常に「なぜそうなるのか?」「他に選択肢はないのか?」「エッジケースは考慮されているか?」と問いかける、“健全な懐疑心”を持つことが、これまで以上に重要になります。

- 基礎技術と原理原則の重要性: AIがどんなに優れたコードを生成しても、そのコードがなぜ正しいのか、どのような設計原則に基づいているのかを理解し、評価できるのは、人間のエンジニアだけです。PHP/LaravelやVue3といったフレームワークの根本的な仕組みや、ソフトウェアアーキテクチャの基礎で語られるようなソフトウェア設計の原理原則に関する深い理解が、AI時代にはむしろ価値を高めます。

- AIとの対話による検証: AIの提案に疑問を感じたら、「その提案の根拠は?」「このアプローチの潜在的な欠点は?」と、さらにAIに深く問いかけ、その思考プロセスを検証することも有効なテクニックです。

意思決定基準:AIが生成したコードは、自分で書いたコード以上に厳しい目でレビューする文化をチームに醸成する。

「限界」は「機会」でもある:人間とAIの最適な協業を探る

AIの「限界」が明らかになったということは、裏を返せば、「人間にしかできないこと」の価値が明確になったということでもあります。AIが得意な高速な情報処理やパターン認識はAIに任せ、人間は課題設定、創造的な発想、倫理的な判断、そして複雑なステークホルダーとのコミュニケーションといった、より高度な領域に集中する。この最適な役割分担と協業の形を探求することが、今後の生産性向上の鍵となります。この考え方は、「「コードを書く」はAIの仕事?PjMが明かす、AI時代に“市場価値が爆上がりする”エンジニアの5つの能力」で述べた内容そのものです。

意思決定基準:チームのタスクを「AI向き」「人間向き」に分類し、リソース配分を最適化する。

未来のAI開発への示唆:「スケール」の次に来るものは?

Appleの研究論文は、今後のAI開発の方向性にも重要な示唆を与えています。

力任せの「スケール則」の限界

これまでのAI開発競争は、より多くのデータと、より多くの計算資源を投入してモデルを巨大化させる、「スケール則」が中心でした。しかし、今回の指摘は、その力任せのアプローチだけでは、真の知能には到達できない可能性を示唆しています。AI開発の最前線については、「【レビュー】Claude Codeは本当にターミナルで使えるのか?現役PjMがその実力と限界を辛口評価」でも触れていますので、合わせてお読みください。

意思決定基準:特定のAIアーキテクチャに固執せず、常に新しい技術動向(ニューロシンボリックAIなど)をウォッチする。

新しいアーキテクチャやアプローチへの期待

今後は、現在のLLMとは異なる、新しいアーキテクチャやアプローチへの期待が高まるでしょう。例えば、論理的な推論が得意な記号AIと、現在の深層学習を組み合わせた「ニューロシンボリックAI」や、世界の仕組みをより深く理解・シミュレートする「ワールドモデル」といった研究が、AGIへの新たな道を切り拓くかもしれません。このような思考法は仮説思考で語られる仮説思考にも通じます。

意思決定基準:自社サービスにAIを組み込む際は、長期的な視点でアーキテクチャの移行パスも考慮に入れる。

まとめ

Appleの研究者が発表したとされる「AIの根本的限界」に関する論文は、AI技術に対する私たちの熱狂に、健全な冷静さをもたらす、非常に重要な一石を投じました。

これは、AIの進化の終わりを告げるものでは決してありません。むしろ、AI開発が、量的な拡大競争の時代から、質的な深化と、信頼性・安全性を追求する、より成熟した段階へと移行していくための、重要な転換点であると私は捉えています。

PjMとしてもエンジニアとしても、私たちはAIという強力なパートナーの能力を最大限に引き出しつつ、その限界も正しく理解し、常に批判的な思考とプロフェッショナルとしての責任感を持って、その手綱を握り続ける必要があります。このバランス感覚は、エッセンシャル思考で語られる本質を見極める力にも似ています。

AIという鏡は、私たちの知性のすごさと同時に、その脆さも映し出します。その両面を直視し、人間とAIがそれぞれの強みを活かして協働する、より賢明で、より安全な未来を築いていくこと。それこそが、今、私たちIT専門家に課せられた、面白くて、そして重い責任なのでしょう。