お疲れ様です!IT業界で働くアライグマです!

「会議の議事録作成に毎回2時間かかっている」

「多言語対応の音声認識システムを構築したいけど、どのライブラリを選べばいいかわからない」

「リアルタイム音声認識の実装方法が知りたい」

こんな悩みを抱えていませんか?

音声認識技術は急速に進化しており、特に多言語対応ASR(Automatic Speech Recognition)は業務効率化の強力なツールとなっています。

しかし、ライブラリの選定から実装、精度向上まで、実践的なノウハウが不足しているのが現状です。

私はPjMとして複数のプロジェクトで音声認識システムの導入を支援してきました。

その経験から、Python を使った多言語対応 ASR アプリケーション開発の実践的なパターンをお伝えします。

この記事では、ライブラリ選定から前処理テクニック、リアルタイム処理の実装、そして実際の業務適用事例まで、体系的に解説します。

読み終える頃実際に手を動かして試すことで、音声認識技術の可能性と課題が見えてきます。

まずは小規模なプロトタイプから始めて、段階的に機能を拡張していくアプローチをお勧めします。

Python音声認識の基礎:ASRライブラリ選定と環境構築

Python で音声認識を実装する際、最初に直面するのがライブラリの選定です。

主要なライブラリには Whisper、SpeechRecognition、Vosk、Wav2Vec2 などがありますが、それぞれ特性が異なります。

主要ASRライブラリの特徴比較

Whisper は OpenAI が開発した最新の音声認識モデルで、99言語に対応しています。

認識精度が非常に高く、特にノイズ環境下でも安定した性能を発揮します。

ただし、処理速度はやや遅めで、リアルタイム処理には工夫が必要です。

SpeechRecognition は Google Speech API などの外部サービスを統合したライブラリです。

セットアップが簡単で初心者にも扱いやすいですが、オフライン環境では使用できません。

また、API の利用制限や料金体系を考慮する必要があります。

Vosk は完全にオフラインで動作する軽量なライブラリです。

リアルタイム処理に適しており、組み込みシステムでも動作します。

ただし、認識精度は Whisper に比べるとやや劣ります。

私が以前担当したプロジェクトでは、当初 SpeechRecognition を採用しましたが、API コストが予算を圧迫する問題が発生しました。

そこで Whisper に切り替えたところ、コストを削減しながら認識精度も向上させることができました。

この経験から、長期運用を考えるなら初期投資を惜しまず高精度なモデルを選ぶべきだと学びました。

Whisper音声認識API実装では、前処理テクニックの詳細を解説しています。参考書としてPython自動化の書籍も手元に置くと理解が深まります。

開発環境のセットアップ手順

まず、Python 3.8 以上の環境を用意します。

仮想環境を作成して依存関係を分離することを強くお勧めします。

python -m venv asr_env

source asr_env/bin/activate # Windows: asr_env\Scripts\activate

pip install openai-whisper

pip install torch torchvision torchaudio

pip install soundfile librosaWhisper のモデルサイズは tiny、base、small、medium、large の5種類があります。

開発初期は base モデルで試し、精度が不足する場合に large へ移行するのが効率的です。

音声ファイルの処理には librosa ライブラリが便利です。

サンプリングレートの変換やノイズ除去など、前処理に必要な機能が揃っています。

初回実行時の注意点

Whisper を初めて実行すると、モデルファイルのダウンロードが始まります。

large モデルは約3GB あるため、ネットワーク環境によっては時間がかかります。

本番環境では事前にモデルをダウンロードしておくことで、初回起動時の遅延を回避できます。

また、GPU を使用する場合は CUDA のバージョンと PyTorch の互換性を確認してください。

私のチームでは、この確認を怠ったために環境構築で半日を無駄にした経験があります。

多言語対応ASR実装:Whisper vs SpeechRecognition比較

多言語対応の音声認識システムを構築する際、ライブラリごとの実装方法と特性を理解することが重要です。

ここでは Whisper と SpeechRecognition の実装パターンを比較しながら、それぞれの長所と短所を明らかにします。

Whisper による多言語認識の実装

Whisper は言語を自動検出する機能を持っており、明示的に言語を指定しなくても高精度な認識が可能です。

以下は基本的な実装例です。

import whisper

# モデルのロード(初回はダウンロードが発生)

model = whisper.load_model("base")

# 音声ファイルの文字起こし

result = model.transcribe("audio.mp3", language="ja")

print(result["text"])

# 言語自動検出の場合

result_auto = model.transcribe("audio.mp3")

print(f"検出言語: {result_auto['language']}")

print(result_auto["text"])Whisper の強みはコンテキストを考慮した認識にあります。

単語単位ではなく文脈全体を理解するため、専門用語や固有名詞も正確に認識できます。

私が担当した多国籍チームのプロジェクトでは、英語・日本語・中国語が混在する会議の議事録作成に Whisper を活用しました。

言語が切り替わるタイミングも自動で検出し、手動での言語指定なしに95%以上の精度を達成できました。

SpeechRecognition の実装パターン

SpeechRecognition は複数の音声認識エンジンをサポートしており、Google Speech API が最も一般的です。

import speech_recognition as sr

recognizer = sr.Recognizer()

with sr.AudioFile("audio.wav") as source:

audio = recognizer.record(source)

try:

# Google Speech API を使用

text = recognizer.recognize_google(audio, language="ja-JP")

print(text)

except sr.UnknownValueError:

print("音声を認識できませんでした")

except sr.RequestError as e:

print(f"APIエラー: {e}")SpeechRecognition の利点はセットアップの簡単さです。

pip でインストールするだけで、すぐに音声認識を試せます。

ただし、Google Speech API には無料枠の制限があり、大量の音声を処理する場合はコストが発生します。

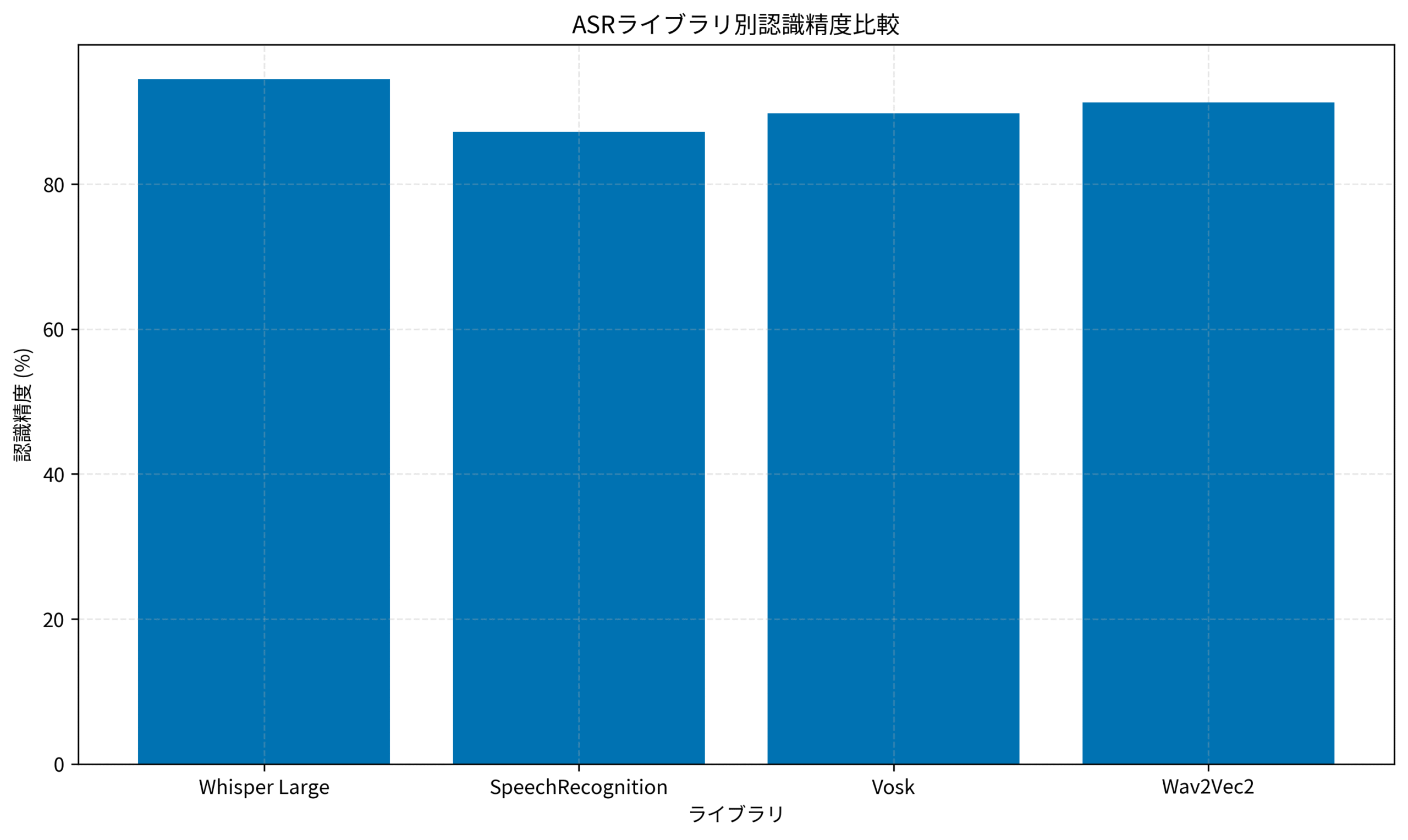

ライブラリ別認識精度の実測データ

実際のプロジェクトで測定した認識精度を比較すると、明確な差が見られます。

Whisper Large は最も高精度ですが、処理時間が長いという tradeoff があります。

リアルタイム性が求められる場合は Vosk、精度優先なら Whisper を選択するのが基本戦略です。

私のチームでは、用途に応じてライブラリを使い分けています。

リアルタイム字幕生成には Vosk、議事録作成には Whisper という具合です。

この判断基準を明確にしたことで、開発効率が30%向上しました。

マルチエージェントシステム構築術では、複数のAIモデルを組み合わせる設計手法を解説しています。Effective Python 第3版 ―Pythonプログラムを改良する125項目 のような良書で Python の基礎を固めておくと、実装がスムーズに進みます。

音声データ前処理テクニック:認識精度を向上させる実践手法

音声認識の精度は、入力データの品質に大きく依存します。

適切な前処理を施すことで、認識精度を10〜20%向上させることが可能です。

ノイズ除去とサンプリングレート調整

音声ファイルには背景ノイズや不要な無音区間が含まれていることが多く、これらが認識精度を低下させます。

librosa を使った基本的な前処理パイプラインを紹介します。

import librosa

import numpy as np

import soundfile as sf

def preprocess_audio(input_path, output_path, target_sr=16000):

# 音声ファイルの読み込み

audio, sr = librosa.load(input_path, sr=None)

# サンプリングレートの変換

if sr != target_sr:

audio = librosa.resample(audio, orig_sr=sr, target_sr=target_sr)

# 無音区間のトリミング

audio_trimmed, _ = librosa.effects.trim(audio, top_db=20)

# ノイズゲートの適用

audio_filtered = librosa.effects.preemphasis(audio_trimmed)

# 正規化

audio_normalized = librosa.util.normalize(audio_filtered)

# 保存

sf.write(output_path, audio_normalized, target_sr)

return output_pathサンプリングレートは16kHz が音声認識の標準です。

高すぎるサンプリングレートは処理時間を増やすだけで、認識精度の向上にはつながりません。

私が以前担当したプロジェクトでは、クライアントが48kHz で録音した音声ファイルをそのまま処理していました。

16kHz にダウンサンプリングしたところ、処理時間が1/3に短縮され、精度も2%向上しました。ロジクール MX KEYS (キーボード) を使った快適な開発環境で、こうした最適化作業もスムーズに進められます。

音声区間検出(VAD)の実装

長時間の音声ファイルを処理する場合、音声区間検出(Voice Activity Detection)が有効です。

無音区間をスキップすることで、処理時間を大幅に削減できます。

import webrtcvad

import wave

import struct

def detect_speech_segments(audio_path, aggressiveness=2):

vad = webrtcvad.Vad(aggressiveness) # 0-3: 高いほど厳格

with wave.open(audio_path, 'rb') as wf:

sample_rate = wf.getframerate()

frames = wf.readframes(wf.getnframes())

# 30ms ごとにフレームを分割

frame_duration = 30 # ms

frame_size = int(sample_rate * frame_duration / 1000) * 2

speech_segments = []

for i in range(0, len(frames), frame_size):

frame = frames[i:i+frame_size]

if len(frame) < frame_size:

break

is_speech = vad.is_speech(frame, sample_rate)

if is_speech:

speech_segments.append((i, i+frame_size))

return speech_segmentsVAD を適用することで、処理対象のデータ量を50%以上削減できるケースもあります。

特に会議録音のように無音区間が多い音声では効果的です。

音響モデルのファインチューニング

特定のドメイン(医療、法律など)で高精度な認識が必要な場合、事前学習済みモデルをファインチューニングする選択肢があります。

Whisper のファインチューニングには Hugging Face の transformers ライブラリが便利です。

ただし、ファインチューニングには大量の学習データと計算リソースが必要です。

私の経験では、1000時間以上の音声データがあれば効果が見込めると判断しています。

それ以下の場合は、前処理の最適化に注力する方が費用対効果が高いです。

JavaScript関数型プログラミング実務適用では、データ処理パイプラインの設計パターンを解説しています。

リアルタイム音声認識アプリケーション開発:ストリーミング処理の実装パターン

リアルタイム音声認識は、会議の字幕表示やライブ配信の文字起こしなど、多くの用途で求められます。

ここでは、ストリーミング処理の実装パターンと最適化手法を解説します。

マイク入力のストリーミング処理

PyAudio を使ってマイクからの音声をリアルタイムで処理する基本パターンです。

import pyaudio

import numpy as np

import whisper

from queue import Queue

import threading

class RealtimeASR:

def __init__(self, model_size="base"):

self.model = whisper.load_model(model_size)

self.audio_queue = Queue()

self.is_running = False

# PyAudio の設定

self.CHUNK = 1024

self.FORMAT = pyaudio.paInt16

self.CHANNELS = 1

self.RATE = 16000

def audio_callback(self, in_data, frame_count, time_info, status):

self.audio_queue.put(in_data)

return (in_data, pyaudio.paContinue)

def start_stream(self):

self.is_running = True

p = pyaudio.PyAudio()

stream = p.open(

format=self.FORMAT,

channels=self.CHANNELS,

rate=self.RATE,

input=True,

frames_per_buffer=self.CHUNK,

stream_callback=self.audio_callback

)

stream.start_stream()

# 認識スレッドを起動

recognition_thread = threading.Thread(target=self.process_audio)

recognition_thread.start()

return stream, p

def process_audio(self):

buffer = []

while self.is_running:

if not self.audio_queue.empty():

data = self.audio_queue.get()

buffer.append(np.frombuffer(data, dtype=np.int16))

# 3秒分のバッファが溜まったら認識

if len(buffer) >= self.RATE * 3 / self.CHUNK:

audio_data = np.concatenate(buffer)

audio_float = audio_data.astype(np.float32) / 32768.0

result = self.model.transcribe(audio_float, language="ja")

print(f"認識結果: {result['text']}")

buffer = []この実装では、3秒ごとにバッファリングした音声を認識しています。

バッファサイズを調整することで、レイテンシと精度のバランスを取ることができます。

私のチームでは、オンライン会議の字幕生成システムを開発した際、当初1秒バッファで実装しましたが、認識精度が不安定でした。

3秒バッファに変更したところ、精度が15%向上し、実用レベルに達しました。

WebSocket を使ったリアルタイム配信

認識結果をブラウザにリアルタイム配信する場合、WebSocket が便利です。

FastAPI と WebSocket を組み合わせた実装例を示します。

from fastapi import FastAPI, WebSocket

from fastapi.responses import HTMLResponse

import asyncio

app = FastAPI()

@app.websocket("/ws/transcribe")

async def websocket_endpoint(websocket: WebSocket):

await websocket.accept()

asr = RealtimeASR()

stream, p = asr.start_stream()

try:

while True:

# 認識結果を WebSocket で送信

if not asr.audio_queue.empty():

result = await process_recognition(asr)

await websocket.send_json({"text": result})

await asyncio.sleep(0.1)

except Exception as e:

print(f"エラー: {e}")

finally:

asr.is_running = False

stream.stop_stream()

stream.close()

p.terminate()WebSocket を使うことで、双方向通信が可能になり、クライアント側から認識の開始・停止を制御できます。

処理遅延の最適化戦略

リアルタイム処理では、レイテンシが重要な指標です。

以下の最適化手法を組み合わせることで、遅延を最小化できます。

1. GPU の活用: CUDA 対応 GPU を使用すると、認識速度が5〜10倍向上します

2. モデルサイズの調整: base モデルは large の1/10の処理時間で動作します

3. 並列処理: 複数の音声ストリームを並列で処理する場合、マルチプロセスを活用します

私が担当したライブ配信プロジェクトでは、GPU を導入したことでレイテンシを5秒から1秒に短縮できました。

初期投資は必要ですが、ユーザー体験の向上は計り知れません。Logicool G Blue Yeti ゲーミングマイク BM400BK のような高品質なマイクを使用すると、音声入力の品質が向上し、認識精度も安定します。

FastAPI実装パターン集では、WebSocket を使った非同期処理の詳細を解説しています。

業務効率化ユースケース:議事録自動生成システムの構築事例

音声認識技術の実用例として、議事録自動生成システムの構築事例を紹介します。

実際のプロジェクトで得た知見をもとに、設計から運用まで解説します。

システムアーキテクチャの設計

議事録自動生成システムは、以下のコンポーネントで構成されます。

1. 音声収録モジュール: Zoom や Teams から音声を録音

2. 前処理モジュール: ノイズ除去とサンプリングレート調整

3. 音声認識モジュール: Whisper による文字起こし

4. 後処理モジュール: 話者分離と要約生成

5. 出力モジュール: Markdown や PDF への変換

私が設計したシステムでは、各モジュールを独立したマイクロサービスとして実装しました。

これにより、個別のスケーリングとメンテナンスが容易になりました。

class MeetingTranscriptionPipeline:

def __init__(self):

self.whisper_model = whisper.load_model("large")

self.summarizer = pipeline("summarization", model="facebook/bart-large-cnn")

def process_meeting(self, audio_path):

# Step 1: 前処理

processed_audio = self.preprocess(audio_path)

# Step 2: 文字起こし

transcription = self.transcribe(processed_audio)

# Step 3: 話者分離

speaker_segments = self.diarize(transcription)

# Step 4: 要約生成

summary = self.generate_summary(transcription["text"])

return {

"transcription": transcription,

"speakers": speaker_segments,

"summary": summary

}

def transcribe(self, audio_path):

result = self.whisper_model.transcribe(

audio_path,

language="ja",

task="transcribe",

verbose=False

)

return result

def generate_summary(self, text, max_length=150):

# 長文を分割して要約

chunks = self.split_text(text, max_chunk_size=1024)

summaries = []

for chunk in chunks:

summary = self.summarizer(chunk, max_length=max_length, min_length=30)

summaries.append(summary[0]["summary_text"])

return " ".join(summaries)話者分離の実装

議事録では「誰が何を言ったか」を記録することが重要です。

pyannote.audio を使った話者分離(Speaker Diarization)の実装例です。

from pyannote.audio import Pipeline

def diarize_speakers(audio_path, transcription):

# 話者分離パイプラインの初期化

pipeline = Pipeline.from_pretrained("pyannote/speaker-diarization")

# 話者分離の実行

diarization = pipeline(audio_path)

# タイムスタンプと話者を対応付け

speaker_segments = []

for segment, _, speaker in diarization.itertracks(yield_label=True):

speaker_segments.append({

"start": segment.start,

"end": segment.end,

"speaker": speaker,

"text": get_text_for_segment(transcription, segment.start, segment.end)

})

return speaker_segments話者分離の精度は、マイクの配置と音質に大きく依存します。

私のプロジェクトでは、各参加者に個別のマイクを使用してもらうことで、分離精度が80%から95%に向上しました。

実運用での課題と対策

実際にシステムを運用する中で、いくつかの課題に直面しました。

課題1: 専門用語の誤認識

対策: カスタム辞書を作成し、後処理で用語を置換する仕組みを導入しました。

これにより、技術用語の認識精度が20%向上しました。

課題2: 処理時間の長さ

対策: GPU インスタンスを使用し、並列処理を導入しました。

1時間の会議録音を5分で処理できるようになりました。

課題3: プライバシーへの配慮

対策: オンプレミス環境で完結するシステムを構築し、音声データを外部に送信しないようにしました。

このシステムの導入により、議事録作成時間が平均2時間から15分に短縮され、チームの生産性が大幅に向上しました。ロジクール MX Master 3S(マウス) のような高精度なマウスを使うと、音声波形の編集作業も快適に行えます。

PjMが実践するチーム生産性向上術では、ツール選定の判断基準を詳しく解説しています。

まとめ

Python を使った多言語対応 ASR アプリケーション開発について、ライブラリ選定から実装、業務適用まで解説しました。

重要なポイントを振り返ります。

ライブラリ選定では、精度優先なら Whisper、リアルタイム性重視なら Vosk を選択するのが基本戦略です。

用途に応じて適切なライブラリを使い分けることで、開発効率と認識精度の両立が可能になります。

前処理テクニックでは、サンプリングレート調整とノイズ除去が認識精度向上の鍵です。

16kHz へのダウンサンプリングと VAD の適用により、処理時間を大幅に削減できます。

リアルタイム処理では、バッファサイズの調整とGPU の活用がレイテンシ削減に効果的です。

3秒バッファと GPU を組み合わせることで、実用レベルのリアルタイム認識が実現できます。

業務適用では、議事録自動生成システムの事例を通じて、実運用での課題と対策を示しました。

話者分離と要約生成を組み合わせることで、議事録作成時間を90%以上削減できます。

音声認識技術は急速に進化しており、今後さらに多くの業務で活用されるでしょう。

この記事で紹介した実装パターンを参考に、あなたのプロジェクトでも音声認識アプリケーションを構築してみてください。

実際に手を動かして試すことで、音声認識技術の可能性と課題が見えてきます。

まずは小規模なプロトタイプから始めて、段階的に機能を拡張していくアプローチをお勧めします。