こんばんは!IT業界で働くアライグマです!

AIコーディングエディタ「Cursor」と、ローカル環境で大規模言語モデル(LLM)を実行できる「Ollama」の組み合わせが、今、多くの開発者の間で大きな注目を集めています。私のブログの検索データを見ても、「cursor ローカルllm」や「cursor ollama」といったキーワードでの検索数が急増しており、その関心の高さがひしひしと伝わってきます。

多くの開発者がこの技術スタックに期待するのは、何と言ってもその圧倒的なセキュリティとオフライン環境での利用可能性でしょう。業務で扱う機密情報や、まだ世に出していないプライベートなコードを、外部のAPIに送信することなく手元のマシンだけでAIの恩恵を受けられる。これは、開発者にとって長年の夢だったと言っても過言ではありません。

しかし、その活用方法は、単なるコード生成やチャットだけに留まらないことをご存知でしょうか?

本記事では、このCursorとOllamaという強力な組み合わせを、開発プロセスにおいて最も時間と精神を消耗する作業の一つ、「デバッグ」に応用するための、より実践的で具体的なワークフローを徹底解説します。

エラーメッセージの解析、原因の特定、そして修正コードの提案まで、AIを単なる「おもちゃ」ではなく、頼れる「デバッグの相棒」として活用するための具体的なステップを紹介します。この記事を読めば、あなたの開発効率が劇的に向上することをお約束します。

なぜ今、「ローカルLLM」での開発が求められるのか?

ChatGPTをはじめとするクラウドベースのAIサービスは非常に強力ですが、業務利用においては常にいくつかの懸念がつきまといます。

- 情報漏洩のリスク: 業務で扱うコードには、APIキー、データベースの接続情報、特許に関わる独自のビジネスロジックなど、絶対に外部に漏れてはならない機密情報が含まれています。これらの情報を安易に外部サービスに貼り付けることは、重大なセキュリティインシデントに繋がりかねません。

- コンテキストの不足: エラーが発生したコードの一部だけを切り取って質問しても、AIはプロジェクト全体の文脈や、ファイル間の依存関係を理解できません。そのため、表面的で的確でない回答が返ってくることも少なくありませんでした。

- 利用コストとネットワーク依存: APIの利用には当然コストがかかりますし、オフライン環境やネットワークが不安定な場所では利用できません。

CursorとOllamaを使ったローカルLLM環境は、これらの問題を一挙に解決します。このテーマについては、以前の記事「ChatGPTやClaudeのAPIはもう不要?ローカルLLMのメリットと、自宅PCでAIを動かすための具体的な手順」でも詳しく解説しました。

- 完全なセキュリティ: すべての処理があなたのローカルマシン内で完結するため、ソースコードが外部に送信されることは一切ありません。安心して業務コードをAIに“相談”できます。

- 豊富なコンテキスト: Cursorの強力な機能を使えば、エラーが発生したファイルだけでなく、関連するファイル群やプロジェクト全体のコードベースをAIにコンテキストとして与えることができます。これにより、AIはコードをより深く、正確に理解し、精度の高い分析と提案を行えるようになります。

- コストゼロ・オフライン利用可: 一度モデルをダウンロードしてしまえば、API利用料はかかりません。飛行機の中や、セキュリティが厳しい客先のオフライン環境でも、AIのサポートを受けながら開発を進めることができます。

このように、ローカルLLMは、プロフェッショナルな開発現場のニーズに応えるための、まさに“ゲームチェンジャー”となり得る技術なのです。

準備編:CursorでOllamaを使うための環境構築

それでは、実際にデバッグフローを試す前に、環境構築の手順を簡単におさらいしましょう。

Ollamaのインストールとモデルの準備

まずは、お使いのPCにOllamaをインストールします。公式サイトから、お使いのOS(Mac, Linux, Windows)に合ったインストーラーをダウンロードして実行してください。

インストールが完了したら、ターミナルを開いて、AIモデルをダウンロードします。デバッグやコーディング用途であれば、Meta社が開発したLlama 3や、コーディングに特化したCode Llamaがおすすめです。

# Llama 3 (8Bモデル) をダウンロード

ollama pull llama3

# Code Llama (7Bモデル) をダウンロード

ollama pull codellama

ollama listというコマンドを実行して、今ダウンロードしたモデルが表示されれば準備完了です。

Cursorの設定

次に、Cursor側でOllamaを使う設定を行います。この連携方法については、「「AIにコードを見せるのが怖い」を解決。Cursor + Ollamaで実現する、完全ローカルAIコーディング術」で、より詳しく解説しています。

- Cursorを開き、設定画面に移動します。

- 「AI」のセクションを探し、「Model」の設定項目をクリックします。

- モデルプロバイダーの一覧から「Ollama」を選択します。

- 「Chat Model」や「Edit Model」のドロップダウンメニューに、先ほどダウンロードした

llama3やcodellamaが表示されるはずなので、それを選択します。

これで、CursorのAI機能が、外部のAPIではなく、あなたのPC上で動いているOllamaと通信するようになりました。

実践編:Cursor + Ollama 爆速デバッグフロー

お待たせしました。ここからは、具体的なエラーシナリオを想定し、デバッグのステップを順を追って解説していきます。

ステップ1: エラー発生!まずは落ち着いてログを確認

アプリケーションを実行したところ、ターミナルに無慈悲なエラーメッセージが表示されました。これが我々の冒険の始まりです。

Traceback (most recent call last):

File "/home/user/projects/my_app/main.py", line 25, in

result = process_data(data)

File "/home/user/projects/my_app/utils.py", line 15, in process_data

return item['details']['name']

KeyError: 'details'

このスタックトレースから、utils.pyというファイルの15行目でKeyErrorが発生していることがわかります。辞書型のデータから'details'というキーで値を取得しようとしたけれど、そのキーが存在しなかった、という典型的なエラーですね。

以前の私なら、ここからprint文を仕込んだり、デバッガを起動したりして、item変数の中身を一つずつ確認していたことでしょう。しかし、今は我々にはAIという相棒がいます。

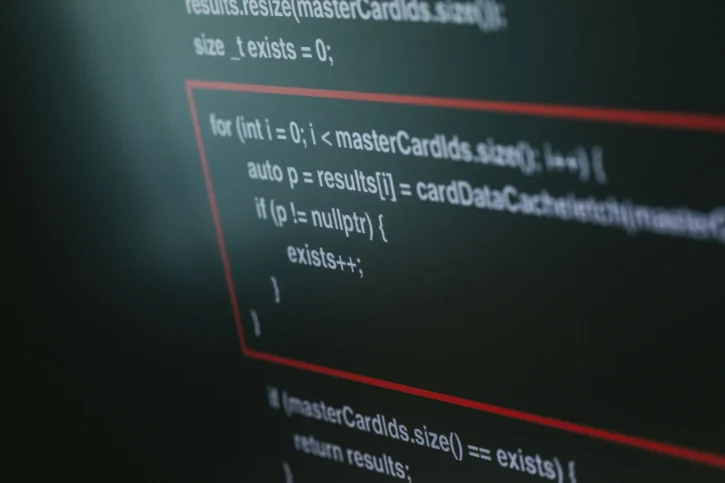

ステップ2: AIにエラー解析を依頼する(@-mentionが鍵)

次に、Cursorのチャット機能を使って、AIにエラーの原因分析を依頼します。ここで最も重要なのが、@-mention(@記号)を駆使して、AIに参照してほしいコードの範囲を正確に伝えることです。

- Cursorのチャットパネルを開きます(ショートカットキー:

Cmd/Ctrl + K)。 - チャット入力欄に、以下のように入力します。

「

@utils.pyと@main.pyのコードを読んで。以下のエラーの原因と、最も安全な解決策を教えてください。」

- その下に、先ほどターミナルに表示されたエラーメッセージの全文をコピー&ペーストします。

このように、@でファイル名を指定することで、AIは該当するファイルのコード全体をコンテキストとして読み込み、分析を開始します。これにより、「エラーメッセージだけ」を伝えるよりも、遥かに高精度な回答が期待できるのです。

ステップ3: AIからの提案を吟味し、原因を特定する

質問を送信すると、ローカルで稼働しているLLMが分析を行い、数秒から数十秒で回答を返してくれます。

AIの回答例:

ご質問ありがとうございます。提供されたコードとエラーログを分析しました。

エラーの原因:

エラーの原因は、utils.pyのprocess_data関数内で、引数として受け取った辞書itemに、キー'details'が存在しない場合があるためです。main.pyの20行目で定義されているdataリストの3番目の要素{'id': 3, 'value': 300}には、'details'キーが含まれていません。この要素がprocess_data関数に渡された際にKeyErrorが発生しています。解決策の提案:

このエラーを回避するためには、process_data関数を修正し、'details'キーや'name'キーが存在するかどうかをチェックする処理を追加するのが最も安全です。Pythonのget()メソッドを使うと、キーが存在しない場合にNoneなどのデフォルト値を返すことができるため、コードがシンプルになります。以下に修正案を提示します。

def process_data(item): # item.get('details', {}) とすることで、'details'キーがなくても空の辞書を返す details = item.get('details', {}) # detailsから'name'キーを取得。存在しない場合はNoneを返す return details.get('name')このように修正すれば、

KeyErrorを発生させることなく、安全に値を取得できます。

どうでしょうか。AIはエラーの原因を的確に特定しただけでなく、具体的な修正コードまで提案してくれました。しかも、なぜその修正が良いのかという理由(get()メソッドの利点)まで解説してくれています。

ステップ4: 修正コードの適用と対話による改善

AIが提案したコードが妥当であれば、それを適用します。Cursorには、AIが提案したコードブロックをワンクリックでファイルに適用する機能もあります。

コードを修正したら、再度アプリケーションを実行し、エラーが解消されたことを確認します。

もし、提案されたコードが100%理想通りでなかったとしても、問題ありません。チャットで追加の要望を伝えることで、さらにコードを洗練させていくことができます。

「ありがとう。その修正で良さそうだけど、

Noneを返す代わりに、デフォルト値として空文字列''を返すように変更してくれない?」

このようにAIと対話を続けることで、まるで人間のペアプログラマーと一緒に仕事をしているかのように、デバッグ作業を進めることができるのです。

ちなみに、こうした難解なバグを論理的に解決していく思考法については、以前こちらの記事「「謎はすべて解けた!」金田一少年の事件簿に学ぶ、難解バグの“真犯人”を突き止めるデバッグ思考法」で詳しく解説しました。この思考法を身につけると、AIへの質問の質も向上するかもしれません。

デバッグだけじゃない!ローカルLLMの無限の可能性

CursorとローカルLLMの組み合わせは、デバッグ以外にも様々な開発タスクを効率化してくれます。

- リファクタリング: 複雑な関数やクラスを

@で指定し、「このコードを、よりクリーンで読みやすい形にリファクタリングして」と依頼する。 - ドキュメント生成: Pythonの関数を選択し、「この関数のDocstringを生成して」と依頼する。

- テストコード作成: 既存のコードを基に、「この関数のためのユニットテストをPytestで書いて」と依頼する。

- 新しい技術の学習: 新しいライブラリのコードを読み込ませ、「このライブラリの基本的な使い方を、簡単なサンプルコード付きで教えて」と質問する。

これらの作業を、すべてセキュアなローカル環境で行えるのが最大の強みです。この究極のワークフローについては、「ObsidianとCursor、そしてローカルLLM。PjMが実践する「思考の全て」を統合する究極のAI開発環境」で詳しく解説しています。

ローカルLLMを快適に動かすには、ある程度のマシンパワー、特にグラフィックボード(GPU)の性能が重要になります。もし本格的な活用を考えているなら、NVIDIAのGeForce RTXシリーズのような、AI処理に強いGPUへの投資を検討するのも良いでしょう。

NVIDIA GeForce RTXシリーズ (グラフィックボード)

まとめ

今回は、AIコーディングエディタ「Cursor」とローカルLLM実行環境「Ollama」を組み合わせた、次世代のデバッグ手法について詳しく解説しました。

- ローカルLLMは、セキュリティとコンテキスト理解の面でクラウドAIを凌駕する。

- OllamaとCursorのセットアップは非常に簡単。

- デバッグの鍵は、

@メンションでAIに正確なコンテキストを伝えること。 - AIとの対話を通じて、コードを改善していくペアプログラミング体験が可能。

これまで一人でうんうんと唸りながら、print文を大量に仕込んで格闘していたデバッグ作業。その時間が、AIという優秀な“相棒”の力を借りることで、劇的に短縮され、より創造的な作業へと変わっていく。そんな未来が、もうすぐそこまで来ています。

もちろん、AIの提案が常に100%正しいとは限りません。最終的な判断を下すのは、我々エンジニアです。しかし、AIを思考の壁打ち相手として、あるいは有能なアシスタントとして使いこなす能力は、間違いなくこれからのエンジニアにとって必須のスキルとなるでしょう。

達人プログラマーたちが示すように、常に新しいツールを学び、自身の生産性を高める努力を続けることが重要です。

達人プログラマーぜひ、あなたの開発環境にもローカルLLMを取り入れて、この新しい開発体験を味わってみてください。