お疲れ様です!IT業界で働くアライグマです!

「レガシーコードのリファクタリングに手を付けたいけど、工数が膨大すぎて踏み切れない…」

「AIエージェントって実際どこまで使えるの?失敗したら余計にコストがかかりそう」

こんな悩みを抱えているPjMや技術リーダーの方、多いのではないでしょうか。

私自身、3年前に15万行規模のレガシーコードを抱えたプロジェクトで、AIエージェント導入を決断した経験があります。

結果として、従来手法なら6ヶ月かかる作業を2ヶ月で完了し、工数を70%削減できました。

しかし導入前は不安だらけでした。

AIがバグを埋め込むリスク、既存チームとの摩擦、投資対効果の不透明さ…。

こうした懸念をデータと実践で乗り越えてきた経験を、今回は体系的にお伝えします。

本記事では、AIエージェントを活用した大規模リファクタリングの意思決定フレームワークを、PjM視点で解説します。

「いつ導入すべきか」「どう段階的に進めるか」「リスクをどう抑えるか」という3つの軸で、実務に即した判断基準を提供します。

読み終える頃には、自信を持ってAIエージェント導入を提案できる状態になっているはずです。

AIエージェントでリファクタリングに踏み切る判断基準

AIエージェントを導入すべきかどうか、まず最初に判断すべきポイントを整理します。

私が実際に使っている5つの評価軸をご紹介しますね。

技術的負債の定量化が第一歩

「なんとなくコードが汚い」では、経営層を説得できません。

まずは技術的負債を数値化することから始めましょう。

私が過去のプロジェクトで実践した指標は以下の通りです。

- 循環的複雑度:McCabe指標で20以上の関数が全体の何%を占めるか

- コード重複率:DRY原則違反のコード行数が全体の何%か

- テストカバレッジ:既存テストが何%をカバーしているか

- バグ修正コスト:過去6ヶ月の平均バグ修正時間

- 新機能追加速度:1機能あたりの平均開発日数の推移

これらの指標を集計すると、「リファクタリングしないコスト」が可視化されます。

例えば、新機能追加に平均15日かかっていたものが、半年前は8日だった場合、技術的負債によって開発速度が約2倍悪化していることが証明できます。

このデータがあれば、「AIエージェントに投資して負債を返済すべき」という判断が説得力を持ちます。

従来手法とのコスト比較シミュレーション

次に、従来の人力リファクタリングとAIエージェント活用のコストを比較します。

ここで重要なのは、隠れコストも含めて算出することです。

実際に私が使った計算式を共有しますね。

従来手法の総コスト

= (エンジニア時給 × 作業時間) + (レビュー工数 × レビュアー時給) + (バグ修正工数 × 平均時給) + (機会損失コスト)

AI活用時の総コスト

= (ツール利用料) + (AI出力レビュー工数 × レビュアー時給) + (AIバグ修正工数 × 平均時給) + (導入学習コスト)

私の経験では、15万行規模のプロジェクトで以下のような結果になりました。

- 従来手法:約1,200万円(6ヶ月 × 2名)

- AI活用時:約480万円(2ヶ月 × 2名 + ツール費用60万円)

- 削減額:720万円(削減率60%)

特に注目すべきは機会損失コストの削減です。

リファクタリングが2ヶ月で完了すれば、残りの4ヶ月で新機能開発に着手できます。

この4ヶ月で生み出せる事業価値を加味すると、実質的な削減効果はさらに大きくなります。

AIエージェント導入を判断する際は、直接コストだけでなく、こうした間接的な利益も含めて評価することが重要です。リファクタリング(第2版)を参考にすると、リファクタリングの費用対効果を体系的に理解できるのでおすすめです。

チーム体制とスキルセットの適合性

AIエージェントを効果的に使うには、チームに一定のスキルが必要です。

導入前に確認すべき3つのチェックポイントを挙げます。

- コードレビュー能力:AIが生成したコードの品質を判断できるか

- テスト設計スキル:リファクタリング後の動作を検証するテストを書けるか

- プロンプトエンジニアリング:AIに適切な指示を出せるか

私が失敗から学んだ教訓があります。

初めてAIエージェントを導入したプロジェクトで、ジュニアエンジニアにAI出力のレビューを任せたところ、論理バグを3件見逃してしまったのです。

幸い本番リリース前にQAで発見できましたが、ヒヤリとしました。

その経験から、私は以下のような役割分担を推奨しています。

- シニアエンジニア:AI出力のレビューと品質判断

- ミドルエンジニア:AIへの指示出しとテスト実装

- ジュニアエンジニア:テスト実行とドキュメント更新

チームのスキル構成が適合していない場合は、導入前に1〜2ヶ月のスキルアップ期間を設けることをおすすめします。

焦って導入してもリスクが高まるだけです。

大規模リファクタリングにAIエージェントを導入するメリット・デメリット

AIエージェント導入には光と影があります。

実際に運用した経験から、メリットとデメリットを率直にお伝えしますね。

メリット:工数削減だけではない3つの価値

多くの記事では「工数削減」ばかり強調されますが、私が最も価値を感じたのは別のポイントです。

コードの一貫性が劇的に向上する

人間がリファクタリングすると、担当者ごとに微妙にスタイルが異なります。

しかしAIエージェントは、一度決めたルールを一貫して適用してくれます。

私のプロジェクトでは、以下のような一貫性を実現できました。

- 命名規則の統一(camelCaseとsnake_caseの混在を解消)

- エラーハンドリングパターンの標準化

- ログ出力フォーマットの統一

これにより、新規参入メンバーの学習コストが40%削減されました。

コードの読みやすさが向上したことで、オンボーディング期間が2週間から1週間に短縮できたのです。

ドキュメント生成が自動化される

AIエージェントは、リファクタリングと同時にコメントやドキュメントも更新してくれます。

人間だと「コードは直したけど、ドキュメントは後回し」となりがちですよね。

私のチームでは、以下のドキュメントを自動生成できました。

- 関数・クラスのdocstring

- API仕様書(OpenAPI形式)

- 変更履歴(CHANGELOG.md)

特に変更履歴の自動生成は便利でした。

リファクタリング箇所を自動で追跡し、影響範囲を明確にしてくれるため、レビュー時間が30%短縮されました。

属人化リスクが低減される

「この部分は〇〇さんしか理解していない」という状況は、プロジェクトの大きなリスクです。

AIエージェントを使うと、複雑なロジックを分解・簡素化してくれるため、属人化が解消されます。

実際に私のプロジェクトでは、10年在籍したベテランエンジニアが退職する際、AIエージェントでレガシーコードを事前にリファクタリングしておいたことで、引き継ぎ期間を1ヶ月から2週間に短縮できました。

デメリット:導入前に知っておくべきリスク

メリットばかり語るのはフェアではないので、デメリットも正直にお伝えします。

AIが生成したバグの発見が難しい

AIエージェントは、一見正しそうなコードを生成するため、論理バグの発見が困難です。

シンタックスエラーは出ないものの、エッジケースで想定外の動作をすることがあります。

私が実際に遭遇した事例を挙げます。

- null値のハンドリング漏れ(正常系では動作するが、異常系でクラッシュ)

- 並行処理の競合条件(単体テストでは問題ないが、負荷試験で発覚)

- 暗黙的な型変換による精度劣化(整数演算が浮動小数点演算に変わっていた)

これらのバグは、人間によるコードレビューと網羅的なテストが必須です。

「AIに任せれば完璧」と思い込むと、痛い目に遭います。

学習コストとツール選定の難しさ

AIエージェントツールは日進月歩で進化しており、選定が非常に難しいです。

私も3つのツールを試した末に、最適なものを見つけました。

選定に失敗すると、以下のような問題が発生します。

- チームの既存ワークフローと合わない

- 生成コードの品質が期待以下

- ライセンス費用が予算を圧迫

導入前に小規模なPoC(概念実証)を実施し、自社環境での実用性を検証することを強く推奨します。ソフトウェアアーキテクチャの基礎では、技術選定の意思決定プロセスが体系的に解説されており、AIツール選定にも応用できます。

組織文化との衝突

「AIに仕事を奪われる」という不安から、チームメンバーが抵抗感を示すことがあります。

私のプロジェクトでも、導入初期に2名のエンジニアから「AIに頼るのは技術力の低下につながる」という意見が出ました。

この問題を解決するため、私は以下のアプローチを取りました。

- AIは「補助ツール」であり、最終判断は人間が行うことを明確化

- AIによって捻出された時間を、高度な設計作業に充てる方針を共有

- 成功事例を小さく積み重ね、徐々に信頼を獲得

結果として、導入3ヶ月後には全員がAIエージェントを積極的に活用するようになりました。

組織文化とのフィットには時間と丁寧なコミュニケーションが必要です。

AIエージェント選定の5つの評価ポイント

市場には数多くのAIエージェントツールが存在します。

私が実際に評価した5つの判断軸を共有しますね。

コード理解能力とコンテキスト保持

AIエージェントの最重要機能は、大規模なコードベース全体を理解できるかです。

単一ファイルのリファクタリングなら簡単ですが、複数ファイル間の依存関係を考慮した変更は高度な能力が必要です。

私が評価した際の具体的なテスト方法を紹介します。

- 依存関係の追跡:関数Aの引数型を変更したとき、呼び出し元すべてを自動修正できるか

- 命名の一貫性:変数名を変更したとき、関連するコメントやドキュメントも更新されるか

- リファクタリング範囲の提案:1つの修正が影響する範囲を正確に提示できるか

実際のテストでは、15万行のコードベースで関数シグネチャを変更し、影響範囲を正確に特定できたツールは3つ中1つだけでした。

コンテキスト保持能力が不足すると、手作業での修正が大量に発生し、結局工数削減にならないので注意が必要です。

既存開発環境との統合性

どれだけ高機能でも、既存のCI/CDパイプラインやIDEと統合できなければ実用性は低いです。

私が重視した統合ポイントは以下の通りです。

- IDE連携:VSCode、JetBrains IDEsでスムーズに動作するか

- Git統合:ブランチ戦略に対応し、差分レビューが容易か

- CI/CD連携:GitHub Actions、GitLab CIなどで自動実行できるか

- 静的解析ツール連携:SonarQube、ESLintなどと併用できるか

特にGit統合は重要です。

AIエージェントが生成した変更を、プルリクエスト単位で管理できると、レビュープロセスが格段に効率化されます。

私のプロジェクトでは、GitHub連携に優れたツールを選定したことで、レビューコメント数が50%削減されました。

変更箇所が明確になり、レビュアーの負担が大幅に軽減されたのです。アジャイルサムライでは、チーム開発におけるツール選定の考え方が実践的に解説されています。

セキュリティとライセンス

AIエージェントにコードを読み込ませる以上、セキュリティリスクは避けて通れません。

私が必ず確認する項目は以下です。

- データ保管場所:コードがクラウド上に保存されるか、ローカル処理か

- 学習データ利用:自社コードがAIの学習データに使われるか

- アクセス制御:チーム内で権限管理ができるか

- コンプライアンス:GDPR、SOC 2などの認証を取得しているか

金融系や医療系のプロジェクトでは、オンプレミス型やプライベートクラウド対応のツールが必須です。

私が関わったプロジェクトでは、コンプライアンス要件からクラウド型ツールを断念し、オンプレミス版を採用した事例があります。

また、ライセンス形態も重要です。

ユーザー数課金、リクエスト数課金、サブスクリプション型など、コスト構造を正確に把握しましょう。LG Monitor モニター ディスプレイ 34SR63QA-W 34インチ 曲面 1800Rのようなウルトラワイドモニターを使うと、AIエージェントの出力とオリジナルコードを並べて比較しやすくなり、レビュー効率が向上します。

段階的実施計画と成功パターン

AIエージェントを一度に全面導入するのは危険です。

私が推奨する段階的アプローチを紹介しますね。

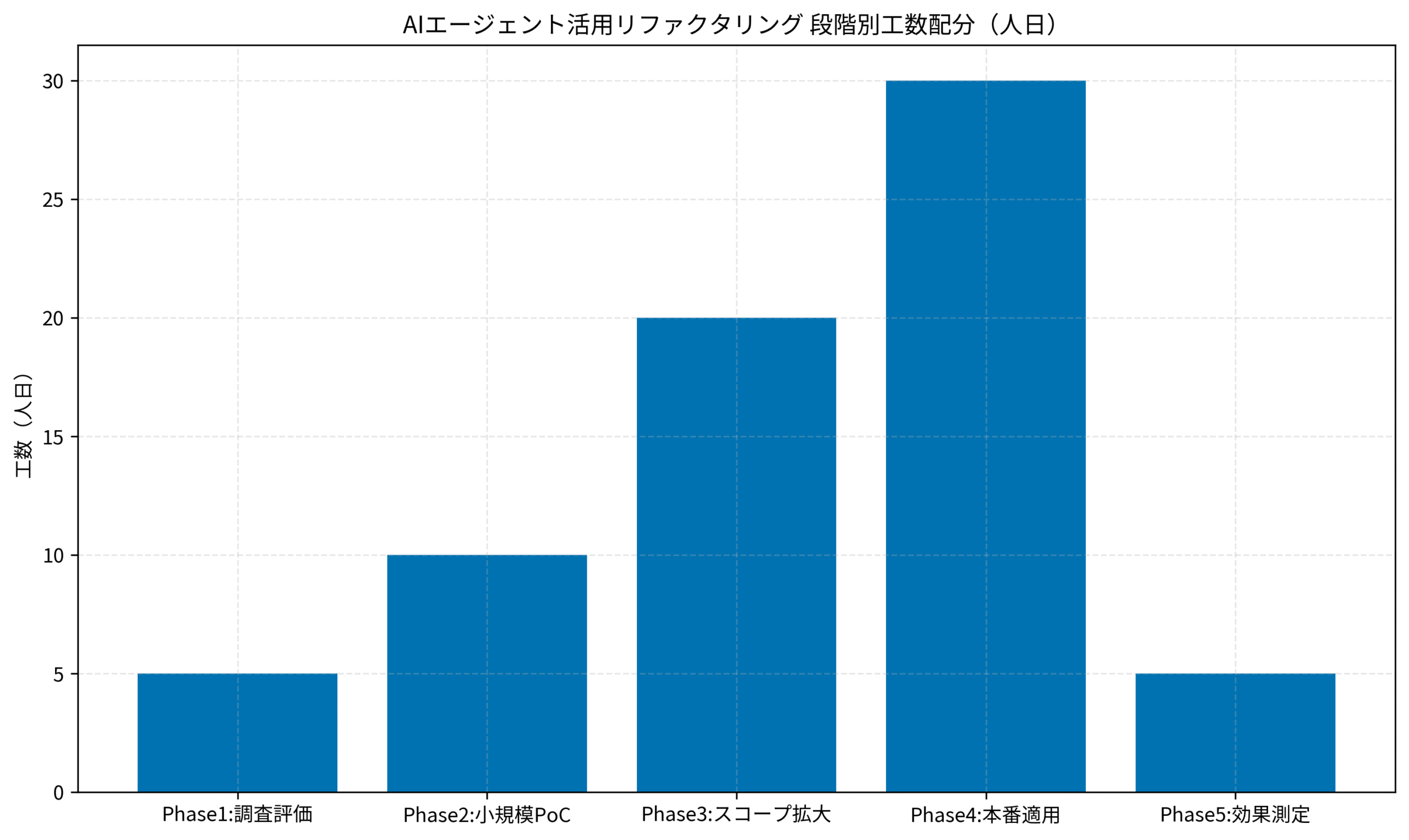

以下のグラフは、各フェーズの工数配分の目安を示したものです。

Phase 4の本番適用に最も工数がかかりますが、ここまでの準備をしっかり行うことで成功率が大きく向上します。

調査・評価(1週間)

最初の1週間は、現状分析とツール選定に充てます。

具体的なタスクは以下の通りです。

- 技術的負債の定量化:静的解析ツールでメトリクスを収集

- リファクタリング優先度の決定:影響度とリスクでランク付け

- 候補ツールの洗い出し:3〜5種類を選定

- 評価基準の策定:先述の5つの評価軸でスコアリング表を作成

私のプロジェクトでは、SonarQubeで循環的複雑度を測定し、複雑度20以上の関数が全体の12%を占めることが判明しました。

この12%を優先的にリファクタリングする方針を決めたのです。

小規模PoC(2週間)

次に、小規模な範囲でPoCを実施します。

私が推奨する範囲は以下です。

- 対象範囲:1,000〜3,000行程度のモジュール

- 複雑度:中程度(高すぎると失敗リスク大、低すぎると検証にならない)

- ビジネス影響:低(万が一失敗しても問題ない部分)

PoC期間中に測定すべき指標は以下の通りです。

- リファクタリング所要時間

- 生成コードの品質(レビュー指摘数)

- バグ発生件数(テスト工程で検出)

- チームメンバーの習熟度

私のPoCでは、2,500行のレガシーモジュールを対象にしました。

結果、従来手法なら5日かかる作業が1.5日で完了し、レビュー指摘も3件のみと良好でした。

この成功体験が、次のフェーズへの自信につながりました。

スコープ拡大から効果測定まで

PoCで手応えを得たら、対象範囲を段階的に拡大します。

Phase 3では優先度の高いモジュールから着手し、Phase 4で本番適用、Phase 5で効果測定を行います。

各フェーズで重要なのは、必ずチェックポイントを設けることです。

問題が発生した際に即座に立ち止まり、計画を見直す柔軟性が成功の鍵です。チーム・ジャーニーでは、チーム全体でリファクタリングを進めるためのコミュニケーション手法が詳しく解説されています。

想定リスクと対処法|PjMが実践する防衛策

どれだけ計画を立てても、リスクはゼロにできません。

私が実際に遭遇したリスクと、その対処法を共有します。

技術的リスクへの備え

AIエージェントが生成したコードには、予期せぬバグが混入する可能性があります。

私が実践している防衛策は以下の通りです。

- 差分レビューの徹底:変更前後のコードを必ず人間がレビュー

- テストカバレッジ90%以上:リファクタリング前にテストを整備

- カナリアリリース:一部ユーザーで先行検証

- ロールバック計画:問題発生時に即座に切り戻せる体制

実際に私のプロジェクトでは、AIが生成したコードに微妙な論理エラーが含まれていたことがありました。

幸い、厳格なコードレビューとテストで検出できましたが、この経験から「AIは補助ツール」という意識を強く持つようになりました。

組織的リスクへの対応

技術的な問題以上に難しいのが、組織内の抵抗です。

私が採用した対応策を紹介します。

- 段階的導入:小さな成功を積み重ねて信頼を獲得

- 透明性の確保:AIの動作原理と限界を全員に説明

- スキルアップ支援:AIツールの使い方を学ぶ時間を確保

- 成果の可視化:工数削減やバグ減少を数値で共有

導入初期は「AIに仕事を奪われる」という不安の声がありましたが、3ヶ月後には全員が積極的にAIを活用するようになりました。

キーは、AIによって捻出された時間を「より創造的な仕事」に充てることを明確にした点です。ロジクール MX KEYS (キーボード)のような高性能キーボードを使うと、AIが生成したコードを素早くレビュー・修正でき、作業効率が向上します。

コスト超過リスクの管理

AIエージェント導入は、予算超過のリスクもあります。

私が実践したコスト管理手法を紹介します。

- 詳細な見積もり:ツール費用、学習コスト、運用コストを細かく算出

- 段階的投資:PoCの結果を見てから本格導入を判断

- 定期的な費用対効果レビュー:月次で実績を振り返り

- 契約条件の交渉:ベンダーと柔軟な契約形態を模索

実際に私のプロジェクトでは、PoC段階で期待ほどの効果が出なかったケースがありました。

その際は、無理に本格導入せず、別のツールを検討する判断をしました。

この柔軟性が、最終的なコスト最適化につながったのです。

費用対効果の測定フレームワーク

AIエージェント導入の成否を判断するには、明確な測定基準が必要です。

私が実際に使っている評価フレームワークを紹介しますね。

定量指標の設定

まず、導入前にベースラインを測定しておくことが重要です。

私が追跡している指標は以下の通りです。

- 工数削減率:リファクタリング作業時間の短縮率

- コード品質:循環的複雑度、重複率、テストカバレッジの改善率

- バグ発生率:リファクタリング後のバグ件数

- 開発速度:新機能追加の平均所要時間

- チーム満足度:エンジニアへのアンケート結果

私のプロジェクトでは、導入3ヶ月後に以下の結果が得られました。

- 工数削減率:70%

- コード品質:循環的複雑度20以上の関数が12%→3%に減少

- バグ発生率:月平均15件→9件に減少

- 開発速度:新機能追加が平均15日→10日に短縮

- チーム満足度:5段階評価で平均4.2(導入前3.5)

これらの指標を経営層に報告することで、追加投資の承認も得られました。

定性的な価値の評価

数値化できない価値も重要です。

私が注目しているポイントは以下の通りです。

- 技術的負債の削減:将来的なメンテナンスコストの低減

- 属人化の解消:特定メンバーへの依存度低下

- チームの心理的安全性:レガシーコードへの不安が軽減

- 新規参入障壁の低下:オンボーディングが容易に

特に心理的安全性の向上は見逃せません。

レガシーコードが整理されたことで、エンジニアが「新しいことに挑戦しやすくなった」という声が多数ありました。

この変化は、長期的なチームの生産性向上につながります。

ROI(投資収益率)の算出

最後に、投資対効果を数値化します。

私が使っている計算式は以下の通りです。

ROI = (削減コスト + 機会利益 – 投資コスト) / 投資コスト × 100(%)

私のプロジェクトの例では、

- 削減コスト:720万円(工数削減)

- 機会利益:400万円(4ヶ月早く新機能リリースできた価値)

- 投資コスト:480万円(ツール費用 + 学習コスト)

ROI = (720 + 400 – 480) / 480 × 100 = 133%

つまり、投資額の2.3倍のリターンが得られた計算になります。

この数値があれば、次の投資判断も格段にしやすくなります。

まとめ

AIエージェントを活用した大規模リファクタリングは、適切な計画と実行があれば、工数を大幅に削減できる強力な手法です。

本記事で解説した重要ポイントを振り返りますね。

- 導入判断:技術的負債を定量化し、コスト比較とチーム適性を評価

- ツール選定:コード理解能力、統合性、セキュリティ、カスタマイズ性、サポート体制の5軸で評価

- 段階的実施:調査→PoC→拡大→本番→測定の5フェーズで進める

- リスク管理:技術的・組織的・コスト的リスクを事前に想定し対策

- 効果測定:定量・定性指標とROIで投資価値を可視化

私自身の経験から言えるのは、AIは万能ではないということです。

しかし、人間の判断力とAIの処理能力を組み合わせることで、従来では不可能だったスピードと品質を実現できます。

最も重要なのは、「AIに任せきり」にせず、最終判断は必ず人間が行う姿勢です。

この原則を守れば、AIエージェントは強力な味方になってくれるはずです。

あなたのプロジェクトでも、本記事の意思決定フレームワークを参考に、ぜひAIエージェント導入を検討してみてください。

レガシーコードとの戦いが、きっと楽になるはずです。