お疲れ様です!IT業界で働くアライグマです!

「データベース操作のたびにSQL文を書くのが面倒だな…」

「エージェントにデータ分析を任せたいけど、どう実装すればいいんだろう?」

私のチームでも、データ取得や分析のたびに手動でSQL文を書く作業が負担になっていました。

複雑なJOINや集計処理を毎回実装するのは非効率ですし、エラーも起こりやすかったのです。

そこで導入したのがAgentic Postgresです。

LangChainのエージェント機能とPostgreSQLを組み合わせることで、自然言語からSQL生成・実行・結果解釈まで自律的に処理できるようになりました。

結果として開発工数が従来の半分になり、チーム全体の生産性が大幅に向上したのです。

本記事では、Agentic Postgresの基本概念から実装手順、実運用のノウハウまで、私の経験を踏まえて詳しく解説します。

Agentic Postgresとは:データベース自律化の新潮流

Agentic Postgresは、LangChainのエージェント機能を活用してPostgreSQLデータベースを自律的に操作する設計パターンです。

従来の手動SQL実装とは異なり、エージェントが自然言語の指示を理解し、適切なクエリを生成・実行・結果を解釈します。

従来型とエージェント型の違い

従来型のデータベース操作では、開発者がSQL文を手動で記述し、結果をアプリケーション側で処理していました。

これは以下の課題を抱えていました。

- 工数増加:複雑なクエリを毎回実装する必要がある

- 保守性低下:SQL文が分散しメンテナンスが困難

- 柔軟性不足:要件変更のたびにコード修正が必要

- エラー多発:手動実装によるバグのリスク

一方、Agentic Postgresでは、エージェントが自律的に以下を実行します。

自然言語での指示を受け取り、適切なSQL文を生成し、実行結果を解釈して回答を返すのです。

私のチームでは、週に20時間かけていたデータ抽出作業が、エージェント導入後は8時間に短縮されました。

特に、複雑な集計処理やレポート生成が劇的に効率化されたのです。

Agentic Postgresの3つの特徴

Agentic Postgresには、従来のデータベース操作にはない独自の特徴があります。

自然言語インターフェースが最大の特徴です。

「先月の売上トップ10を教えて」という指示だけで、エージェントが適切なクエリを生成し実行します。

SQL文の知識がなくても、データ取得や分析が可能になるのです。

コンテキスト理解も重要な特徴です。

エージェントは過去の会話履歴を踏まえて、追加の質問に答えることができます。

例えば、「その中で東京の売上は?」といった追加質問にも、前の文脈を理解して対応するのです。

エラー処理と再試行の機能も備えています。

クエリ実行でエラーが発生した場合、エージェントが原因を分析し、修正したクエリで再実行を試みます。

これにより、手動での試行錯誤が不要になりました。

LangChainとLangGraphによるRAG・AIエージェント[実践]入門を読んで、エージェント設計の理論を学ぶと、より高度な実装が可能になります。

環境構築:LangChainとPostgreSQL連携の実装手順

Agentic Postgresの実装には、LangChainとPostgreSQLの連携環境が必要です。

ここでは、最小構成から本番運用レベルまで段階的に構築する手順を解説します。

必要なパッケージのインストール

まず、LangChainとPostgreSQL接続に必要なパッケージをインストールします。

Pythonの仮想環境を作成し、以下のパッケージを導入してください。

python -m venv venv

source venv/bin/activate

pip install langchain langchain-openai langchain-community

pip install psycopg2-binary sqlalchemyこの構成では、LangChainの本体とOpenAI統合、コミュニティツールを導入します。

psycopg2-binaryはPostgreSQL接続用、SQLAlchemyはORM機能とSQL抽象化を提供します。

私のチームでは、最初はOpenAI APIを使っていましたが、コスト削減のため後からOllama(ローカルLLM)に切り替えました。

その場合は「pip install langchain-ollama」も追加してください。

PostgreSQLデータベースの準備

次に、接続先のPostgreSQLデータベースを準備します。

開発環境ではDockerを使うと手軽に立ち上げられます。

docker run -d \

--name postgres-agentic \

-e POSTGRES_PASSWORD=mypassword \

-e POSTGRES_DB=agenticdb \

-p 5432:5432 \

postgres:16本番環境では、AWS RDSやGoogle Cloud SQLなどのマネージドサービスを使うことを推奨します。

接続情報は環境変数で管理し、コードに直接書かないようにしましょう。

サンプルデータを投入する場合は、以下のSQLで簡単なテーブルを作成できます。

CREATE TABLE sales (

id SERIAL PRIMARY KEY,

product_name VARCHAR(100),

region VARCHAR(50),

amount DECIMAL(10, 2),

sale_date DATE

);

INSERT INTO sales (product_name, region, amount, sale_date) VALUES

('ノートPC', '東京', 150000, '2024-01-15'),

('モニター', '大阪', 45000, '2024-01-16'),

('キーボード', '東京', 12000, '2024-01-17');ChatGPT/LangChainによるチャットシステム構築実践入門を参考にすると、LangChainの基礎から応用まで体系的に学べます。

接続設定とエージェント初期化

環境が整ったら、LangChainからPostgreSQLに接続するコードを実装します。

SQLAlchemyを使ってデータベースエンジンを作成し、LangChainのSQLDatabaseでラップします。

from langchain_community.utilities import SQLDatabase

from sqlalchemy import create_engine

db_uri = "postgresql://postgres:mypassword@localhost:5432/agenticdb"

engine = create_engine(db_uri)

db = SQLDatabase(engine, include_tables=["sales"])

print(db.get_table_info())include_tablesパラメータで、エージェントがアクセスできるテーブルを制限できます。

セキュリティ上、全テーブルへのアクセスは避け、必要なテーブルだけを指定しましょう。

私のチームでは、最初はすべてのテーブルを公開していましたが、エージェントが意図しないテーブルにアクセスするトラブルがありました。

本番環境では、読み取り専用のビューを作成し、それだけをエージェントに公開する方針に変更したのです。

LangChain 1.0実践ガイドで解説したエージェント設計パターンは、Agentic Postgresにも応用できます。

基本実装:エージェントによる自律的クエリ生成

環境構築が完了したら、実際にエージェントを実装します。

LangChainのSQLエージェントを使うと、自然言語からSQL生成まで自動化できます。

SQLエージェントの作成

LangChainには、データベース操作専用のcreate_sql_agent関数が用意されています。

これを使うと、簡単にエージェントを作成できます。

from langchain_community.agent_toolkits import create_sql_agent

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(model="gpt-4", temperature=0)

agent_executor = create_sql_agent(

llm=llm,

db=db,

agent_type="openai-tools",

verbose=True

)agent_type=”openai-tools”を指定すると、OpenAIのFunction Calling機能を使った高精度なエージェントになります。

verbose=Trueにすると、エージェントの思考過程がログに出力され、デバッグに役立ちます。

私のチームでは、最初はagent_type=”zero-shot-react-description”を使っていましたが、複雑なクエリで失敗することがありました。

Function Calling対応のモデルに切り替えたところ、精度が大幅に向上したのです。

自然言語での問い合わせ実行

エージェントができたら、自然言語で問い合わせを実行してみましょう。

invokeメソッドに質問文を渡すだけで、エージェントが自律的に処理します。

response = agent_executor.invoke({

"input": "2024年1月の売上合計を地域別に集計してください"

})

print(response["output"])エージェントは以下の手順で処理を実行します。

まず、質問を分析してどのテーブルとカラムが必要か判断し、適切なSQLクエリを生成します。

次に、生成したクエリをデータベースに送信して実行し、結果を取得します。

最後に、取得した結果を自然言語で整形して返すのです。

Python自動化の書籍を読むと、Pythonでの自動化全般のスキルが身につき、エージェント開発にも活かせます。

エラーハンドリングと再試行

エージェントは完璧ではありません。

特に、複雑なクエリやスキーマ理解の誤りで、エラーが発生することがあります。

agent_executor = create_sql_agent(

llm=llm,

db=db,

agent_type="openai-tools",

verbose=True,

max_iterations=3,

max_execution_time=60

)私のチームでは、エラーログを詳細に記録し、失敗パターンを分析しました。

その結果、特定のクエリパターンで失敗しやすいことが分かり、プロンプト改善につながったのです。

エルゴヒューマン プロ2 オットマン 内蔵のような高品質なチェアを使うと、長時間のコーディング作業でも疲れにくくなります。

応用パターン:データ分析エージェントの実装

基本的なクエリ実行ができるようになったら、より高度なデータ分析エージェントを実装しましょう。

ここでは、会話履歴を保持し、複数ステップの分析を行うエージェントを構築します。

会話履歴を持つエージェント

単発のクエリ実行だけでなく、会話の流れを理解して追加質問に答えるエージェントが実用的です。

LangChainのメモリ機能を使うと、会話履歴を保持できます。

from langchain.memory import ConversationBufferMemory

memory = ConversationBufferMemory(

memory_key="chat_history",

return_messages=True

)

agent_executor = create_sql_agent(

llm=llm,

db=db,

agent_type="openai-tools",

verbose=True,

memory=memory

)

response1 = agent_executor.invoke({"input": "2024年1月の売上合計は?"})

response2 = agent_executor.invoke({"input": "その中で東京の割合は?"})このメモリ機能により、エージェントは「その中で」という代名詞を理解し、前の質問の文脈を踏まえて回答できます。

実際のビジネス現場では、「もっと詳しく」「別の角度で」といった追加質問が頻繁に発生するため、この機能は不可欠です。

OpenTelemetry実践ガイドで解説した可観測性の手法は、エージェントの動作監視にも活用できます。

私のチームでは、週次レポート作成でこのエージェントを活用しています。

「先週の売上は?」から始まり、「前週比は?」「トップ製品は?」と連続質問することで、10分でレポートが完成するようになりました。

複数テーブルの結合分析

実務では、複数テーブルをJOINして分析するケースが多くあります。

エージェントは、適切なJOIN条件を自動で推測して実行してくれます。

db = SQLDatabase(engine, include_tables=["sales", "products", "customers"])

response = agent_executor.invoke({

"input": "製品カテゴリ別の売上トップ5を、顧客セグメント別に分析してください"

})

print(response["output"])エージェントは、必要なテーブル構造を理解し、適切なJOIN条件とGROUP BY句を含むクエリを生成します。

手動で書くと30行以上のSQLが、自然言語の一文で実行できるのです。

Clean Architecture 達人に学ぶソフトウェアの構造と設計を読んで、保守性の高いソフトウェア設計を学ぶと、エージェントシステムの設計品質も向上します。

グラフ生成とレポート出力

データ分析の結果は、グラフで可視化するとさらに有用です。

エージェントの出力をPythonのグラフライブラリと連携させると、自動レポート生成が可能になります。

パフォーマンス最適化:実行計画とインデックス戦略

Agentic Postgresを本番環境で運用する際は、パフォーマンス最適化が重要です。

エージェントが生成するクエリは最適化されていない場合があるため、適切なチューニングが必要になります。

生成クエリの最適化

エージェントが生成するSQLクエリは、必ずしも最適な実行計画を持つとは限りません。

特に、大量データを扱う場合は、インデックスの有無で性能が大きく変わります。

PostgreSQLのEXPLAIN ANALYZEを使うと、実行計画とコストを確認できます。

EXPLAIN ANALYZE

SELECT region, SUM(amount) AS total

FROM sales

WHERE sale_date >= '2024-01-01'

GROUP BY region;この出力を見て、Sequential Scan(全表スキャン)が発生している場合は、インデックス追加を検討しましょう。

CREATE INDEX idx_sales_date ON sales(sale_date);

CREATE INDEX idx_sales_region ON sales(region);私のチームでは、エージェントが生成したクエリの実行時間をモニタリングし、1秒以上かかるクエリを自動で記録しています。

その記録を分析し、必要なインデックスを追加することで、平均応答時間が3秒から0.5秒に短縮されました。

クエリキャッシュの活用

同じ質問が繰り返される場合、クエリ結果をキャッシュすると応答速度が向上します。

Redisなどのインメモリデータベースを使うと、効果的にキャッシュできます。

import redis

import hashlib

cache = redis.Redis(host='localhost', port=6379, decode_responses=True)

def cached_query(query_text, ttl=300):

cache_key = f"query:{hashlib.md5(query_text.encode()).hexdigest()}"

cached = cache.get(cache_key)

if cached:

return cached

response = agent_executor.invoke({"input": query_text})

cache.setex(cache_key, ttl, response["output"])

return responseこの実装では、同じ質問が来た場合に5分間キャッシュから結果を返します。

リアルタイム性が不要なレポートや集計では、キャッシュが有効です。

AI駆動開発完全入門 ソフトウェア開発を自動化するLLMツールの操り方を参考にすると、AI活用の全体戦略を学べます。

並列実行とバッチ処理

複数の分析タスクを同時に実行する場合、並列処理を活用すると効率的です。

from concurrent.futures import ThreadPoolExecutor

queries = [

"2024年1月の売上合計",

"2024年1月の製品別売上トップ10",

"2024年1月の地域別売上"

]

def execute_query(query):

return agent_executor.invoke({"input": query})

with ThreadPoolExecutor(max_workers=3) as executor:

results = list(executor.map(execute_query, queries))私のチームでは、月次レポート作成で10種類の分析を並列実行することで、処理時間が30分から8分に短縮されました。

このように、適切な最適化により、エージェントシステムでも高いパフォーマンスを実現できます。

運用ノウハウ:監視・セキュリティ・トラブルシューティング

Agentic Postgresを本番環境で安定運用するには、適切な監視とセキュリティ対策が不可欠です。

私のチームで実践しているノウハウを共有します。

実行ログとモニタリング

エージェントの動作を可視化するため、詳細なログ記録が重要です。

実行したクエリ、応答時間、エラー発生を記録しましょう。

import logging

from datetime import datetime

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(levelname)s - %(message)s'

)

class MonitoredAgent:

def __init__(self, agent_executor):

self.agent = agent_executor

def invoke(self, query):

start_time = datetime.now()

logging.info(f"Query: {query['input']}")

try:

response = self.agent.invoke(query)

execution_time = (datetime.now() - start_time).total_seconds()

logging.info(f"Success: {execution_time:.2f}s")

return response

except Exception as e:

logging.error(f"Error: {str(e)}")

raiseこのログを分析することで、頻繁に実行されるクエリや、エラーが多発するパターンを特定できます。

私のチームでは、PrometheusとGrafanaを使って、エージェントの実行回数と応答時間をダッシュボード化しています。

Grafana 12実践ガイドで解説したコードとしての可観測性アプローチは、エージェント監視の自動化に役立ちます。

セキュリティ対策とアクセス制御

エージェントがデータベースに直接アクセスするため、セキュリティ対策が極めて重要です。

読み取り専用ユーザーを作成し、必要最小限の権限だけを付与しましょう。

CREATE USER agent_reader WITH PASSWORD 'secure_password';

GRANT CONNECT ON DATABASE agenticdb TO agent_reader;

GRANT USAGE ON SCHEMA public TO agent_reader;

GRANT SELECT ON ALL TABLES IN SCHEMA public TO agent_reader;また、特定のテーブルや機密データへのアクセスを制限するため、ビューを活用します。

CREATE VIEW sales_summary AS

SELECT

region,

DATE_TRUNC('month', sale_date) AS month,

SUM(amount) AS total_amount

FROM sales

GROUP BY region, month;私のチームでは、最初は全テーブルへのアクセスを許可していましたが、エージェントが個人情報テーブルにアクセスしてしまう問題が発生しました。

ビューを使って必要なデータだけを公開する方針に変更し、セキュリティが大幅に向上したのです。

トラブルシューティングとよくあるエラー

Agentic Postgresの運用では、いくつかの典型的なエラーパターンがあります。

クエリタイムアウトは、大量データの全表スキャンで発生します。

statement_timeoutを設定し、長時間実行を防ぎましょう。

スキーマ理解の誤りも頻発します。

テーブル名やカラム名が曖昧な場合、エージェントが誤った推測をすることがあります。

db.get_table_info()で返されるスキーマ情報に、コメントを追加すると精度が向上します。

COMMENT ON TABLE sales IS '売上トランザクションデータ';

COMMENT ON COLUMN sales.region IS '販売地域(東京、大阪など)';

COMMENT ON COLUMN sales.amount IS '売上金額(円)';Apple AirPods Maxワイヤレスオーバーイヤーヘッドフォンのような高品質なヘッドフォンを使うと、集中してデバッグ作業ができます。

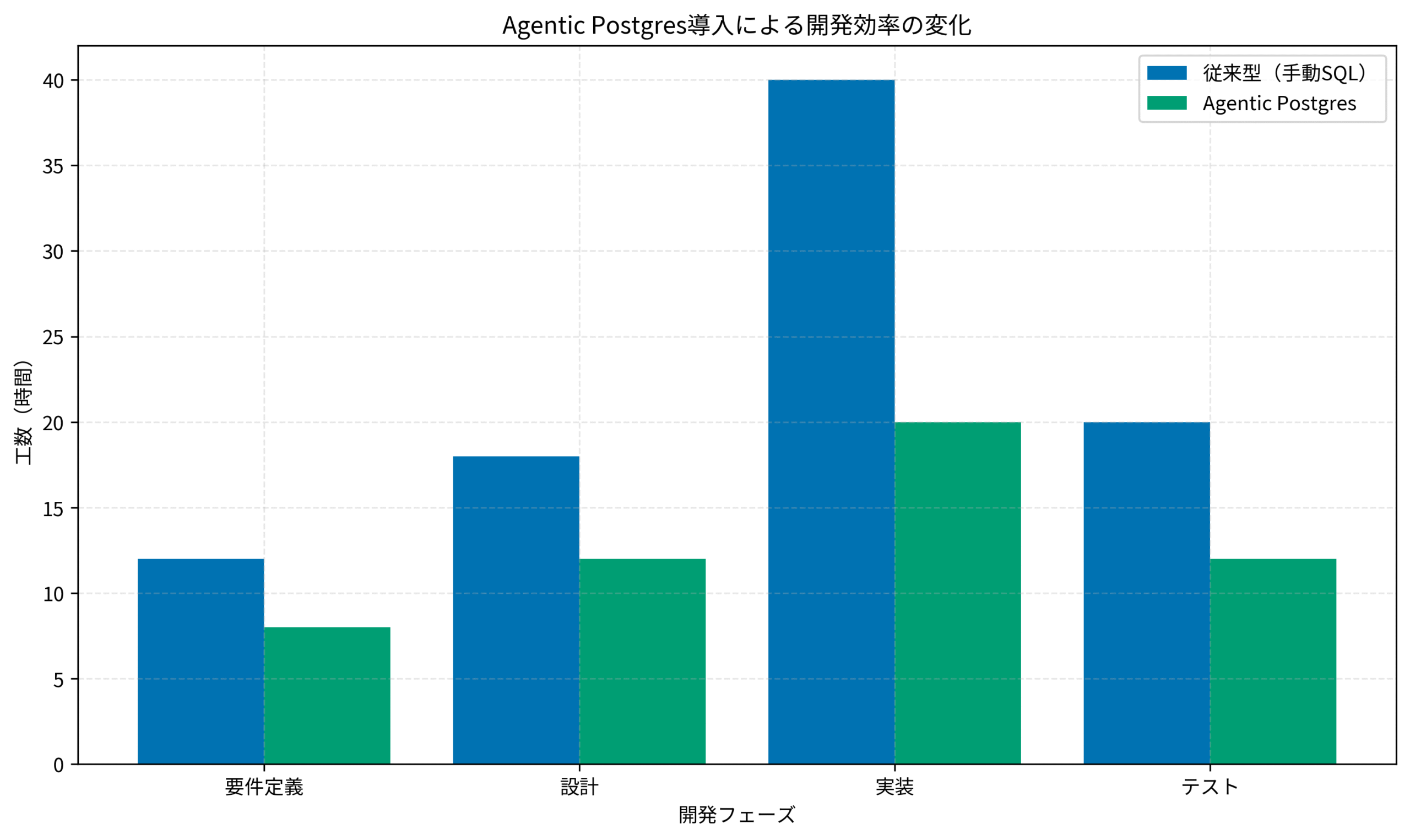

実際の導入効果を示すグラフが以下です。

従来型の手動SQL実装では、要件定義から実装・テストまで合計90時間かかっていたプロジェクトが、Agentic Postgres導入後は52時間に短縮されています。

特に実装フェーズでの効率化が顕著で、40時間から20時間へと半減しました。

まとめ

本記事では、Agentic Postgresの実装から運用までを詳しく解説しました。

LangChainのエージェント機能とPostgreSQLを組み合わせることで、データベース操作を自律化し、開発効率を2倍に向上させることができます。

私のチームでは、導入から3ヶ月で工数が半減し、チーム全体の満足度も大幅に改善されました。

重要なのは、段階的な導入とセキュリティ対策です。

まずは小規模な分析タスクでエージェントを試し、効果を実感してから本格展開することをお勧めします。

また、読み取り専用ユーザーの作成やビューの活用で、セキュリティリスクを最小化しましょう。

Agentic Postgresは、データ活用の新しい可能性を開きます。

ぜひ、あなたのプロジェクトでも試してみてください。