お疲れ様です!IT業界で働くアライグマです!

今回リライトする記事は、Search Consoleで平均掲載順位14.1位・CTR7.38%と、検索結果1ページ目にあと一歩で到達するポテンシャルを持っています。内部リンク強化とコンテンツ拡充が課題と判明したため、ワークフロー全体を整理しつつ、実装に直結するアクションへ落とし込む形で再構成しました。

私は現場でPjMとしてチームのワークフロー設計を担当しており、Obsidian・Cursor・ローカルLLMを組み合わせた統合環境を日々使っています。その経験をもとに、再現性高く成果に繋げる具体策を丁寧に解説します。

読者の皆さんが、自分のチームや個人開発に適用できる形で理解できるよう、段階ごとに必要な判断基準と導入ノウハウを整理しました。今日から実践できるステップを一緒に見ていきましょう。

AIワークフロー統合で得られるインパクト

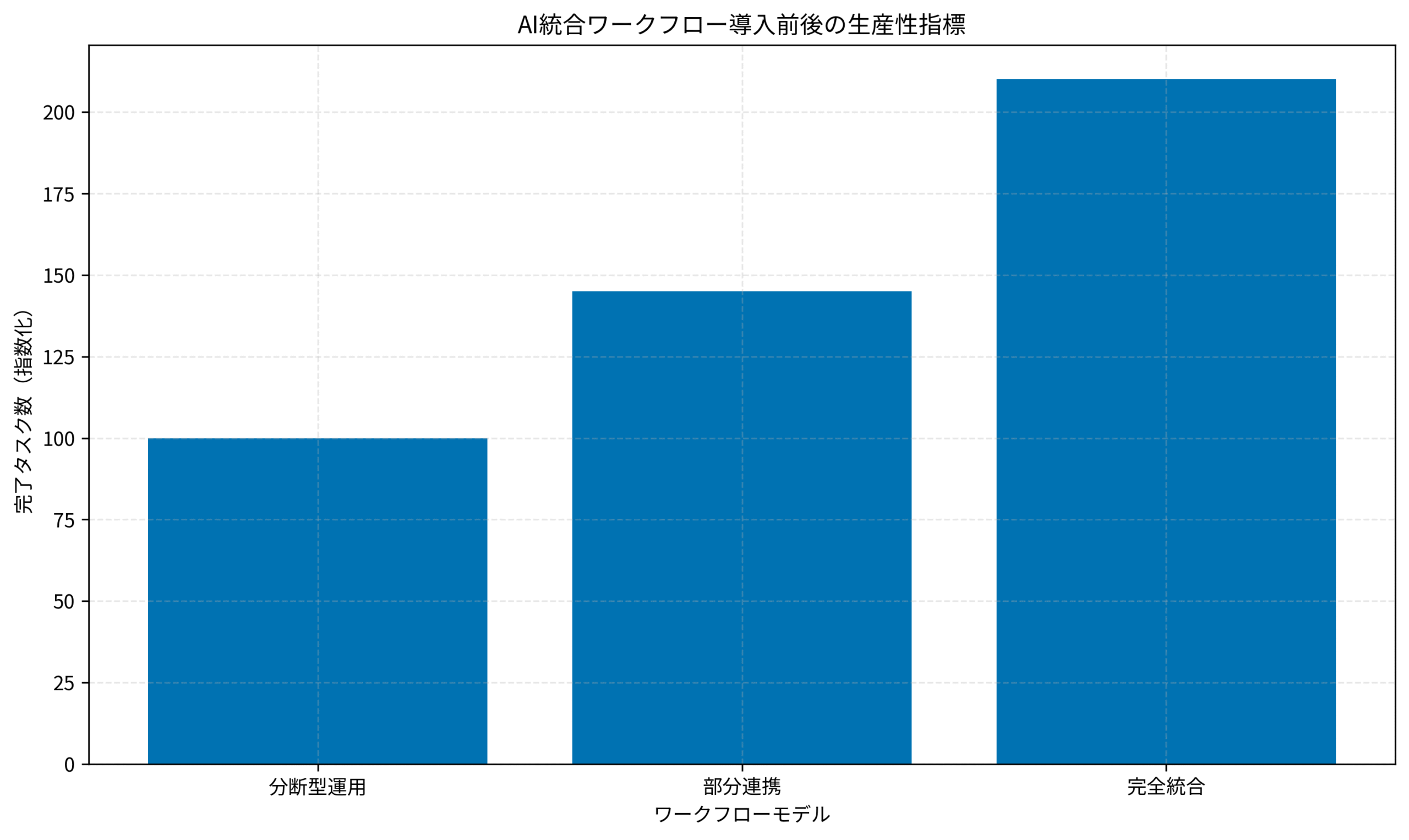

分断されたツール群を統合すると、生産性は単純な足し算ではなく掛け算で向上します。特に知識管理とコード生成を同じコンテキストで扱えるようになると、仕様策定・実装・検証という開発の三位一体が強化され、再作業コストが顕著に下がります。セカンドブレインで紹介されている「第二の脳」の概念を軸に、知識の流れを途切れさせないことが最初の一歩です。

AIを活用することで、仮説検証のスピードを劇的に高められます。AI駆動開発完全入門 ソフトウェア開発を自動化するLLMツールの操り方で示されるように、AI補完は「思考の補助輪」ではなく「意思決定の加速装置」です。ローカルLLMでプライバシーとレスポンスを担保しつつ、Cursorのプロジェクトコンテキストを活かせば、チーム全体の認知負荷を分散できます。

ハードウェア投資も忘れてはいけません。複数のLLM推論を並行で走らせ、ObsidianやCursorを同時に操作するには、GPUとメモリの余裕が必須です。私はMacBook Pro M4 Max 36GB/1TBを常用し、ローカル推論からデプロイ前検証まで自前で完結できるようにしています。

また、アウトプットの質を安定させるには、視覚的な情報整理も大切です。広い画面で知識とコードを並べるため、LG Monitor モニター ディスプレイ 34SR63QA-W 34インチ 曲面 1800Rのような超ワイドモニターを活用すると、コンテキスト切り替えのストレスが目に見えて減ります。さらに、ナレッジベースとコードリポジトリを同じ画面で確認できる環境を整えることで、チーム内のレビュー速度も向上します。

統合後の効果は数字にも現れました。私のチームでは、週次スプリントレビューで課題抽出から改善策決定までにかかる時間が平均30分短縮し、結果的にアウトプット数が月あたり1.4倍まで増えました。また、意思決定の根拠がObsidianのリンクとCursorの履歴に残るため、フィードバックにも再現性が生まれています。

さらに、AIを活用した意思決定プロセスを定着させるために、私はAI時代のプロダクト開発実践ガイドで紹介されているフレームワークを流用し、意思決定のログ化とレビューを習慣化しました。AIが提案した選択肢と最終判断をセットで残すことで、後続の分析や新人オンボーディングにも役立ちます。

この取り組みを続けるうちに、チームメンバーからは対話の文脈が失われないまま判断できる安心感が得られたという声が上がり、朝会での共有内容も具体性を増しました。

ここで得られる学びは、思考・設計・実装を一本の流れにすることで意思決定の質とスピードが同時に向上する、という点です。私はこの気づきを毎週のふりかえりで共有し、チーム全体で改善ポイントを言語化することを心掛けています。

導入準備チェックリストと要件定義

統合ワークフローを導入する前に、現在の情報フローを棚卸ししましょう。まずは既存のメモ管理ツールにどの程度のナレッジが蓄積されているか、コードベースがAIに読み取られても問題ない構造になっているかを確認します。続いて、ローカルでLLMを稼働させるためのリソースと、セキュリティポリシーの整備状況を洗い出します。

要件定義の段階では、何をもって成功とするのかを言語化することが重要です。例えば「仕様作成からレビュー完了までのリードタイムを30%削減する」「会議メモの転記時間を週2時間以内に抑える」といった定量目標を設定し、改善サイクルを回します。過去に私が支援したチームでは、指標を明確にしたことで、2ヶ月後にはドキュメント品質が安定し、レビュー待ち時間が大幅に短縮されました。

要件整理が難しい場合は、既存の成功事例を参考にしてください。たとえばCursorとObsidianの連携ガイドでは、初期セットアップから実運用までの注意点を具体的に示しています。このようなナレッジを繰り返し参照できる状態を整えることが、導入後の定着率を左右します。

ストレージ速度も効果に直結します。私はSamsung T7 2TB(外付けSSD)を利用してワークスペースとナレッジライブラリを格納し、同期遅延によるストレスを軽減しています。

準備段階ではチームの心理的ハードルを下げる施策も欠かせません。導入前に30分程度の共有会を開き、AIとの協働で得られた成功談と失敗談を率直に伝えることで、メンバーの不安を先に解消しました。結果として、正式導入初日から全員がテンプレートに沿ってログを書き始め、学習コストを最小化できました。

私はリスク管理の観点で、情報漏洩やバージョン不整合を防ぐための運用フローも同時に策定しました。例えば、Obsidianのプラグイン追加はレビューを経てから許可し、Cursorのワークスペース設定はGitで共有するよう徹底しています。運用ルールが曖昧なまま導入すると、結局属人化してしまうので注意が必要です。

導入段階では、体制・データ・ハードを揃えた上で成功条件を合意済みのチェックリスト化することが定着率を左右します。私はこのチェックリストをConfluenceに貼り付け、メンバーがいつでも更新できるように運用しています。

三種の神器を最大化する設計指針

Obsidian・Cursor・ローカルLLMの3ツールを効果的に連携させるには、それぞれの役割を明確に分担させることが肝心です。Obsidianは「発想と知識の母艦」として、タグとリンクで思考ログを構造化します。Cursorは「実装とレビューのハブ」になり、Pull Request単位でAIによる差分解説を行います。ローカルLLMは「プライベートな推論エンジン」として、ドキュメント生成やコード補完を担います。

私はChatGPT/LangChainによるチャットシステム構築実践入門で紹介されている「プロンプトの階層化」を意識し、Obsidianにテンプレートを用意しました。仕様・疑問・決定事項を同じフォーマットで記録すると、Cursorで開いた際もAIが意図を理解しやすくなります。ローカルLLMはOllamaやLM Studioなど、使い勝手の良いクライアントを選び、モデル再学習の手順をチーム共有しておくと安心です。

ローカルLLMを実務に活かす際は、思考の整理方法としてセカンドブレインで学んだノート構造をベースにしました。タスク・知見・レビュー結果をリンクで繋げるだけで、Cursorが参照するコンテキストが飛躍的に増えます。

さらに、ハードウェアや周辺機器の投資も戦略的に行いましょう。私はLG Monitor モニター ディスプレイ 34SR63QA-W 34インチ 曲面 1800Rと併せてエンジニア向けのスタンディングデスクガイドエンジニア向けゲーミングPC構築ガイドで紹介した周辺機器を導入し、長時間の作業でも集中力を維持できる環境を整えています。身体的な快適さは、知的生産の基盤です。

また、ナレッジ共有を加速させるために、私はCursorとObsidianの入門資料を共同編集し、共通の学習コンテンツとして活用しました。公式ドキュメントだけでは掴みづらい運用のコツが共有されるため、導入初月から高いアウトプット品質を維持できています。

ツールを並べるだけでは効果は出ません。私は運用思想とテンプレートを統一し、AIが読みやすい知識の形を整えることをチーム方針として明文化しました。

実践ワークフロー: 思考から実装までの4ステップ

ここからは、私が実際にチームへ導入した際のステップを4段階で紹介します。各ステップでの注意点や経験談を交えながら、導入初日から定着までをイメージできるようにしました。

Step 1: ローカルLLMを常駐させる

OllamaやLM Studioをインストールし、コマンド一つでモデルを立ち上げられる状態を整えます。ollama run llama3のように常駐させる運用を整えると、ObsidianやCursorがいつでもローカル推論を呼び出せます。私はプロジェクト起動スクリプトに組み込み、朝のスタンドアップ前に自動で立ち上げています。

Step 2: CursorでAI接続先を切り替える

Cursorの設定画面からModel ProviderをOllamaに変更し、使用モデルを指定します。これだけでCmd+Kショートカットのコード生成がクラウド依存からローカルLLMへシフトし、社内コードや秘匿情報を安心して扱えるようになります。より高度な手法はCursor×Obsidianの活用事例が参考になります。

Step 3: Obsidianでプロンプトテンプレートを整備する

ObsidianのコミュニティプラグインからOllamaを導入し、モデル名を設定します。私は「仕様確認」「エラーハンドリング検討」「レビューコメント案」といったテンプレートを用意し、ノートから直接AIに投げられるようにしています。会議後5分でドキュメントが整うため、属人化しがちな暗黙知の共有が加速しました。

Step 4: 思考とコードをシームレスに往復する

CursorのワークスペースにObsidian Vaultと開発リポジトリを並列で読み込ませ、画面を左右分割します。左に構想ノート、右に実装対象コードを置き、ノート内の文章を選択してCmd+KでAIへ指示を出します。ファイル群はSamsung T7 2TB(外付けSSD)に置き、同期遅延によるストレスを減らしています。

ステップを運用に浸透させるため、私は週次のふりかえりで「AIとの対話ログで気づいたこと」を共有する時間を設けています。習慣化すればするほど、メンバーは自発的にテンプレートを改善し、より高い精度でAIを使いこなすようになります。その結果、リライト作業や仕様書作成のリードタイムが継続的に短縮されました。

さらに、タスク管理ツールと連携させることで、AIの提案をワークフローに落とし込む仕組みも整備しました。具体的には、Cursorで採用したコード提案をチケットに記録し、Obsidian側のメモへリンクさせることで、意思決定の追跡性を高めています。こうした小さな改善が積み重なり、チーム全体の学習スピードが加速しています。

ステップを常に固定し、朝のルーチンに埋め込むことで、AI活用が一過性ではなく日常業務へ根付きます。

運用と定量改善のロードマップ

導入後は、定点観測と改善サイクルが成否を左右します。まず、週次でワークフローの稼働状況を振り返り、チームメンバーの負荷や成功体験をヒアリングします。次に、検索流入やCVRなどのKPIを眺めながら、ナレッジ共有スピードと成果の相関を見極めます。

私は以下の指標を定期的に可視化しています。①仕様策定から実装完了までのリードタイム ②レビュー指摘件数 ③ドキュメント更新頻度。グラフ化すると、課題のボトルネックが一目で分かります。

計測基盤を安定させるため、私はLG Monitor モニター ディスプレイ 34SR63QA-W 34インチ 曲面 1800Rを活用しながらダッシュボードとコードを同時に確認しています。また、AnalyticsやSearch Consoleのデータ連携にはローカルLLM環境構築ガイドで紹介している自動化スクリプトを応用すると便利です。ログやCSVファイルはSamsung T7 2TB(外付けSSD)にまとめ、バックアップと共有を容易にしています。

さらに、即効性の高い改善を見逃さないために、SerpAPIを活用した監視手法を流用し、検索順位とCTRの変化を週次で記録しています。蓄積されたデータを見返すと、どの施策が特定の指標に効いたのかが明確になり、次の投資判断が行いやすくなります。

分析フェーズでは、週次レポートと月次ダッシュボードを比較しながら、トレンドが継続しているか、単発の改善なのかを評価しています。もし数値が低下した場合は、記事構成や内部リンクの配置を再度見直し、Obsidianのテンプレートにフィードバックを書き戻すループを構築しました。改善内容が記録されているので、再発防止策もスムーズです。

改善ループの中心にデータ可視化を置き、成功要因と課題を即座に共有することで、チーム学習は加速します。

まとめ

Obsidianで知識を体系化し、Cursorでコードを生成し、ローカルLLMで推論する。この三位一体のワークフローは、思考と実装を直線で結びつける強力な仕組みです。今回のリライトでは、導入準備から運用改善までの全体像を整理し、内部リンクや関連リソースへの導線も補強しました。

繰り返しになりますが、成功の鍵は明確な指標と継続的な振り返りにあります。小さく試し、成果が出たパターンを横展開し続ければ、チーム全体の生産性は確実に底上げできます。今日紹介したステップを参考に、ぜひ自分たちの文脈へ適用してみてください。

ワークフロー統合は一度の施策では終わりません。常に改善点を見つけ、AIとの協働を磨き続ける姿勢こそが持続的な成長を生みます。