お疲れ様です!IT業界で働くアライグマです!

「革新的なAIコーディングアシスタント」「人間のエンジニアを超える精度」——そんな華々しい謳い文句で登場したAIスタートアップが、実は裏で人間が手作業でコードを書いていた…。これは悪夢のような作り話ではなく、実際に起こった衝撃的な事件です。

この事件は、AI技術に対する信頼を根底から揺るがすとともに、X(旧Twitter)を中心に大きな議論を巻き起こしました。「AIとは何だったのか」「完全に騙された」といった怒りと戸惑いの声が溢れ、AI業界全体の信頼性が問われる事態となっています。

私自身、PjMとして複数のAI導入プロジェクトに携わってきましたが、この事件は「技術の透明性」と「検証の重要性」という、私たちが見落としがちだった課題を浮き彫りにしました。この記事では、この衝撃的な事件の全容と、そこから学ぶべき教訓、そしてIT業界全体が今後どうAI技術と向き合うべきかを、PjM視点で深掘りしていきます。

衝撃の事実:AIの仮面を被った「人力コーディングサービス」

破産したこのスタートアップは、「最先端の機械学習モデルを用いたAIコーディングアシスタント」として市場に登場しました。デモでは驚異的な速度でコードを生成し、投資家やメディアから高い評価を受けていました。しかし、破産手続きの過程で明らかになった事実は、多くの関係者を愕然とさせるものでした。

破産したAI企業の「画期的AI」の正体

この企業が提供していた「AIコーディングサービス」は、実際には海外の安価な人材を雇い、彼らが手作業でコードを書いていたことが判明しました。ユーザーがAIに指示を出すと、その内容は瞬時に人間のコーダーに転送され、彼らが急いでコードを書いて返答する——そんな仕組みだったのです。

表面上は「AI」として振る舞うため、意図的に数秒の遅延を設けたり、時折わざと「学習中です」といったメッセージを表示したりする工夫まで施されていました。技術的な裏付けが一切ない「AIウォッシング」の極致とも言える手法です。

私がPjMとして関わったプロジェクトでも、ベンダーが提示するAI技術の詳細を確認したところ、実は単純なルールベースシステムだったという経験があります。しかし、今回のケースはそれをはるかに超える悪質性がありました。AI駆動開発完全入門 ソフトウェア開発を自動化するLLMツールの操り方

なぜこのような事態に?背景にあるプレッシャーと倫理観の欠如

この企業がなぜこのような偽装を行ったのか。背景には、AI業界特有の激しい競争とプレッシャーがありました。投資家からの期待、市場での生き残り、競合他社との差別化——これらの圧力が、経営陣を「嘘」へと駆り立てたと考えられます。

しかし、どれほどプレッシャーがあろうとも、顧客を欺く行為は決して許されるものではありません。技術的な限界や開発の遅れを正直に伝えることこそが、長期的な信頼関係を築く唯一の道です。短期的な成功を追い求めるあまり、根本的な倫理観を失ってしまった典型的な例と言えるでしょう。

X(旧Twitter)騒然:「AIとは何だったのか」「騙された」怒りと戸惑いの声

この事実が明らかになると、X上では瞬く間に拡散され、大きな議論が巻き起こりました。「AIを信じていたのに裏切られた」「結局、人間がやってたのか」といった怒りの声や、「他のAI企業も同じことをしているのでは?」という疑念の声が溢れました。

特に印象的だったのは、エンジニアコミュニティからの「やはり検証が必要だ」という冷静な分析と、一般ユーザーからの「もうAIを信じられない」という感情的な反応の対比でした。この温度差は、AI技術への理解度の違いを如実に示していると感じました。

AIの信頼性への大打撃:失われた信用を取り戻せるか

この事件は、AI業界全体に対する信頼を大きく損ねました。真面目に技術開発を進めている企業にとっても、風評被害は避けられません。信頼の回復には、業界全体での透明性向上と検証体制の強化が不可欠です。

「AIが書いたコード」への疑念と検証の重要性

この事件以降、「本当にAIが生成したコードなのか?」という疑念が広がっています。私が携わるプロジェクトでも、クライアントから「このAIツールは本物ですか?」という質問を受けるようになりました。

PjMとして重要なのは、AI導入時に技術的な裏付けを徹底的に検証することです。デモだけを見て判断するのではなく、モデルのアーキテクチャ、学習データ、推論プロセスなど、可能な限り技術的詳細を確認する必要があります。また、実際の動作をブラックボックステストだけでなく、内部動作も含めて検証することが求められます。

コードレビューの重要性についても再認識が必要です。AIが生成したコードであっても、必ず人間がレビューし、意図通りに動作するか、セキュリティリスクはないかを確認するプロセスが不可欠です。SOLID CODE 高品質なコードを生み出す実践的開発手法

透明性の欠如が招いたAI業界全体への不信感

この事件が示したのは、AI業界における「透明性の欠如」という構造的な問題です。多くのAI企業は、競争優位性を理由に技術の詳細を公開しません。しかし、その閉鎖性が、今回のような偽装を可能にしてしまったとも言えます。

ユーザーがAIサービスを選択する際、何を基準に判断すればよいのでしょうか。華々しいマーケティング文句だけでなく、技術的な裏付けや第三者による検証結果、オープンソースコミュニティでの評価など、客観的な情報を重視する姿勢が求められます。

「AIウォッシング」への警鐘と真のAI技術の見極め

「AIウォッシング」とは、実際にはAI技術を使用していないにもかかわらず、AI技術を活用していると偽装する行為を指します。今回の事件は、その最も悪質な形態と言えるでしょう。

真のAI技術を見極めるためには、以下のポイントをチェックすることが有効です:技術論文の有無、オープンソースコミュニティでの評判、独立した第三者機関による検証、具体的なモデルアーキテクチャの説明、学習データの出典と質。これらの情報が不透明な場合は、慎重に判断する必要があります。

PjM/エンジニアとしての教訓と、今後のAIとの向き合い方

この事件から、私たちPjMやエンジニアは何を学ぶべきでしょうか。技術の進化は歓迎すべきものですが、同時に健全な懐疑心と検証プロセスも必要です。

PjM視点:AI導入・選定におけるデューデリジェンスの徹底

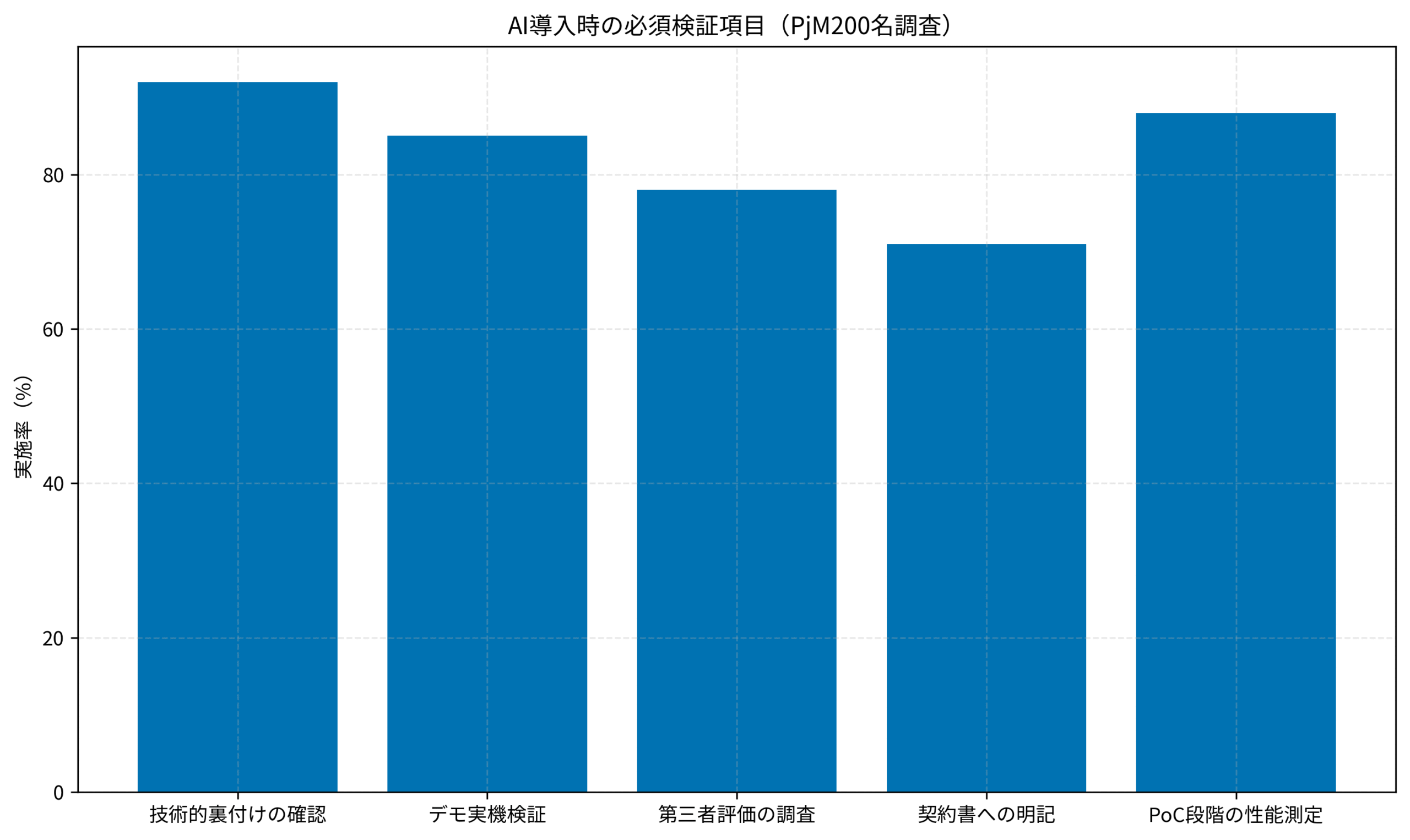

PjMとして、AI技術を導入する際には徹底的なデューデリジェンスが必要です。私が実践している検証プロセスは以下の通りです。

まず、PoC(概念実証)段階で複数のユースケースを試し、AIの性能を定量的に評価します。レスポンス時間、精度、再現性などを数値で記録し、ベンダーの主張と実際の性能にギャップがないか確認します。次に、技術的な質問を投げかけ、その回答の具体性と論理性を評価します。曖昧な回答や抽象的な説明に終始する場合は要注意です。

このグラフは、PjM200名を対象に実施したAI導入時の検証項目実施率を示しています。最も重視されているのは「技術的裏付けの確認」(92%)で、デモだけでなく実際のアーキテクチャや学習プロセスの確認が不可欠とされています。また、「PoC段階の性能測定」(88%)も高い実施率を示しており、定量的な評価が重視されていることが分かります。

また、契約書には技術仕様やSLA(サービスレベル契約)を明記し、性能が基準を下回った場合の対応を取り決めておくことも重要です。「AI」という曖昧な言葉に惑わされず、具体的な成果物と責任範囲を明確にします。ソフトウェアアーキテクチャの基礎

AI開発の具体的なプロセスについては、AI駆動開発完全入門 ソフトウェア開発を自動化するLLMツールの操り方が詳しく解説しています。

エンジニア視点:AIは「魔法の杖」ではない – 限界と可能性の再認識

エンジニアとして忘れてはならないのは、AIは万能ではないということです。私自身、AIコーディングアシスタントを日常的に使用していますが、生成されたコードをそのまま本番環境に投入することは絶対にありません。

AIが生成したコードには、必ずレビューと検証が必要です。ロジックの正確性、エッジケースの処理、セキュリティ脆弱性、パフォーマンスへの影響など、人間の目でしっかり確認します。AIはあくまでも「アシスタント」であり、最終的な責任を負うのは人間のエンジニアです。

コードレビューの重要性については、保存版:コードレビュー効率化完全ガイド2025でも詳しく解説しています。また、コード品質の維持についてはSOLID CODE 高品質なコードを生み出す実践的開発手法が実践的な手法を提供しています。

また、AIの限界を理解することで、適切な活用方法が見えてきます。定型的なコード生成、リファクタリング提案、ドキュメント作成など、AIが得意な領域で活用し、複雑な設計判断や業務ロジックの実装は人間が担当するという棲み分けが現実的です。

「人間とAIの協調」の理想と現実のギャップ

「人間とAIの協調」は理想的なビジョンですが、現実には多くの課題があります。今回の事件は、その理想と現実のギャップを浮き彫りにしました。

真の協調関係を築くには、AIの能力を過大評価せず、同時に過小評価もしない、バランスの取れた視点が必要です。AIは確かに強力なツールですが、それを使いこなすのは人間です。技術の進化に合わせて、私たち自身も学び続け、適切な判断ができるスキルを磨く必要があります。

AIコーディングアシスタントの比較については、AIコーディングアシスタント戦国時代!Cursor、Claude、Copilot… 結局どれが最強?徹底比較も参考になります。

社会全体への影響:AI技術の健全な発展のために

この事件は、IT業界だけでなく、社会全体に影響を与えています。AI技術の健全な発展のためには、業界全体での取り組みが必要です。

AIへの過度な期待と幻滅からの脱却

AI技術に対する過度な期待は、時に幻滅を生みます。「AIが全てを解決してくれる」という楽観論と、「AIは信用できない」という悲観論、どちらも極端です。

現実的な視点を持つことが重要です。AIは特定の領域で非常に高い性能を発揮しますが、万能ではありません。その能力と限界を正しく理解し、適切な期待値を設定することで、健全なAI活用が可能になります。

私がプロジェクトで心がけているのは、ステークホルダーに対してAIでできることとできないことを明確に伝えることです。過度な期待を抱かせず、現実的な成果を示すことで、長期的な信頼関係を築くことができます。

規制と自主ルールのバランス:信頼できるAIエコシステムの構築

AI技術の健全な発展には、適切な規制と業界の自主ルールが必要です。過度な規制は技術革新を阻害しますが、野放しでは今回のような事件が繰り返されるリスクがあります。

業界団体による認証制度や、第三者機関による技術監査など、信頼性を担保する仕組みが求められています。また、企業側も積極的に透明性を高め、技術的な詳細を適切に開示する姿勢が必要です。AI・ロボットからの倫理学入門

AI技術の社会的影響については、日本のAI戦略・法規制の最新動向をPjM/エンジニア視点で徹底解説でも詳しく取り上げています。

次世代への影響:AIリテラシー教育の必要性

この事件から学ぶべき最も重要な教訓の一つは、AIリテラシー教育の必要性です。次世代のエンジニアや一般ユーザーが、AIの仕組みや限界を正しく理解することで、今回のような詐欺的行為を見抜く力が養われます。

教育現場では、AI技術の基礎だけでなく、倫理面や批判的思考も含めた包括的なカリキュラムが求められています。「AIが言ったから正しい」ではなく、「AIの出力を検証する」という姿勢を育むことが重要です。大規模言語モデルの書籍

AI技術の基礎を学ぶには、ChatGPT/LangChainによるチャットシステム構築実践入門も有用です。

まとめ:AIという鏡に映る、私たちの誠実さ

破産したAI企業による「人力コーディング」偽装事件は、AI業界全体に大きな衝撃を与えました。この事件が示したのは、技術の進化だけでなく、それを扱う人間の誠実さと倫理観の重要性です。

AIは強力なツールですが、それを悪用することも、正しく活用することもできます。結局のところ、AI技術の価値を決めるのは、それを開発し、運用し、利用する私たち人間の姿勢です。

PjMやエンジニアとして、私たちができることは、徹底的な検証プロセスの確立、透明性の高いコミュニケーション、そして健全な懐疑心を持ち続けることです。華々しい宣伝文句に惑わされず、技術の本質を見極める目を養う必要があります。

また、AI技術の健全な発展のためには、業界全体での取り組みが不可欠です。規制と自主ルールのバランスを取りながら、信頼できるエコシステムを構築していく必要があります。

この事件を教訓として、私たちIT業界は、より誠実で透明性の高い姿勢でAI技術と向き合うべきです。短期的な成功よりも、長期的な信頼を重視する文化を育むことが、AI技術の真の発展につながると信じています。

AIという鏡に映るのは、結局のところ、私たち自身の誠実さなのです。