お疲れ様です!IT業界で働くアライグマです!

「Kubernetesクラスタのセキュリティ設定、どこから手をつければいいかわからない」

「コンテナ環境の脆弱性対策、本当に十分なのか不安」

「ゼロトラストアーキテクチャって、Kubernetesでどう実装するの?」

コンテナオーケストレーションの普及に伴い、Kubernetesのセキュリティ対策は企業にとって喫緊の課題です。

私のチームでも、本番環境のKubernetesクラスタで脆弱性スキャンを実施したところ、Critical レベルの問題が12件も検出され、緊急対応に追われた経験があります。

この記事では、Kubernetesクラスタのセキュリティを段階的に強化する実践的な手法と、ゼロトラストアーキテクチャを実装するための具体的な設計パターンを解説します。

特に実装の優先順位と、運用負荷とセキュリティ効果のバランスを重視した内容になっています。

Kubernetesセキュリティの現状:なぜ脆弱性対策が急務なのか

Kubernetesのセキュリティは、従来のインフラとは異なる複雑さを持っています。

2024年のセキュリティレポートによると、Kubernetesクラスタの約70%が何らかのセキュリティ設定ミスを抱えているとされています。

私が最初にKubernetesのセキュリティ監査を担当したとき、デフォルト設定のままで運用されているクラスタの多さに驚きました。

特にRBAC(Role-Based Access Control)が適切に設定されていないケースが多く、すべてのPodが過剰な権限を持っている状態でした。

Kubernetesセキュリティの主要な脅威は以下の通りです。

- 設定ミス:デフォルト設定のまま運用し、不要な権限が付与されている

- コンテナイメージの脆弱性:古いベースイメージや未パッチの依存関係を含む

- ネットワーク分離の欠如:Pod間通信が制限されず、攻撃の横展開が容易

- Secrets管理の不備:機密情報が平文で保存されている

特に問題なのは、セキュリティ対策の優先順位が不明確なことです。

すべての対策を一度に実装するのは現実的ではなく、リスクと実装コストのバランスを考慮した段階的なアプローチが必要です。

達人プログラマーで学んだ「セキュリティは後回しにできない」という原則は、Kubernetes環境でも同様に重要です。

従来のインフラでは、ファイアウォールやIDS/IPSで境界防御を行えば一定のセキュリティが確保できました。

しかし、Kubernetesのような動的なコンテナ環境では、境界が曖昧になり、ゼロトラストの考え方が不可欠です。

実際の攻撃事例では、脆弱なコンテナイメージを起点に侵入され、RBAC設定の不備を突いてクラスタ全体が侵害されるケースが報告されています。

このような多層的な攻撃に対抗するには、包括的なセキュリティ戦略が必要です。

開発環境のパフォーマンスチューニングと同様に、セキュリティも段階的な最適化が重要です。

RBAC設定とPod Security Standards:最優先で実装すべき基本対策

Kubernetesセキュリティの基盤となるのが、RBACとPod Security Standardsです。

これらは実装難易度が比較的低く、セキュリティ効果が高いため、最優先で取り組むべき対策です。

RBAC(Role-Based Access Control)の実装

RBACは、ユーザーやServiceAccountに対して最小権限の原則を適用するための仕組みです。

RBAC実装の基本ステップ:

- デフォルトServiceAccountの無効化:各Namespaceのdefault ServiceAccountに権限を付与しない

- 専用ServiceAccountの作成:アプリケーションごとに専用のServiceAccountを作成

- Roleの最小化:必要最小限のリソースとverbのみを許可

- ClusterRoleの慎重な使用:クラスタ全体に影響するClusterRoleは極力避ける

実際のプロジェクトでは、以下のようなRole定義を使用しています。

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

name: app-reader

namespace: production

rules:

- apiGroups: [""]

resources: ["pods", "services"]

verbs: ["get", "list", "watch"]

- apiGroups: ["apps"]

resources: ["deployments"]

verbs: ["get", "list"]このRole定義では、読み取り専用の権限のみを付与し、変更操作は許可していません。

ロジクール MX KEYS (キーボード)があると、YAML設定ファイルの編集作業が快適になります。

Pod Security Standards の適用

Pod Security Standards(PSS)は、Podのセキュリティ設定を3つのレベル(Privileged、Baseline、Restricted)で管理する仕組みです。

PSS実装のベストプラクティス:

- Restrictedレベルを基本とする:特別な理由がない限り、最も厳格なRestrictedレベルを適用

- Namespace単位で適用:開発環境とプロダクション環境で異なるレベルを設定

- 段階的な移行:既存アプリケーションはwarnモードで検証してから enforceモードに移行

私たちのチームでは、以下のようなNamespace設定を使用しています。

apiVersion: v1

kind: Namespace

metadata:

name: production

labels:

pod-security.kubernetes.io/enforce: restricted

pod-security.kubernetes.io/audit: restricted

pod-security.kubernetes.io/warn: restrictedこの設定により、Restrictedレベルに違反するPodはデプロイできなくなります。

NISTパスワードガイドラインと同様に、セキュリティ基準の明確化と強制が重要です。

Network PolicyとSecrets管理:データ保護の実装パターン

RBACとPSSの次に取り組むべきは、Network PolicyとSecrets管理です。

これらはデータ保護とネットワーク分離の観点で重要な対策です。

Network Policyによるマイクロセグメンテーション

Network Policyは、Pod間の通信を制御し、攻撃の横展開を防ぐための仕組みです。

Network Policy実装の基本方針:

- デフォルト拒否ポリシー:すべての通信を拒否し、必要なものだけ許可する

- Namespace単位の分離:異なるNamespace間の通信は明示的に許可が必要

- Ingress/Egressの両方を制御:受信だけでなく送信も制限する

実際のプロジェクトでは、以下のようなデフォルト拒否ポリシーを適用しています。

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: default-deny-all

namespace: production

spec:

podSelector: {}

policyTypes:

- Ingress

- Egressこのポリシーにより、明示的に許可されていない通信はすべてブロックされます。

LG Monitor モニター ディスプレイ 34SR63QA-W 34インチ 曲面 1800Rがあると、Network Policyの設定とトラフィックフローを並べて確認しやすくなります。

Secrets管理とKMS統合

Kubernetesの Secrets はデフォルトでBase64エンコードされているだけで、暗号化されていません。

本番環境では、KMS(Key Management Service)との統合が必須です。

Secrets管理のベストプラクティス:

- KMS統合:AWS KMS、Azure Key Vault、Google Cloud KMSなどと統合

- External Secrets Operator:外部のSecrets管理サービスと連携

- RBAC制限:Secretsへのアクセスを最小限のServiceAccountに制限

- ローテーション:定期的なSecrets更新の自動化

私たちのチームでは、External Secrets Operatorを使ってAWS Secrets Managerと統合しています。

apiVersion: external-secrets.io/v1beta1

kind: ExternalSecret

metadata:

name: db-credentials

namespace: production

spec:

refreshInterval: 1h

secretStoreRef:

name: aws-secrets-manager

kind: SecretStore

target:

name: db-secret

data:

- secretKey: password

remoteRef:

key: prod/db/passwordこの設定により、Secrets は AWS Secrets Manager で管理され、1時間ごとに自動更新されます。

MCPを活用したコード実行でも触れましたが、機密情報の適切な管理は開発の基本です。

コンテナイメージスキャンとランタイムセキュリティ:継続的な脆弱性管理

静的な設定だけでなく、コンテナイメージの脆弱性管理とランタイムでの異常検知も重要です。

コンテナイメージスキャンの自動化

コンテナイメージの脆弱性は、CI/CDパイプラインで自動的にスキャンする必要があります。

イメージスキャンの実装ポイント:

- ビルド時スキャン:Docker buildの直後にTrivyやGrypeでスキャン

- レジストリスキャン:コンテナレジストリ側でも継続的にスキャン

- 重大度による制御:Critical/High の脆弱性があればデプロイをブロック

- ベースイメージの定期更新:月次でベースイメージを最新化

実際のCI/CDパイプラインでは、以下のようなスキャンステップを追加しています。

- name: Scan image

run: |

trivy image --severity HIGH,CRITICAL --exit-code 1 myapp:latestこのステップにより、High以上の脆弱性が検出された場合、パイプラインが失敗します。

Playwright Test Agent実践でも触れましたが、CI/CDパイプラインへのセキュリティチェック組み込みは必須です。

ランタイムセキュリティとFalco

ランタイムでの異常検知には、Falcoなどのツールが有効です。

Falco実装のベストプラクティス:

- カスタムルール:アプリケーション固有の異常パターンを定義

- アラート統合:Slack、PagerDutyなどと連携して即座に通知

- 監査ログ連携:Kubernetesの監査ログと組み合わせて分析

私たちのチームでは、以下のようなFalcoルールを使用しています。

- rule: Unauthorized Process in Container

desc: Detect unexpected process execution

condition: >

spawned_process and

container and

not proc.name in (node, npm, python)

output: >

Unexpected process in container

(user=%user.name command=%proc.cmdline container=%container.name)

priority: WARNINGこのルールにより、想定外のプロセスが実行された場合に即座にアラートが発生します。

オカムラ シルフィー (オフィスチェア)があると、長時間のセキュリティ監視作業でも疲れにくくなります。

ゼロトラストアーキテクチャ実装:Service MeshとmTLS

Kubernetesでゼロトラストを実現するには、Service MeshによるmTLS(mutual TLS)の実装が効果的です。

Service Meshの選択と導入

Service Meshは、Pod間通信の暗号化と認証を自動化します。

主要なService Meshには、Istio、Linkerd、Ciliumなどがあります。

Service Mesh選択の基準:

- パフォーマンス:Linkerdは軽量で低レイテンシ、Istioは機能豊富だが重い

- 運用負荷:Ciliumは eBPF ベースで高性能だが、カーネル要件が厳しい

- 既存環境との親和性:すでにEnvoyを使っている場合はIstioが有利

私たちのチームでは、運用負荷とパフォーマンスのバランスからLinkerdを選択しました。

LG Monitor モニター ディスプレイ 34SR63QA-W 34インチ 曲面 1800Rがあると、Service Meshのトラフィック可視化ダッシュボードを快適に確認できます。

mTLSの段階的な導入

mTLSは一度にすべてのサービスに適用するのではなく、段階的に導入します。

mTLS導入のステップ:

- Permissiveモード:mTLSと平文の両方を許可し、動作確認

- Strictモード:mTLSのみを許可し、平文通信を拒否

- 監視と調整:レイテンシやエラー率を監視し、問題があれば調整

実際のプロジェクトでは、以下のようなLinkerd設定を使用しています。

apiVersion: policy.linkerd.io/v1beta1

kind: Server

metadata:

name: app-server

namespace: production

spec:

podSelector:

matchLabels:

app: myapp

port: 8080

proxyProtocol: TLSこの設定により、指定されたPodへの通信はすべてmTLSで暗号化されます。

LangChain 1.0 AIエージェント実装と同様に、段階的な移行戦略が成功の鍵です。

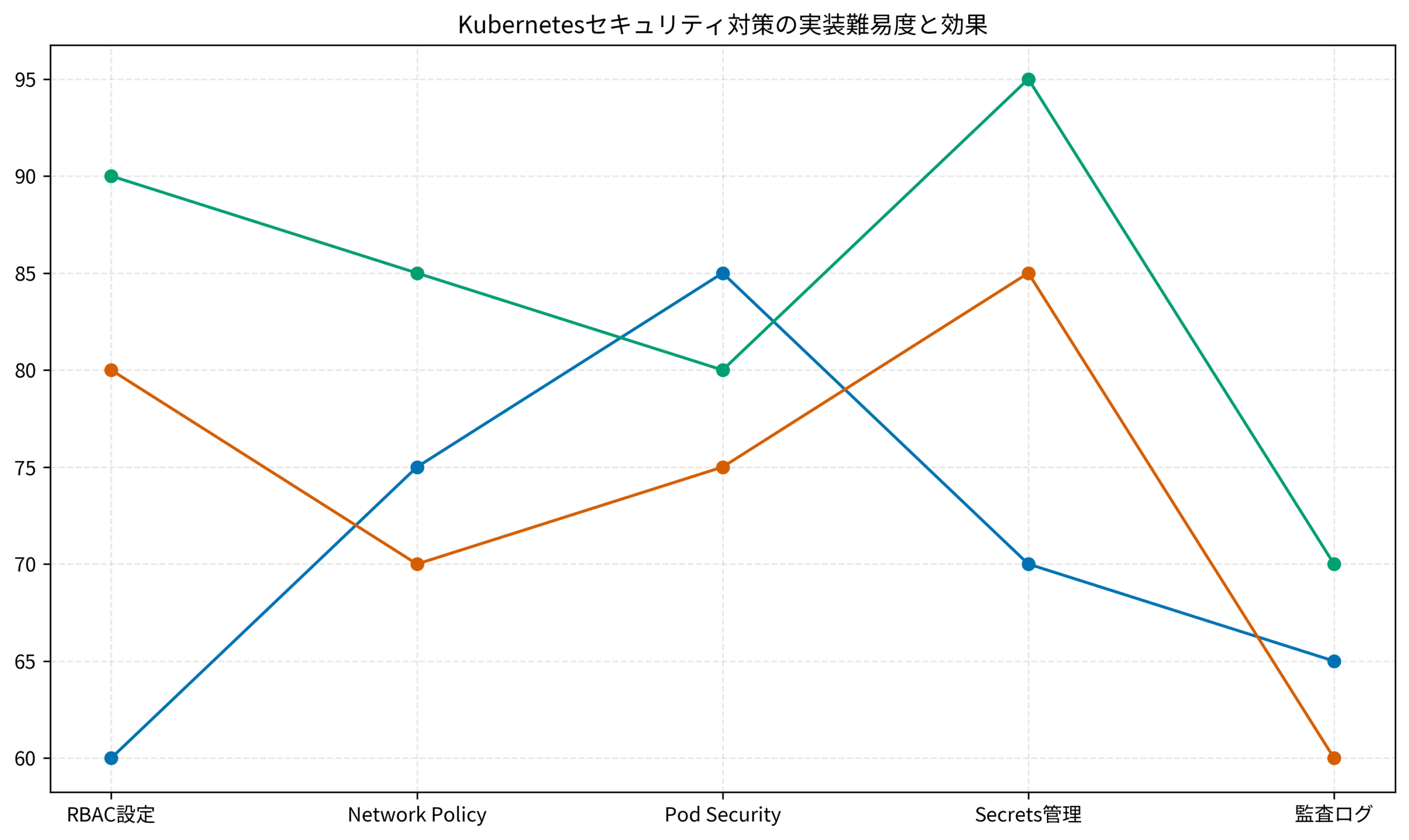

以下のグラフは、主要なセキュリティ対策の実装難易度、セキュリティ効果、運用負荷を比較したものです。

監査ログと継続的なコンプライアンス:運用フェーズのセキュリティ

セキュリティ対策は実装して終わりではなく、継続的な監視とコンプライアンス確認が必要です。

Kubernetes監査ログの活用

Kubernetes監査ログは、クラスタ内のすべてのAPI操作を記録します。

監査ログ活用のベストプラクティス:

- ログレベルの調整:Metadata、Request、RequestResponseの3レベルを使い分け

- 外部ストレージへの転送:CloudWatch Logs、Elasticsearch などに転送

- 異常検知:機械学習ベースの異常検知ツールと連携

- 定期的なレビュー:週次で権限昇格や異常なAPI呼び出しを確認

実際のプロジェクトでは、以下のような監査ポリシーを使用しています。

apiVersion: audit.k8s.io/v1

kind: Policy

rules:

- level: RequestResponse

verbs: ["create", "update", "patch", "delete"]

resources:

- group: ""

resources: ["secrets", "configmaps"]

- level: Metadata

omitStages:

- RequestReceivedこのポリシーにより、Secretsの変更操作は詳細に記録され、その他の操作はメタデータのみ記録されます。

コンプライアンススキャンの自動化

CIS Kubernetes Benchmarkなどの基準に対するコンプライアンスチェックを自動化します。

コンプライアンススキャンツール:

- kube-bench:CIS Benchmarkに基づいたスキャン

- Polaris:ベストプラクティスチェック

- OPA Gatekeeper:ポリシーベースの制御

私たちのチームでは、kube-benchを週次で実行し、スコアを監視しています。

kubectl apply -f https://raw.githubusercontent.com/aquasecurity/kube-bench/main/job.yaml

kubectl logs -f job/kube-benchこのコマンドにより、クラスタのセキュリティ設定が CIS Benchmark に準拠しているかチェックできます。

達人プログラマーで学んだ「自動化できるものは自動化する」という原則は、セキュリティ運用でも重要です。

乱雑なコードの整理から学ぶPjMの設計レビュー術と同様に、定期的なセキュリティレビューが品質維持の鍵です。

まとめ

Kubernetesのセキュリティ強化は、段階的かつ継続的なプロセスです。

特にRBAC、Pod Security Standards、Network Policy、Secrets管理の4つは、最優先で実装すべき基本対策です。

セキュリティ対策を実装する際は、以下のポイントを押さえてください。

- RBAC と Pod Security Standards を最優先で実装し、最小権限の原則を徹底する

- Network Policy でマイクロセグメンテーションを実現し、攻撃の横展開を防ぐ

- Secrets は KMS と統合し、暗号化と自動ローテーションを実装する

- コンテナイメージスキャンを CI/CD パイプラインに組み込み、脆弱性を早期発見

- Service Mesh で mTLS を実装し、ゼロトラストアーキテクチャを実現する

- 監査ログとコンプライアンススキャンを自動化し、継続的なセキュリティ確保

Kubernetesセキュリティは、一度設定すれば終わりではありません。

新しい脆弱性の発見、アプリケーションの変更、組織のポリシー変更に応じて、継続的に見直しと改善が必要です。

実際の運用では、セキュリティ対策の実装難易度と効果を見極め、優先順位をつけて段階的に進めることが重要です。

まずは RBAC と Pod Security Standards から始め、徐々に高度な対策を追加していきましょう。