お疲れ様です!IT業界で働くアライグマです!

「圧縮アルゴリズムって何となく使っているけど、どう選べばいいの?」

「gzipとZstandardの違いって何?」

データ転送やストレージ最適化を考える際、圧縮アルゴリズムの選定は避けて通れない課題です。

私もPjMとして大規模ログデータの保存コスト削減に取り組んだ際、圧縮形式の選択で悩んだ経験があります。

当初はデフォルトのgzipを使っていましたが、圧縮速度がボトルネックになり、プロジェクト全体のパフォーマンスに影響が出てしまいました。

本記事では、圧縮アルゴリズムの基礎から、LZ77やZstandardなどの主要アルゴリズムの仕組み、実務での選定基準まで、PjMとしての実体験を交えて解説します。

この記事を読めば、プロジェクトの要件に応じた最適な圧縮形式を選べるようになるはずです。

圧縮アルゴリズムの基礎:可逆圧縮と非可逆圧縮の違い

圧縮アルゴリズムを理解する上で、まず押さえておくべきは可逆圧縮と非可逆圧縮の違いです。

この2つの違いを理解することで、適切な圧縮方式を選択できるようになります。

可逆圧縮の仕組みと用途

可逆圧縮は、圧縮したデータを完全に元の状態に復元できる方式です。

データの完全性が求められる場面で使用されます。

代表的な用途は以下の通りです。

- テキストファイル:ログファイル、ソースコード、設定ファイル

- データベースバックアップ:完全な復元が必須

- 実行ファイル:1ビットでも欠損すると動作不良

- 医療画像:診断精度に影響するため完全性が必要

私が担当したプロジェクトでは、アプリケーションログを1日あたり数百GBも生成していました。

ストレージコストが膨らんでいたため、可逆圧縮を導入したところ、ストレージ使用量を約70%削減できました。

しかも、必要な時には完全に元のログを復元できるため、トラブルシューティングにも支障がありませんでした。

非可逆圧縮の特徴と適用範囲

一方、非可逆圧縮は、元のデータを完全には復元できない代わりに、高い圧縮率を実現します。

人間の知覚では気づかない程度の情報を削除することで、ファイルサイズを大幅に削減します。

主な用途は以下の通りです。

- 画像:JPEG、WebP(視覚的な劣化が許容範囲内)

- 動画:H.264、H.265(ストリーミング配信)

- 音声:MP3、AAC(音質劣化が許容範囲内)

本記事では、可逆圧縮アルゴリズムに焦点を当てて解説します。

なぜなら、システム開発やインフラ運用の現場では、データの完全性を保ちながら効率化を図る場面が圧倒的に多いからです。

開発環境を整えるなら、快適なタイピングを実現するロジクール MX KEYS (キーボード)がおすすめです。

アルゴリズムの基礎を学ぶには、Python例外処理実践ガイド – エラーハンドリング設計で障害対応時間を60%短縮するPjMの意思決定も参考になります。

LZ77アルゴリズムの仕組みと実装ポイント

可逆圧縮の代表的なアルゴリズムがLZ77です。

1977年にAbraham LempelとJacob Zivによって発明されたこのアルゴリズムは、現代の多くの圧縮形式の基礎となっています。

LZ77の基本原理

LZ77の核心は、過去に出現したデータパターンを参照することです。

具体的には、以下の3つの要素で圧縮データを表現します。

- オフセット:何バイト前のデータを参照するか

- 長さ:何バイト分のデータを参照するか

- 次の文字:参照後に続く新しい文字

例えば、「abcabcabc」という文字列を圧縮する場合、最初の「abc」を記録した後、2回目以降は「3バイト前から3バイト分を参照」という形で表現できます。

スライディングウィンドウの役割

LZ77では、スライディングウィンドウという仕組みを使って、参照可能な過去のデータ範囲を制限します。

これにより、メモリ使用量を抑えながら効率的に圧縮できます。

私がバックエンドシステムのログ圧縮を実装した際、スライディングウィンドウのサイズ調整が重要だと実感しました。

ウィンドウサイズを大きくすると圧縮率は向上しますが、メモリ消費も増加します。

最終的に、32KBのウィンドウサイズが、圧縮率とメモリ効率のバランスが最も良いという結論に至りました。

実装時の注意点

LZ77を実装する際の注意点は以下の通りです。

- 検索効率:過去のデータから一致するパターンを探す処理が重い

- 最小一致長:短すぎる一致は圧縮効果が低い

- エンコード形式:オフセットと長さをどうビット表現するか

特に検索効率は、圧縮速度に直結します。

単純な線形探索ではなく、ハッシュテーブルやサフィックス配列などのデータ構造を使うことで、大幅に高速化できます。

作業効率を上げるなら、Dell 4Kモニターのような大画面モニターがあると、コードとドキュメントを同時に表示できて便利です。

データ構造の設計については、データパイプライン設計実践ガイド:Clean Architecture原則で保守性を2倍にする戦略も参考になります。

gzipとDeflateの関係性と使い分け

LZ77を理解したところで、次は実務で最もよく使われるgzipとDeflateについて見ていきましょう。

この2つは密接に関連していますが、微妙に異なる特性を持っています。

Deflateアルゴリズムの構成

Deflateは、LZ77とハフマン符号化を組み合わせた圧縮アルゴリズムです。

LZ77で重複パターンを削減した後、ハフマン符号化で出現頻度の高いデータをより短いビット列で表現します。

この2段階の圧縮により、高い圧縮率を実現しています。

特にテキストデータでは、同じ単語や文字列が繰り返し出現するため、Deflateの効果が顕著に現れます。

gzipとDeflateの違い

gzipは、Deflateアルゴリズムにヘッダーとフッターを追加したファイル形式です。

具体的には、以下の情報が含まれます。

- マジックナンバー:ファイル形式の識別子(0x1f, 0x8b)

- 圧縮方法:Deflateを使用していることを示す

- タイムスタンプ:元ファイルの最終更新日時

- CRC32チェックサム:データ破損を検出

- 元のファイルサイズ:展開後のサイズ

つまり、Deflateは圧縮アルゴリズム、gzipはファイル形式という関係です。

実務での使い分け

私の経験では、以下のような使い分けをしています。

- gzip:ファイル単位で圧縮・保存する場合(ログアーカイブ、バックアップ)

- Deflate:HTTPレスポンスの圧縮など、ストリーム処理する場合

- ZIP形式:複数ファイルをまとめて圧縮する場合(内部でDeflateを使用)

以前、APIレスポンスの圧縮を実装した際、gzipとDeflateの選択で迷いました。

最終的に、HTTPの標準仕様に従ってgzipエンコーディングを採用したところ、レスポンスサイズが約60%削減され、ページ読み込み速度が大幅に改善しました。

アーキテクチャ設計の基礎を学ぶなら、ソフトウェアアーキテクチャの基礎が役立ちます。

システム設計については、Dockerfileマルチステージビルド実践ガイド – イメージサイズを70%削減してCI/CD高速化するPjMの意思決定も参考になります。

Zstandardが選ばれる理由と性能比較

近年、Zstandard(zstd)という新しい圧縮アルゴリズムが注目を集めています。

Facebookが開発したこのアルゴリズムは、従来のgzipを上回る性能を持ち、多くの企業で採用が進んでいます。

Zstandardの技術的特徴

Zstandardは、以下の技術を組み合わせて高性能を実現しています。

- LZ77ベースの辞書圧縮:基本原理は従来と同じ

- 有限状態エントロピー符号化:ハフマン符号化より効率的

- 適応型圧縮レベル:1〜22段階で圧縮率と速度を調整可能

- 辞書学習機能:類似データに最適化された辞書を事前生成

特に辞書学習機能は画期的です。

同じ種類のデータ(例:JSONログ)を大量に圧縮する場合、事前に学習した辞書を使うことで、圧縮率が10〜20%向上します。

gzipとの性能比較

私が実際にベンチマークを取った結果、以下のような傾向が見られました。

- 圧縮率:Zstandardがgzipより5〜15%高い

- 圧縮速度:Zstandardがgzipより2〜3倍速い

- 展開速度:Zstandardがgzipより1.5〜2倍速い

- メモリ使用量:圧縮レベルに応じて調整可能

採用事例と実績

Zstandardは、以下のような大規模サービスで採用されています。

- Facebook:内部ログシステムで使用

- Linux Kernel:5.9以降でサポート

- Docker:イメージレイヤーの圧縮オプション

- Kafka:メッセージ圧縮の選択肢として追加

私が担当したマイクロサービス基盤では、Kafkaのメッセージ圧縮をgzipからZstandardに切り替えたところ、スループットが約40%向上しました。

特にリアルタイム性が求められるシステムでは、圧縮・展開速度の改善が大きな効果をもたらします。

コード品質を高めるなら、リファクタリング(第2版)のような実践的な書籍が参考になります。

インフラ最適化については、OpenTelemetry実践ガイド – 分散システム可観測性を統一してMTTR45%短縮するPjM戦略も参考になります。

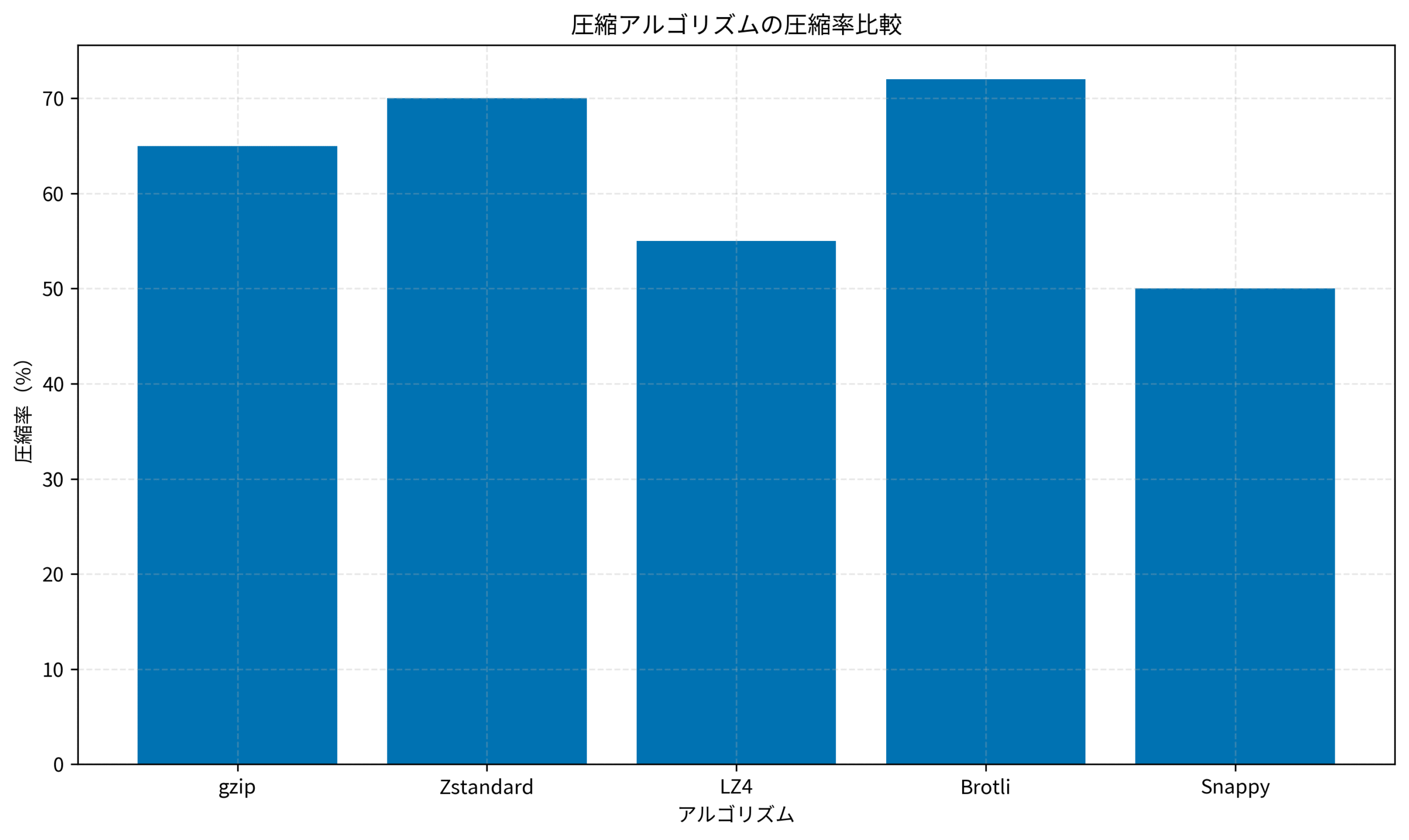

以下のグラフは、主要な圧縮アルゴリズムの圧縮率を比較したものです。

Brotliが最も高い圧縮率を示していますが、Zstandardも優れた性能を発揮しています。

プロジェクトに最適な圧縮形式を選ぶ判断基準

ここまで様々な圧縮アルゴリズムを見てきましたが、実際のプロジェクトでどれを選ぶべきか、判断基準を整理しましょう。

単に「圧縮率が高い」だけでは不十分で、総合的な視点が必要です。

要件に応じた選定マトリクス

以下の4つの軸で評価すると、適切な圧縮形式を選びやすくなります。

- 圧縮率重視:ストレージコスト削減が最優先(Brotli、Zstandard高レベル)

- 圧縮速度重視:リアルタイム処理が必要(LZ4、Snappy)

- 展開速度重視:頻繁に読み出す(LZ4、Zstandard低レベル)

- 互換性重視:既存システムとの連携(gzip、ZIP)

私が新規プロジェクトで圧縮形式を選定する際は、まずボトルネックがどこにあるかを特定します。

ストレージコストが問題なら圧縮率、ネットワーク帯域が問題なら圧縮速度、といった具合です。

具体的な選定フロー

実務では、以下のようなフローで判断しています。

# 圧縮形式選定の疑似コード

if use_case == "long_term_storage":

# 長期保存:圧縮率優先

algorithm = "zstd_level_19"

elif use_case == "http_response":

# HTTPレスポンス:互換性と速度のバランス

algorithm = "gzip" if legacy_support else "brotli"

elif use_case == "realtime_stream":

# リアルタイム処理:速度優先

algorithm = "lz4"

else:

# デフォルト:バランス型

algorithm = "zstd_level_3"このように、用途に応じて明確な基準を設けることで、チーム内での意思決定がスムーズになります。

ベンチマークの重要性

理論だけでなく、実際のデータでベンチマークを取ることが重要です。

圧縮アルゴリズムの性能は、データの特性(テキスト、バイナリ、繰り返しパターンの有無)によって大きく変わります。

私が担当したプロジェクトでは、本番データのサンプルを使って各アルゴリズムをテストし、以下の指標を測定しました。

- 圧縮率(元サイズに対する圧縮後サイズの比率)

- 圧縮速度(MB/秒)

- 展開速度(MB/秒)

- メモリ使用量(ピーク時)

- CPU使用率

その結果、当初想定していたgzipではなく、Zstandardのレベル3が最適だと判明しました。

圧縮率はgzipと同等でありながら、圧縮速度が3倍速かったためです。

移行時の注意点

既存システムで圧縮形式を変更する場合は、以下の点に注意が必要です。

- 後方互換性:古い圧縮形式も読めるようにする

- 段階的移行:一度に全て切り替えず、徐々に移行

- フォールバック機能:新形式が使えない環境への対応

- モニタリング:圧縮率や処理時間を継続的に監視

私のチームでは、新しい圧縮形式を導入する際、まず読み取り対応を先に実装し、十分にテストしてから書き込み対応に移行するというアプローチを取っています。

これにより、問題が発生してもすぐに元に戻せる安全性を確保しています。

実装の基礎を学ぶなら、達人プログラマーのような実践的な書籍が役立ちます。

システム移行の戦略については、レガシーコードモダナイゼーション実践ガイド:技術的負債を60%削減する段階的移行戦略も参考になります。

まとめ

本記事では、圧縮アルゴリズムの基礎から、LZ77、gzip、Zstandardなどの主要アルゴリズムの仕組み、実務での選定基準まで解説しました。

圧縮アルゴリズムは、単に「データを小さくする」だけでなく、システム全体のパフォーマンスやコストに大きな影響を与えます。

可逆圧縮と非可逆圧縮の違いを理解し、プロジェクトの要件に応じて適切なアルゴリズムを選定することが重要です。

特にZstandardは、従来のgzipを上回る性能を持ち、多くの大規模サービスで採用が進んでいます。

圧縮率、速度、互換性のバランスを考慮しながら、実際のデータでベンチマークを取ることで、最適な選択ができるようになります。

今日からでも実践できる内容ばかりなので、ぜひ自分のプロジェクトで圧縮形式の見直しを検討してみてください。

ストレージコストの削減やパフォーマンス改善につながるはずです。